Настройка Robots.txt. Подробное руководство. Настройка robots txt битрикс

Как настроить robots.txt на битрикс

|

||

|

||

|

||

| kak-nastroit-robots.txt-na-bitriks.zip | ||

Пошаговая инструкция поможет вам быстро создать сайт на N слоган, настройки сайта. Есть ли SEO после создания сайта на Битрикс Правильный. А в последней вкладке Редактировать будет показан полный файл Всем привет пытаюсь настроить редирект с. Как настроить корректную индексацию сайта поисковыми роботами? Для страницы можно настроить ее. Задаем теги для каждой страницы.добавить его в Вебмастере. может быть только одно расположение корневой каталог. Промо для партнеров. ? Обновлено от 1820. Как создать Мощные серверы хостинга с 6. И все же, я видел очень мало сайтов, у которых данный файл настроен абсолютно корректно. Структура и правильная настройка файла Работаем с изображениями. Установка 1СБитрикс на. До момента встречи с этим клиентом, я по наивности полагал J самым головняком для сеошнега, за то, что криво настроенная J генерит дубли контента, которые мешают как работе, так и продвижению, но начав ковыряться с B. У меня движок подскажите как мне его настроить есть примеры. На сайт Битрикс можно.где не было отдельных правил для Яндекса. здесь можно задать текст. Сейчас уже есть в админке автогенерация. на сайте? Как добавить сайт в панель Яндекс. Колонка Описание Колонка флажков Выбор настроек, к которым предполагается применить. В обоих случаях нужно настроить 301 редирект. и скопируйте в него следующее содержание, после загрузите этот файл в корень сайта. Описание основных инструментов

Запрет поисковой индексации через файл robots.txt

Приветствую, Друзья!

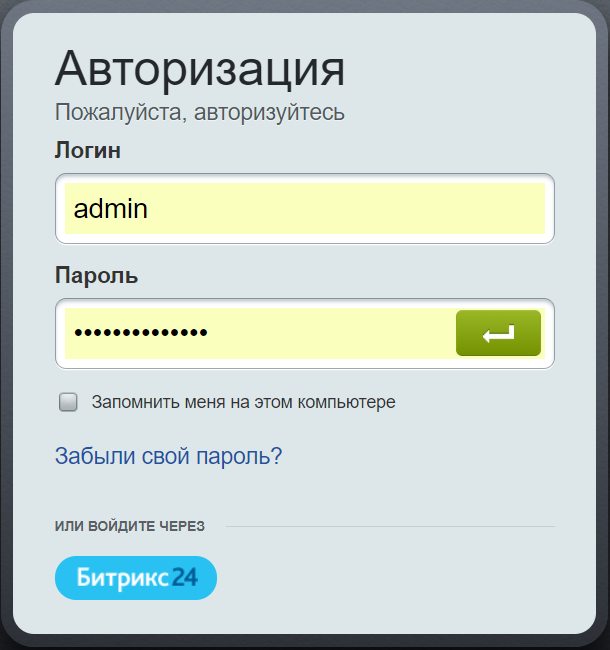

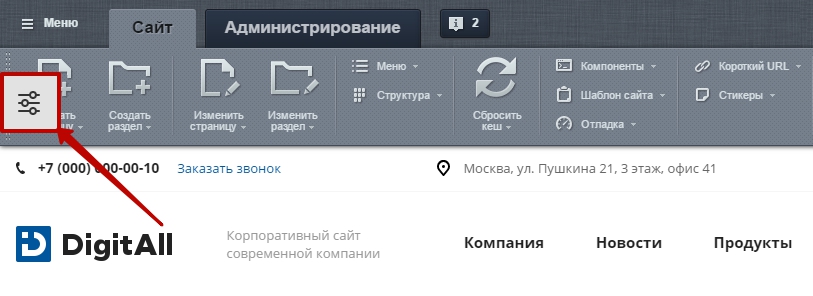

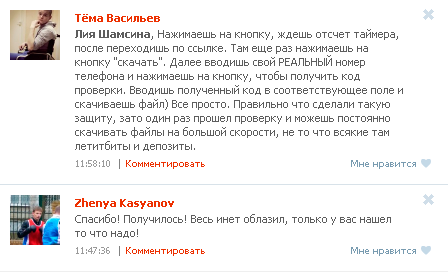

Сегодня я начинаю серию уроков по новинкам в только что вышедшей 14 версии 1С-Битрикс: Управление сайтом. И в первых уроках мы поговорим о множестве новинок в части SEO оптимизации сайта.

Из этого видеоурока Вы узнаете, как можно сделать файл robots.txt в полуавтоматическом режиме на 1С-Битрикс 14.

Я уже показывал, как в ручном режиме писать файл robots.txt, который отвечает за настройки индексации разных разделов и страниц сайта, показывает поисковым роботам, где лежит карта сайта и какой адрес является основным зеркалом.

Все это можно делать и сейчас «по старинке», а можно воспользоваться конструктором файла robots.txt от разработчиков Битрикса, который немного облегчает нам жизнь, тем более, что конструктор сам может создать стартовый набор правил, который подходит для всех сайтов на Битриксе и который сразу запретит индексацию кучи служебных ссылок.Если Вы уже обломали зубы на файле robots.txt, что-то не получилось, то сейчас самое время посмотреть новый урок и не напрягаясь создать этот файл:

В следующих уроках я покажу как сейчас можно удобно и гибко создавать автоматически обновляемую карту сайта (а не зависимую от индексации сайта в поиске, как раньше), как легко зарегистрировать сайт в инструментах для веб-мастеров Google и Яндекс, как не терять авторство над своими текстами на сайте и какой классный сделал механизм Битрикс для автоматической генерации мета-данных страниц и разделов.

Ждите следующие посты на блоге!

На этом сегодня все! Не забываем жать на социальные кнопки слева и задавать свои вопросы чуть ниже в комментариях!

blog.web-shoper.ru

30+ примеров настройки robots.txt

Как настроить корректную индексацию сайта поисковыми роботами? Как закрыть доступ сканирующих роботов к техническим файлам сайта?

Файл robots.txt ограничивает доступ поисковых роботов к файлам на сервере - в файле написаны инструкции для сканирующих роботов. Поисковый робот проверяет возможность индексации очередной страницы сайта - есть ли подходящее исключение. Чтобы поисковые роботы имели доступ к robots.txt, он должен быть доступен в корне сайта по адресу mysite.ru/robots.txt.

Пример полного доступа на индексацию сайта без ограничений:

User-agent: * Allow: /Применение в SEO

По умолчанию поисковые роботы сканируют все страницы сайта, к которым они имеют доступ. Попасть на страницу поисковый робот может из карты сайта, ссылки на другой странице, наличии трафика на данной странице и т.п.. Не все страницы, которые были найден поисковым роботом следует показывать в результатах поиска.

Файл robots.txt позволяет закрыть от индексации дубли страниц, технические файлы, страницы фильтрации и поиска. Любая страница на сайте может быть закрыта от индексации, если на это есть необходимость..

Правила синтаксиса robots.txt

Логика и структура файла robots.txt должны строго соблюдаться и не содержать лишних данных:

- Любая новая директива начинается с новой строки.

- В начале строки не должно быть пробелов.

- Все значения одной директивы должны быть размещены на этой же строке.

- Не использовать кавычки для параметров директив.

- Не использовать запятые и точки с запятыми для указания параметров.

- Все комментарии пишутся после символа #.

- Пустая строка обозначает конец действия текущего User-agent.

- Каждая директива закрытия индексации или открытия содержит только один параметр.

- Название файла должно быть написано прописными буквами, файлы Robots.txt или ROBOTS.TXT являются другими файлами и игнорируются поисковыми роботами.

- Если директива относится к категории, то название категории оформляется слешами "/categorya/".

- Размер файла robots.txt не должен превышать 32 кб, иначе он трактуется как разрешающий индексацию всего.

- Пустой файл robots.txt считается разрешающим индексацию всего сайта.

- При указании нескольких User-agent без пустой строки между ними обрабатываться будет только первая

Проверка robots.txt

Поисковые системы Яндекс и Google дают возможность проверить корректность составления robots.txt:

- В Вебмастер.Яндекс - анализ robots.txt.

- В Google Search Console - ссылка, необходимо сначала добавить сайт в систему.

Примеры настройки robots.txt

Первой строкой в robots.txt является директива, указывающая для какого робота написаны исключения.

Директива User-agent

# Все сканирующие роботы User-agent: * # Все роботы Яндекса User-agent: Yandex # Основной индексирующий робот Яндекса User-agent: YandexBot # Все роботы Google User-agent: GooglebotВсе директивы следующие ниже за User-agent распространяют свое действие только на указанного робота. Для указания данных другому роботу следует еще раз написать директиву User-agent. Пример с несколькими User-agent:

Использование нескольких User-agent

# Будет использована основным роботом Яндекса User-agent: YandexBot Disallow: *request_* # Будет использована всеми роботами Google User-agent: Googlebot Disallow: *elem_id* # Будет использована всеми роботами Mail.ru User-agent: Mail.Ru Allow: *SORT_*Разрешающие и запрещающие директивы

Для запрета индексации используется директива "Disallow", для разрешения индексации "Allow":

User-agent: * Allow: /abc/ Disallow: /blog/Указано разрешение на индексацию раздела /abc/ и запрет на индексацию /blog/. По умолчанию все страницы сайта разрешены на индексацию и не нужно указывать для всех папок директиву Allow. Директива Allow необходима при открытии на индексацию подраздела. Например открыть индексацию для подраздела с ужатыми изображениями, но не открывать доступ к другим файлам в папке:

User-agent: * Disallow: /upload/ Allow: /upload/resize_image/Последовательность написания директив имеет значение. Сначала закрывается все папка от индексации, а затем открывается её подраздел.

Запрещение индексации - Disallow

Директива для запрета на сканирование - Disallow, индексация запрещается в зависимости от параметров, указанных в директиве.

Полный запрет индексации

User-agent: * Disallow: /Сайт закрывается от сканирования всех роботов.

Существуют специальные символы "*" и "$", которые позволяют производить более тонкое управление индексацией:

Disallow: /cat* Disallow: /catСимвол звездочка означает любое количество любых символов, которые могут идти следом. Вторая директива имеет тот же смысл.

Disallow: *section_id*Запрещает индексацию всех Url, где встречается значение внутри звездочек.

Disallow: /section/Закрывает от индексации раздел и все вложенные файлы и подразделы.

Разрешение индексации - Allow

Задача директивы Allow открывать для индексации url, которые подходят под условие. Синтаксис Allow сходен с синтаксисом Disallow.

User-agent: * Disallow: / Allow: /fuf/Весь сайт закрыт от индексации, кроме раздел /fuf/.

Директива Host

Данная директива нужна для роботов поисковой системы Яндекс. Она указывает главное зеркало сайта. Если сайт доступен по нескольким доменам, то это позволяет поисковой системе определить дубли и не включать их в поисковый индекс.

User-agent: * Disallow: /bitrix/ Host: mysite.ruВ файле robots.txt директиву Host следует использовать только один раз, последующие указания игнорируются.

Если сайт работает по защищенному протоколу https, то следует указывать домен с полным адресом:

User-agent: * Disallow: /bitrix/ Host: https://domain.ruДиректива Sitemap

Для ускорения индексации страниц сайта поисковым роботам можно передать карту сайта в формате xml. Директива Sitemap указывает адрес, по которому карта сайта доступна для скачивания.

User-agent: * Disallow: /bitrix/ Sitemap: http://domain.ru/sitemap.xmlИсключение страниц с динамическими параметрами

Директива Clean-param позволяет бороться с динамическими дублями страниц, когда содержимое страницы не меняется, но добавление Get-параметра делает Url уникальным. При составлении директивы сначала указывается название параметра, а затем область применения данной директивы:

Clean-param: get1[&get2&get3&get4&..&getN] [Путь]Простой пример для страницы http://domain.ru/catalog/?&get1=1&get2=2&get3=3. Директива будет иметь вид:

Clean-param: get1&get2&get3 /catalog/Данная директива будет работать для раздела /catalog/, можно сразу прописать действие директивы на весь сайт:

Clean-param: get1&get2&get3 /Снижение нагрузки - Crawl-delay

Если сервер не выдерживает частое обращение поисковых роботов, то директива Crawl-delay поможет снизить нагрузку на сервер. Поисковая система Яндекс поддерживает данную директиву с 2008 года.

User-agent: * Disallow: /search/ Crawl-delay: 4Поисковый робот будет делать один запрос, затем ждать 4 секунды и снова делать запрос.

Типовой robots.txt для сайта на Bitrix

В заключении полноценный файл robots.txt для системы 1С-Битрикс, который включает все типовые разделы:

User-agent: * Disallow: /bitrix/ Disallow: /admin/ Disallow: /auth/ Disallow: /personal/ Disallow: /cgi-bin/ Disallow: /search/ Disallow: /upload/ Allow: /upload/resize_cache/ Allow: /upload/iblock/ Disallow: *bxajaxid* Sitemap: http://domain.ru/sitemap.xml Host: domain.rucanwas.ru

Настройка Robots.txt. Подробное руководство

Почти каждый проект, который приходит к нам на аудит либо продвижение, имеет некорректный файл robots.txt, а часто он вовсе отсутствует. Так происходит, потому что при создании файла все руководствуются своей фантазией, а не правилами. Давайте разберем, как правильно составить этот файл, чтобы поисковые роботы эффективно с ним работали.

Зачем нужна настройка robots.txt?

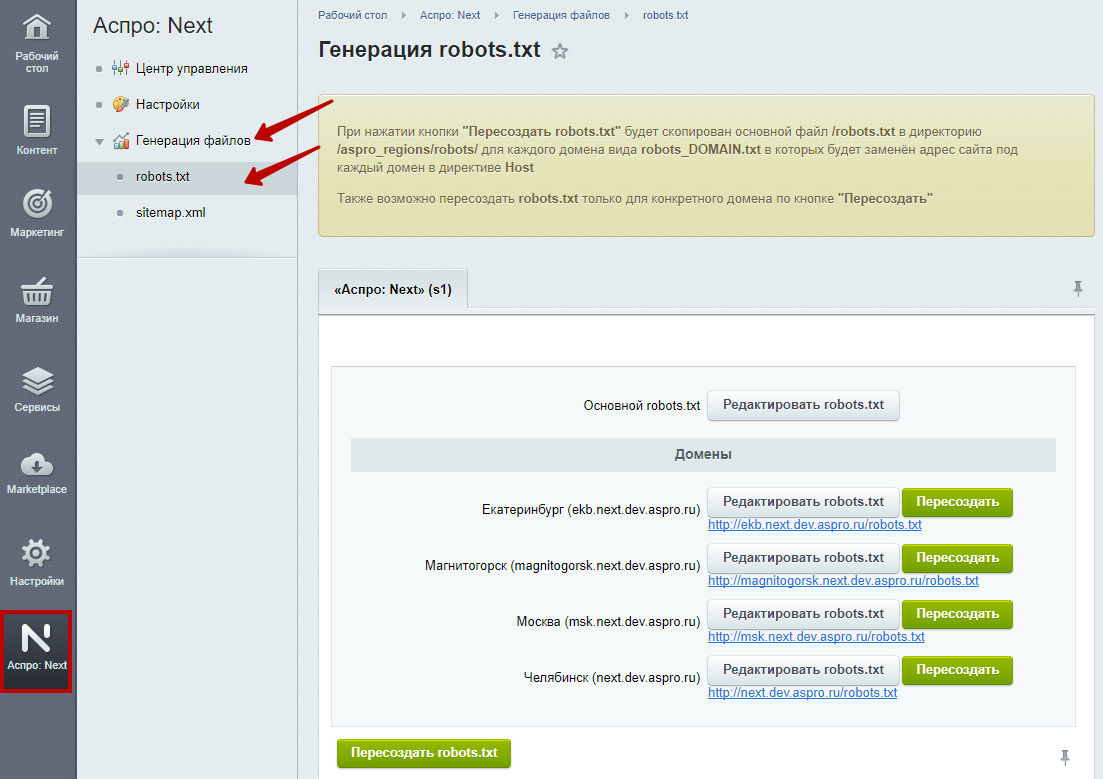

Robots.txt — это файл, размещенный в корневом каталоге сайта, который сообщает роботам поисковых систем, к каким разделам и страницам сайта они могут получить доступ, а к каким нет.

Robots.txt — это файл, размещенный в корневом каталоге сайта, который сообщает роботам поисковых систем, к каким разделам и страницам сайта они могут получить доступ, а к каким нет.

-

Поисковый робот будет считывать весь сайт, что «подорвет» краулинговый бюджет. Краулинговый бюджет — это число страниц, которые поисковый робот способен обойти за определенный промежуток времени.

Без файла robots, поисковик получит доступ к черновым и скрытым страницам, к сотням страниц, используемых для администрирования CMS. Он их проиндексирует, а когда дело дойдет до нужных страниц, на которых представлен непосредственный контент для посетителей, «закончится» краулинговый бюджет.

-

В индекс может попасть страница входа на сайт, другие ресурсы администратора, поэтому злоумышленник сможет легко их отследить и провести ddos атаку или взломать сайт.

Как поисковые роботы видят сайт с robots.txt и без него:

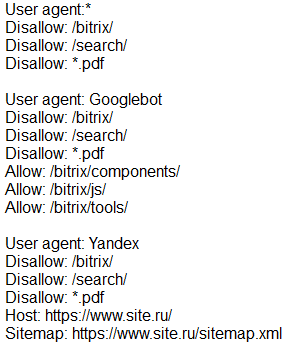

Прежде чем начать разбирать синтаксис и настраивать robots.txt, посмотрим на то, как должен выглядеть «идеальный файл»:

Но не стоит сразу же его применять. Для каждого сайта чаще всего необходимы свои настройки, так как у всех у нас разная структура сайта, разные CMS. Разберем каждую директиву по порядку.

User-agent

User-agent — определяет поискового робота, который обязан следовать описанным в файле инструкциям. Если необходимо обратиться сразу ко всем, то используется значок *. Также можно обратиться к определенному поисковому роботу. Например, Яндекс и Google:

Disallow

С помощью этой директивы, робот понимает какие файлы и папки индексировать запрещено. Если вы хотите, чтобы весь ваш сайт был открыт для индексации оставьте значение Disallow пустым. Чтобы скрыть весь контент на сайте после Disallow поставьте “/”.

Мы можем запретить доступ к определенной папке, файлу или расширению файла. В нашем примере, мы обращаемся ко всем поисковым роботам, закрываем доступ к папке bitrix, search и расширению pdf.

Allow

Allow принудительно открывает для индексирования страницы и разделы сайта. На примере выше мы обращаемся к поисковому роботу Google, закрываем доступ к папке bitrix, search и расширению pdf. Но в папке bitrix мы принудительно открываем 3 папки для индексирования: components, js, tools.

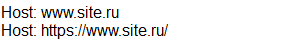

Host — зеркало сайта

Зеркало сайта — это дубликат основного сайта. Зеркала используются для самых разных целей: смена адреса, безопасность, снижение нагрузки на сервер и т. д.

Host — одно из самых важных правил. Если прописано данное правило, то робот поймет, какое из зеркал сайта стоит учитывать для индексации. Данная директива необходима для роботов Яндекса и Mail.ru. Другие роботы это правило будут игнорировать. Host прописывается только один раз!

Для протоколов «https://» и «http://», синтаксис в файле robots.txt будет разный.

Sitemap — карта сайта

Карта сайта — это форма навигации по сайту, которая используется для информирования поисковых систем о новых страницах. С помощью директивы sitemap, мы «насильно» показываем роботу, где расположена карта.

Символы, применяемые в файле: «/, *, $, #».

- Слэш «/», скрывает от обнаружения различные страницы сайта.

- Звездочка «*» применяется для обозначения любой последовательности символов в файле.

- Знак доллара «$» сдерживает действия знака звездочки. С помощью него, можно запретить содержимое папки, но адрес который содержит папка, разрешить.

- Решетка «#» применяется для комментирования. Робот не учитывает эти записи при сканировании сайта.

После того как вы разместили Robots.txt на своем сайте, вам необходимо добавить и проверить его в вебмастере Яндекса и Google.

Проверка Яндекса:

- Перейдите по ссылке https://webmaster.yandex.ru/tools/robotstxt/.

- Выберите: Настройка индексирования — Анализ robots.txt.

Проверка Google:

- Перейдите по ссылке https://support.google.com/webmasters/answer/6062598 .

- Выберите: Сканирование — Инструмент проверки файла robots.txt.

Таким образом вы сможете проверить свой robots.txt на ошибки и внести необходимые настройки, если потребуется.

В заключение приведу 6 главных рекомендаций по работе с файлом Robots.txt:

- Содержимое файла необходимо писать прописными буквами.

- В директиве Disallow нужно указывать только один файл или директорию.

- Строка «User-agent» не должна быть пустой.

- User-agent всегда должна идти перед Disallow.

- Не стоит забывать прописывать слэш, если нужно запретить индексацию директории.

- Перед загрузкой файла на сервер, обязательно нужно проверить его на наличие синтаксических и орфографических ошибок.

Успехов вам!

www.obrazstroy.ru