Закрываем внешние ссылки от индексации на сайте WordPress. Wordpress закрыть от индексации

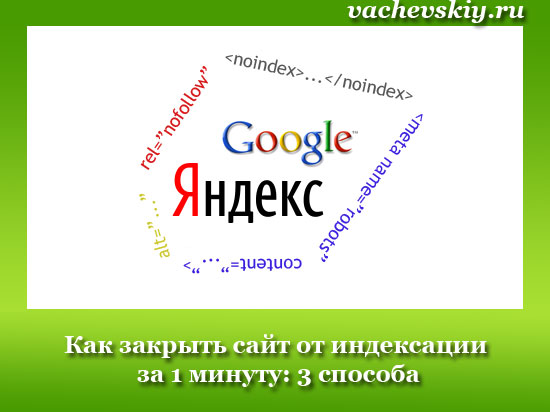

Как закрыть сайт от индексации за 1 минуту: 3 способа

Привет всем, друзья!Иногда возникают ситуации, когда необходимо закрыть сайт от индексации. Ну, например вы решили сменить дизайн блога и не хотите, чтобы в это время на ресурс заходили поисковые боты. Или просто вы только что создали сайт и установили на него движок, соответственно если на ресурсе нет полезной информации, то показывать его поисковым ботам не стоит. В данной статье вы узнаете о том, как закрыть сайт от индексации в Яндексе, Гугле, или сразу во всех поисковых системах. Но перед тем вы также можете прочитать еще одну похожую статью: «Как закрыть ссылку от индексации?» А теперь приступим.

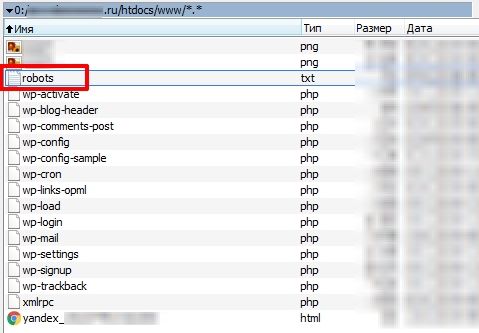

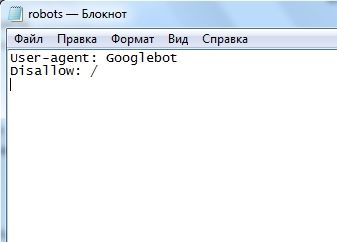

1. Закрываем сайт от индексации с помощью файла robots.txt.Для начала вам нужно создать файл robots.txt. Для этого создаете на своем компьютере обычный текстовый документ с названием robots и расширением .txt. Вот я только что создал его:

Теперь этот файл нужно загрузить в корневую папку своего блога. Если ресурс сделан на движке вордпрес, то корневая папка находится там, где папки wp-content, wp-includes и т. д.

Итак, мы загрузили пустой файл на хостинг, теперь нужно с помощью этого файла как-то закрыть блог от индексации. Это можно сделать, как я уже написал только для Яндекса, Гугла или сразу всех поисковиков. Давайте обо всем по порядку.

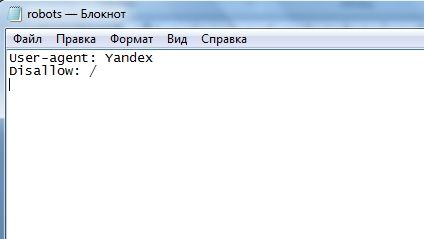

Как закрыть сайт от индексации только для Яндекса?Пропишите в файле robots.txt вот такую строчку:

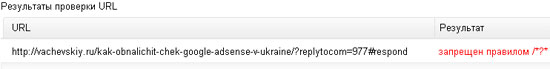

User-agent: Yandex Disallow: /Для того чтобы убедиться в том, что вы запретили индексировать свой ресурс Яндексу, добавьте сначала сайт в Яндекс Вебмастер, если вы этого еще не сделали, а потом перейдите на эту страницу. Дальше введите несколько страниц своего сайта и нажмите на кнопку «Проверить». Если страницы запрещены к индексации, то вы увидите примерно такую картину:

Как закрыть сайт от индексации только для Google?Откройте файл robots.txt и пропишите там вот такую строчку:

User-agent: Googlebot Disallow: /Для того чтобы проверить, что Гугл не индексирует сайт, создайте аккаунт, добавьте свой ресурс в Google Webmaster и перейдите вот сюда. Здесь также нужно ввести несколько страниц и нажать на кнопку «проверить».

Если страница разрешена к индексированию, то будет писать «Разрешено», в таком случае вы сделали что-то не так. Если документ запрещен к индексации, то будет писать «Заблокировано по строке», и Гугл укажет строку, с помощью которой страница запрещена к индексации. Вы также можете прочитать статью о том, как проверить индексацию сайта.

Я заметил, что поисковая система Google индексирует даже те документы, которые запрещены в файле robots.txt и заносит их в дополнительный индекс, так называемые «сопли». Почему, не знаю, но вы должны понимать, что запретить сайт или отдельную страницу с помощью файла robots.txt на 100 % нельзя. Этот файл, как я понял, только рекомендация для Гугла, а он уже сам решает, что ему индексировать, а что нет.

Как закрыть сайт от индексации для всех поисковых систем?Чтобы запретить сразу всем поисковикам индексировать ваш ресурс, пропишите в robots.txt вот такую строчку:

User-agent: * Disallow: /Теперь вы также можете перейти в Яндекс или Гугл Вебмастер и проверить запрет индексации.

Свой файл robots.txt вы можете увидеть по такому адресу:

Вашдомен.ru/robots.txtВсе что вы прописали в этом файле должно отображаться в браузере. Если при переходе по этому адресу перед вами выскакивает ошибка 404, значит, вы не туда загрузили свой файл.

Кстати, мой robots.txt находиться здесь. Если ваш ресурс сделан на движке wordpress, то можете просто скопировать его. Он правильно настроен для того, чтобы поисковые боты индексировали только нужные документы и что бы на сайте не было дублей.

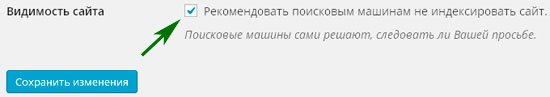

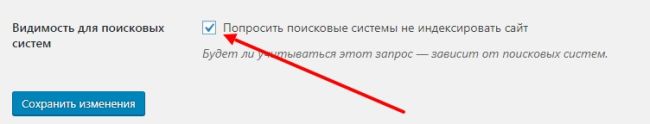

2. Закрываем сайт от индексации с помощью панели инструментов.Этот способ подойдет только для тех, чей ресурс сделан на вордпрес. Зайдите в «Панель управление» — «Настройки» — «Чтение». Здесь нужно поставить галочку напротив надписи «Рекомендовать поисковым машинам не индексировать сайт».

Обратите внимание, что ниже находиться очень интересная надпись: «Поисковые машины сами решают, следовать ли Вашей просьбе». Это как раз то, о чем я писал выше. Яндекс скорее всего не будет индексировать страницы, которые запрещены к индексации, а вот с Гуглом могут возникнуть проблемы.

3. Закрываем сайт от индексации вручную.Когда вы закрываете целый ресурс или страницу от индексации, то в исходном коде автоматически появляется вот такая строчка:

<meta name="robots" content="noindex,follow" />Она и говорит поисковым ботам, что документ индексировать нельзя. Вы можете просто вручную прописать эту строчку в любом месте своего сайта, главное чтобы она отображалась на всех страницах и тогда ресурс будет закрыт от индексации.

Кстати, если вы создаете ненужный документ на своем сайте, и не хотите чтобы поисковые боты его индексировали, то можете также вставить в исходном коде эту строчку.

После обновления откройте исходный код страницы (CTRL + U) и посмотрите, появилась ли эта строчка там. Если есть, значит все хорошо. На всякий случай можете еще проверить с помощью инструментов для вебмастеров от Яндекса и Гугла.

На этом все на сегодня. Теперь вы знаете, как закрыть сайт от индексации. Надеюсь, эта статья была полезна для вас. Всем пока.

vachevskiy.ru

Правильный robots.txt для сайта на движке wordpress

Здравствуйте, начинающие веб. мастера. Сегодня мы поговорим о том, как настроить файл robots.txt и .htaccess на своем блоге. Давайте начнем с robots.txt, но для начала разберемся для чего он вообще нужен.

А нужен он для того, чтобы давать роботам поисковых систем указания на то, какие разделы сайта индексировать, а какие не индексировать. Это определение очень упрощенное и на самом деле у robots.txt имеется огромное число функций.

В данной статье я Вам расскажу, какие основные настройки должны быть сделаны в robots.txt перед самым запуском вашего блога. А если вам нужна более полная информация, советую посетить сайт http://robotstxt.org.ru/

Вот как раз там я нашла видеоролик о процессе создания файла. На этом же сайте вы узнаете как «роботс» должен работать по стандарту, а на страницах Яндекс. Вебмастер, вы узнаете как этот файл работает для Яндекса.

Поисковые системы Гугл и Яндекс ведут себя по разному. Каждый из них поддерживает свои настройки и директивы, однако оба в той или иной степени следуют данному стандарту.

В robots.txt нам необходимо закрыть папки блога wordpress от индексации такие как: папку с административными файлами, папку со служебными библиотеками, папку с плагинами, папку с кэшем, папку с темами и различные url адреса, которые могут приводить к образованию дублей.

Именно такие настройки прописаны у меня.

Вы можете скопировать данные моего файла robots.txt, вставив предварительно адрес — http://lessons-business.ru/robots.txt и заменить мое доменное имя на свое.

Настройка файл .htaccess

Файл .htaccess необходим для того, чтобы управлять веб. сервером, который установлен на вашем хостинге. В частности, директивы, которые располагаются в .htaccess, влияют на работу веб-сервера Apache.

Существует огромное количество настроек и функциональных возможностей, которыми можно управлять через этот файл и заниматься этим должен профессиональный системный администратор.

Сегодня я вам расскажу о наборе директив, которые необходимо вставить перед запуском вашего блога.

Скопируйте директивы из этого файла.

Дальше подключитесь по ftp к удаленному серверу и откройте файл .htaccess для редактирования. Сразу после «RewriteBase /» вставьте скопированный код так, как показано у меня на скриншоте.

Что означают данные директивы? Они обозначают то, что при переходе пользователя или поисковой системы по url, которые заканчиваются на feed, comments и т.д., он будет автоматически переводить на страницу без данного окончания.

Как это работает?

Переход по ссылке до установки директив:

Переход по тому же адресу после установки директив:

Зачем мы это сделали?

Давно замечено и доказано, что WordPress генерирует много разных мусорных страниц и все эти мусорные страницы попадают в индекс поисковых систем. При этом образуются технические дубли. Мы задали эти директивы, чтобы не было таких мусорных страниц.

В .htaccess мы перечислили основные виды страниц, которые генерирует WordPress. Это страницы фидов, это страницы постраничной навигации комментариев, всем известные реплайтукомы и т.д.

Сегодня мы научились настраивать файл robots.txt и .htaccess. Я вам дала ценную информацию, о которой сама узнала из платного курса.

Не забывайте подписываться на обновления и оставлять комментарии. До встречи. Наталья Краснова.

Анекдот.

lessons-business.ru

Как закрыть сайт от индексации в Яндексе и Google

Мэт Катс, будучи в свое время официальным представителем Гугл для вебмастеров, в одном из своих видео, рассказал, как закрыть сайт от индексации, способ предельно простой – нужно просто не ставить ссылки на свой сайт. Про этот, а также про другие способы закрытия сайта от индексации, читайте дальше.

Хотя, на самом деле, не ставить ссылки на свой сайт, это тоже вариант, но и сам Мэт Катс, в своем видео признает – такой способ действительно возможен — теоретически, но фактически, это не вариант. Любой посетитель, зайдя на ваш сайт, может затем оставить эту ссылку где угодно. И все, как только поисковик пройдет по ссылке, ваш сайт окажется проиндексирован поисковиком.

Но на самом деле, есть и другие способы закрытия своего сайта. Одни из них, менее эффективные, другие дают сто процентную гарантию запрета. Давайте пройдемся по этим способам.

Я предполагаю, что вы уже знаете, что такое индексация сайта и почему она важна. Окей, пару слов об этом. Поисковики, что Яндекс, что Гугл, да и другие тоже, постоянно рыскают по всему интернету, в поисках новой информации, и заносят всю важную информацию в свои базы. Если сайт проиндексирован, то он будет доступен в поиске.

Зачем нужно запрещать индексацию сайтов.

Есть несколько причин. Но главная, а по сути, единственно важная, это необходимость закрыть индексацию для новых сайтов, или же, для сайтов, которые проводят глобальную реорганизацию.

На молодых сайтах, еще слишком мало информации, и попадание в индекс поисковых систем, не принесет особых плюсов. Зато минусы принести может. На сайте могут быть множество ошибок, а значит, сайт получит пессимизацию. Или просто мало контента. Что в свою очередь, также не будет способствовать любви поисковых систем.

То же самое, касается и сайтов при реорганизации. В этот момент, на сайте идут масштабные работы, и поисковикам сами эти работы, лучше не видеть. Лучше впустить их затем на готовый сайт.

Бывает, что запрет индексации ставят и для того, чтобы чужие не зашли на сайт, и не смогли прочитать то, что на этом сайте. Но в этом случае, запрет индексации сайта, это не панацея, поскольку, с одной стороны, не дает сто процентной гарантии, с другой стороны, на сайт могут зайти и по ссылкам с других сайтов. О том, как сделать закрытые разделы на сайте, я поговорю в другой раз.

Способы закрытия сайта от индексации.

Есть четыре основных способа запрета сайта от индексации.

- Запрет индексации при помощи файла robots.txt

- Закрытие средствами WordPress (для сайтов на wordpress).

- Запрет с использованием мета тегов.

- Запрет индексации сайта при помощи файла .htaccess

В самом начале, вам нужно сделать другой обязательный шаг – добавить ваш сайт в Гугл вебмастерс, и в Яндекс вебмастерс.

Как закрыть сайт от индексации в robots.txt

Robots.txt, это текстовый файл, находящийся в корневой папке сайта. В нем прописывается, что запрещено делать поисковым роботам. И в нем же, можно указать запрет на индексацию всего сайта.

Если у вас еще нет этого файла, то вы можете создать его сами. Для этого, нужно просто создать обычный, текстовый файл, например, в программе блокнот. Только не нужно создавать файл в программе Word, или ему подобных, тяжелых офисных программах.

Также имейте в виду, что название файла должно быть robots.txt, и ничего другого. То есть, обязательна буква s на конце, обязательно маленькие буквы. Иначе, поисковые роботы, его проигнорируют. Я как то уже писать про составление robots.txt для wordpress.

Закрытие сайта от индексации в Яндекс.

После этого, нужно закрыть сайт от индексации в Яндекс. Для этого, можно воспользоваться директивой «Disallow», после чего, сохраните файл в корневой папке вашего сайта.

Теперь, для поискового робота Яндекс, будет стоять запрет. Чтобы проверить, сработал ли запрет, нужно зайти в Яндекс Вебмастер, и проверить любую из страниц сайта инструментом «анализ robots.txt».

Закрытие сайта от индексации в Google.

Аналогично запрету в Яндекс, точно также можно сделать запрет на индексацию в Гугл. Только в этом случае, нужно закрыть Гугл робота.

Ну и точно также, можно закрыть вообще от всех роботов, для этого, можно просто прописать две строчки.

User-agent: *Disallow: /

Запрет индексации сайта при помощи файла robots.txt, простой метод. Но у него есть один недостаток, он не ненадежен. Особенно это касается Гугл. Для него, да и для Яндекса тоже, директивы, прописанные в файле robots.txt, скорее носят рекомендательный характер, но в случае, если роботы поисковиков посчитают нужным проиндексировать сайт, то они это сделают.

Закрытие сайта от индексации в WordPress

Популярная CMS WordPress, имеет свое решение. Таким образом, вебмастер может запретить индексацию, прямо из панели управления сайтом. Перейти в «Настройки» — «Чтение».

Но, как и в случае с файлом robots.txt, запрет к индексации сайта через панель WordPress, не дает сто процентной гарантии.

Запрет с использованием мета тегов.

Для запрета индексации сайта, можно применить специальный html тег:

<meta name="robots" content="noindex,nofollow" />

Разместив этот тег на странице сайта, вы сообщаете поисковикам (этот тег понимают и Яндекс и Гугл), что эту страницу индексировать не надо. А также, ненужно индексировать ссылки на этой странице.

В отличии от использования файла robots.txt, тег robots, является обязательным для исполнения. Но минус этого метода в том, что проставлять придется его на каждой из страниц сайта. Именно этот тег используют различные SEO плагины в WordPress, но с небольшой разницей.

<meta name="robots" content="noindex,follow" />

Здесь вы говорите поисковикам, что страницу индексировать не нужно, но ссылки индексировать нужно.

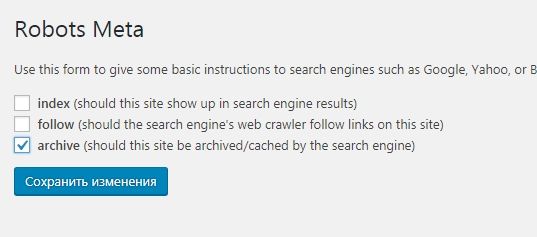

Если у вас WordPress, то вы просто можете поставить другой плагин, который будет проставлять именно первый тег, то есть, будет ставить запрет и на индексацию страницы в целом, и запрет на индексацию ссылок, расположенных на этой странице. Для этого можно воспользоваться плагином – Robots Meta. Его вы сможете найти на странице поиска плагинов.

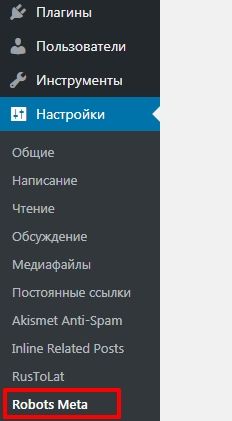

Robots Meta имеет простейшие настройки. Для того, чтобы изменить настройки, нужно зайти в пункт «Настройки», и выбрать «Robots Meta»

После чего, снять галочки с первых двух пунктов

Теперь во все страницы сайта, будет включен мета тег, запрещающий индексацию.

Закрыть весь сайт от индексации в файле .htaccess

Ну и последний пункт, это использование файла .htaccess. Это один из файлов настройки, который находится в корневой папке хостинга, то есть, там же, где находится и файл robots.txt. Однако, на некоторых хостингах, этот файл может быть недоступным (обычно на бесплатных хостингах, он недоступен).

Для того, чтобы закрыть файл, достаточно прописать в этом файле всего одну строчку:

deny from all

Но не торопитесь этого делать. Дело в том, что данная команда, закрывает вообще весь сайт, и не только от поисковых роботов, но и от людей тоже. И если ваш сайт использует доступ через админскую панель, то и она (админская панель), будет закрыта. Доступ к сайту будет только через FTP.

Но кроме полного закрытия сайта, можно просто поставить пароль на сайт. И это абсолютный метод, благодаря которому, вы сможете закрыть свой сайт от поисковых систем. Ну а как поставить пароль на сайт через файл .htaccess, смотрите в видео.

life-crazy.ru

Как закрыть от индексации сайт, ссылку, страницу, в robots ?

Далеко не всегда нужно, чтобы поисковые системы индексировали всю информацию на сайте.

Иногда, вебмастерам даже нужно полностью закрыть сайт от индексации, но новички не знают, как это сделать. При желании, можно скрыть от поисковиков любой контент, ресурс или его отдельные страницы.Как закрыть от индексации сайт, ссылку, страницу? Есть несколько простых функций, которые вы сможете использовать, для закрытия любой информации от Яндекса и Гугла. В этой статье мы подскажем, как закрыть сайт от индексации через robots, и покажем, какой код нужно добавить в этот файл.

Закрываем от индексации поисковиков

Перед тем как рассказать о способе с применением robots.txt, мы покажем, как на WordPress закрыть от индексации сайт через админку. В настройках (раздел чтение), есть удобная функция:

Можно убрать видимость сайта, но обратите внимание на подсказку. В ней говорится, что поисковые системы всё же могут индексировать ресурс, поэтому лучше воспользоваться проверенным способом и добавить нужный код в robots.txt.

Текстовый файл robots находится в корне сайта, а если его там нет, создайте его через блокнот.

Закрыть сайт от индексации поможет следующий код:

User-agent: *

Disallow: /

Просто добавьте его на первую строчку (замените уже имеющиеся строчки). Если нужно закрыть сайт только от Яндекса, вместо звездочки указывайте Yandex, если закрываете ресурс от Google, вставляйте Googlebot.

Если не можете использовать этот способ, просто добавьте в код сайта строчку <meta name="robots" content="noindex,follow" />.

Когда проделаете эти действия, сайт больше не будет индексироваться, это самый лучший способ для закрытия ресурса от поисковых роботов.

Как закрыть страницу от индексации?

Если нужно скрыть только одну страницу, то в файле robots нужно будет прописать другой код:

User-agent: *

Disallow: /category/kak-nachat-zarabatyvat

Во второй строчке вам нужно указать адрес страницы, но без названия домена. Как вариант, вы можете закрыть страницу от индексации, если пропишите в её коде:

<META NAME="ROBOTS" CONTENT="NOINDEX">

Это более сложный вариант, но если нет желания добавлять строчки в robots.txt, то это отличный выход. Если вы попали на эту страницу в поисках способа закрытия от индексации дублей, то проще всего добавить все ссылки в robots.

Как закрыть от индексации ссылку или текст?

Здесь тоже нет ничего сложного, нужно лишь добавить специальные теги в код ссылки или окружить её ими:

<noindex>

<a rel="nofollow" href="http://Workion.ru/">Анкор</a>

</noindex>

Используя эти же теги noindex, вы можете скрывать от поисковых систем разный текст. Для этого нужно в редакторе статьи прописать этот тег.

К сожалению, у Google такого тега нет, поэтому скрыть от него часть текста не получится. Самый простой вариант сделать это – добавить изображение с текстом.

Скрывайте от поисковых роботов всё, что не уникально или каким-то образом может нарушать их правила. А если вы решили полностью переделать сайт, то обязательно закрывайте его от индексации, чтобы боты не индексировали внесенные изменения до того, как вы над ними поработаете и всё протестируете.

Вам также будет интересно:- Скорость сайта – важный фактор- Почему Яндекс не индексирует сайт?- Оригинальные тексты для защиты от Yandex

workion.ru

Закрываем внешние ссылки от индексации на сайте WordPress

Рано или поздно, но любого владельца сайтом будет интересовать вопрос, как скрыть внешние ссылки от индексации...Перерыла весь интернет и не только нашла, но и перепробовала различные способы. Вот о них и поведаю ниже.

Плагин WP-Noindex для скрытия внешних ссылок на сайтах WordPress в комментариях, он заключает эти ссылки специальным тегом

"noindex".Установка плагина производится стандартным способом. Плагин не надо настраивать, просто установите и активируйте его.Плагин WP-Noindex будет автоматически скрывать внешние ссылки от поисковиков.

Nofollow Links in Posts - Плагин добавлять атрибут

rel="nofollow"ко всем ссылкам в посте, если пост публикуется и не внесен в исключения. Если категория поста является исключением, то ссылки в нем остаются открыты для индексации. Плюс плагина в том, что в настройках плагина можно закрывать ссылки от индексации не сразу, а по прошествии определенного количества дней.

RC Link Redirector - Плагин шифрует все внешние ссылки, делая их внутренними. Для этого он использует специальные "секретные" ключи, с помощью которых движок блога понимает, что это "засекреченная" ссылка, которая может вести на внешний источник, но выглядит, как внутренняя.

Плагин (J)ExR - плагин для WordPress, который делает редирект на все внешние ссылки сайта, тем самым закрывая их от индексации поисковыми системами, то есть все внешние ссылки становятся внутренними.Желательно добавить запись в robots.txt чтобы редиректы не попадали в индекс запись

"Disallow: /jexr/"тогда робот не будет включать ссылки в базу.Если же Вы зарабатываете на продаже ссылок с сайта, то вам следует ОБЯЗАТЕЛЬНО перейти в НАСТРОЙКАХ в поле «Не трогать» и вписать эти ссылки для исключения их от закрытия.

Еще один замечательный плагин Wp-NoExternalLinks, он сделает работу за вас автоматически! Производите стандартную установку плагина на сайт.Активируйте его и заходите в раздел «Параметры», находите «Wp-NoExternalLinks», где увидите НАСТРОЙКИ, которые нужно проделать.Что делаю я?

- «Маскировать ссылки в постах» - галочку убираю.

- «Маскировать ссылки в комментариях» - галочку ставлю.

- «Маскировать ссылки комментаторов» - галочку ставлю.

- «Добавлять rel=nofollow в маскируемые ссылки (для google)» - галочку ставлю.

- «Добавлять target="blank" для всех ссылок на другие сайты (ссылки будут открываться в новом окне)" - галочку ставлю.

- «Окружать маскируемые ссылки тегом link (для яндекса)» - галочку ставлю.

- «Не маскировать ссылки при помощи редиректов «Вести статистику по кликам на внешние ссылки» - галочку ставлю.

- «Вести статистику по кликам на внешние ссылки» - галочку ставлю (там установлено по умолчанию – 30 дней).

Далее Вы можете указать адреса, которые вы не хотите маскировать, в специальном окне.

WP-NoRef – еще один плагин. Установка проста.Закрывает ссылки двумя выше названными тегами, как в постах, так и в комментариях. Есть возможность добавить сайты в исключения, к которым теги не будут ставиться. Закрыть ссылки в сайдбаре он не может и нельзя настроить индексации ссылок в комментариях!

ВЫВОД:

плагин 1. WP-NoExternalLinks более функционален и более удобен в применении. Сначала я выбрала его.2. WP-NoRef - самый простой в настройках! Закрывает все ссылки без настройки. Теперь пользуюсь этим. Посмотрю, какой оставить.

А что же делать с ссылками в сайдбаре, футере и хедере, где можно увидеть внешние ссылки разработчиков сайтов, авторов тем, рекламы, спонсоров проектов, партнеров сайта?

Здесь придется вручную, где возможно, переписывать внешние ссылки на ссылки вида:

//ваш-сайт.com/goto/внешняя-ссылка.htmlДобавляйте текст

//ваш-сайт.com/goto/перед каждой внешней ссылкой.

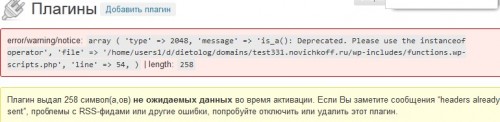

ПРЕДУПРЕЖДЕНИЕ для любителей ЭКСПЕРИМЕНТОВ!

Вы, конечно, захотите испытать и другие ПЛАГИНЫ! Их - более 32300!

Лично я обожаю, не просто почитать о ПЛАГИНЕ, но и испытать его в действии!

На одном из испытаний я угрохала сайт!

ВНИМАТЕЛЬНО читайте, с какой версией WordPress СОВМЕСТИМ плагин! И еще лучше испытывайте его на тестовом САЙТЕ!

Если вам хоть немного помогла эта статья, то нажмите на кнопки СОЦСЕТЕЙ - они перед комментариями. СПАСИБО!

На главной странице сайта есть два опроса, ответьте на них, пожалуйста, - ЗДЕСЬ>>>

babulyapartner.ru

Закрываем внешние ссылки от индексации

В сегодняшней статье я хочу затронуть один из вопросов внутренней оптимизации блога, а именно закрытие внешних ссылок от индексации.

Для чего вообще закрывать внешние ссылки от индексации поисковиками?

Причин этому несколько, давайте рассмотрим немного подробнее.

1. Внешние ссылки передают вес страниц Вашего блога на страницы на которые Вы ссылаетесь, при этом сами они теряют этот вес.

В основе алгоритма поискового ранжирования с самого начала его существования лежит принцип передачи ссылочного веса. То есть, чем больше авторитетных сайтов ссылаются на Ваш блог, тем более авторитетным в глазах поисковиков становится и Ваш ресурс.

Но есть и обратная сторона этого вопроса, чем больше внешних ссылок ведет с Вашего сайта, тем меньше становится его вес.

Это конечно грубо сказано, есть много других факторов влияющих на вес страниц, но ссылки – один из основных.

Следовательно, чтобы повысить авторитетность своего блога в глазах поисковых систем при равных остальных условиях нужно минимизировать количество внешних ссылок.

2. Обращайте также внимание на какие ресурсы Вы ссылаетесь. Они должны быть схожей тематики с Вашим блогом или сайтом, тогда такие внешние ссылки оправданы .

К сайтам, на которые ведут внешние ссылки с Вашего блога не должно быть применено никаких поисковых санкций. Если к примеру сайт на который Вы ссылаетесь уличен в продаже ссылок, или к нему применен фильтр АГС – то это плохо скажется и на Вашем блоге.

3. Еслы Вы планируете продавать ссылки со своего блога, то количество внешних ссылок играют тоже не маловажную роль.

Чем меньше внешних ссылок на Вашем ресурсе, тем более он привлекателен для покупателей, и тем больше может стоить ссылка с вашего блога.

4. Не переусердствуйте с этим. Дело в том, что полное отсутствие внешних ссылок с Вашего блога может вызвать подозрение у тех же поисковиков, это ведь не естественно.

Раскрою Вам секрет, когда внешняя ссылка может быть полезной и оправданной.

Основная задача поисковиков – показать пользователям на странице поиска самые релевантные сайты, то есть те, которые больше всего соответствуют запросу введенному посетителем в строку поиска.

Для этого они постоянно анализируют поведение посетителей на Вашем и на других сайтах. Если пользователь долгое время остается на Вашей страничке – значит его это заинтересовало, он наверняка нашел то что искал.

Аналогично, если посетитель уйдет на сайт схожей тематики, на статью которую Вы ему порекомендовали и останется там на длительное время –то это значит, что Вы помогли ему найти то, что он искал. А это большой плюс и в Вашу пользу.

Помните, поисковик всегда на стороне посетителя, а не владельца блога. Действуйте в соответствии с целью пользователя и поисковики это тоже оценят.

С причинами думаю разобрались, теперь рассмотрим методы.

Как можно закрыть внешние ссылки от индексации

1. Закрываем ссылки вручную

Это достаточно трудоемкий метод, так, как нам нужно поработать отдельно с каждой ссылкой или блоком кода. Но его стоит рассмотреть, хотя бы для понимания того, как это делается.

Для закрытия ссылки от индексации поисковой системой яндекс, мы должны заключить код ссылки в тэги <noindex></noindex> , ниже я покажу это на примере.

Для аналогичного результата с поисковиком гугл, мы должны добавить специальный атрибут в код ссылки — rel=”nofollow”

Смотрите как будет выглядеть ссылка закрытая от индексации и для гугла и для яндекса:

<noindex>

<a rel=”nofollow” href="http://site.ru/stranica.html">

</noindex>

Вручную можно закрыть ссылки или коды в темплейтах темы Вашего блога.

К примеру код счетчика liveinternet размещается на каждой страничке блога. В темплейтах он обычно прописывается в header.php.

Закрыв этот код от индексирования один раз в темплейте, мы одним махом закрыли его индексацию на всех страничках блога.

2. Закрываем внешние ссылки от индексации при помощи плагина

Для автоматизации процесса в вордпресс есть отличный плагин, который называется wp no external links. Установив и настроив его, мы можем одним махом закрыть нужные ссылки от индексации автоматически.

Как им пользваться, я скоро покажу в своем новом видео, не забудьте подписаться на обновления блога, чтобы не пропустить этого.

Давайте посмотрим, что может этот плагин

· Маскировать ссылки в постах

Вам не нужно делать этого вручную при написании нового поста на свой блог, закрываются также внешние ссылки на давно опублинованных постах

· Маскировать ссылки в комментариях

· Маскировать ссылки комментаторов

Теперь не нужно использовать отдельный плагин, чтобы закрыть ссылки в комментариях от индексации.

Только имейте в виду, что этот параметр может сократить количество комментариев на Вашем блоге. Не секрет, что многие комментируют блоги с открытыми для индексации комментариями лишь для увеличения ссылочной массы своего ресурса.

С другой стороны у Вас наверняка уменьшится количество ручного спама

· Добавлять rel=nofollow в маскируемые ссылки (для google)

· Добавлять target=»blank» для всех ссылок на другие сайты (ссылки будут открываться в новом окне)

Это очень важный параметр и я советую его использовать, если говорить грубо, то в конечном итоге он увеличивает время пребывания посетителей на Вашей страничке. Ваш сайт не будет закрываться в браузере при клике посетителем на внешнюю ссылку.

· Окружать маскируемые ссылки тегом <noindex>link</noindex> (для яндекса)

· Маскировать ссылки при помощи редиректов

Вообще удаляет прямые внешние ссылки, переход на внешнюю ссылку осуществляется при помощи редиректа.

Пока не думал о выгодах использования этой опции, но вполне возможно, что она есть.

· Вести статистику кликов по внешним ссылкам

· Прописать адреса сайтов для которых не нужно закрывать ссылки от индексирования

Если Вы сознательно хотите открыть внешние ссылки для каких либо сайтов, например при обмене ссылками, нужно просто прописать их адреса в соответствующем поле настройки плагина.

Эти два способа вполне справляются с задачей по закрытию ссылок от индексации, так что на них и остановимся.

И последний вопрос, который я хотел бы затронуть в этой статье

Какие внешние ссылки закрывать от индексации

1. Коды счетчиков статистики

Это вообще, техническая информация, которая не имеет ничего общего с полезным контентом блога, следовательно – индексировать это не нужно

2. Ссылки подписки на обновления

Это может быть RSS или E-mail подписка, тоже не несет никакой информации для поисковых систем.

3. Ссылки ведущие на сайты производителей плагинов, тем и т.п.

По этим ссылкам тоже уходит вес страниц, я их закрываю

На этом пора заканчивать сегодняшнюю статью, теперь Вы знаете как и зачем закрывать внешние ссылки от индексации. И если в Ваших планах есть создание своего популярного блога, этими знаниями стоит воспользоваться на все 100 процентов.

livewebbusiness.ru

Как закрыть ссылку и текст от индексации

Иногда на сайте требуется разместить ссылку на какой-то другой сайт. При этом, как правило, вебмастер готов пожертвовать частью своего трафика и перенаправить его на другой сайт, (всё-таки, они уже полазили на сайте-доноре, и нечего их тут долго держать). Однако перенаправлять туда робота, терять вес страницы, и позиции в выдаче никому не захочется. Поэтому необходимо знать, как закрыть ссылку.

Как закрыть ссылку от индексации

Итак, для чего ссылки закрывать от индексации, мы разобрались. Теперь рассмотрим, как это сделать. Делается это с помощью параметра. Ссылка, закрытая от индексации, должна выглядеть так:

<a href= “http://адресс ссылки” rel=”nofollow”>анкор</a>

Итог будет такой. Живой посетитель увидит эту ссылку, и сможет перейти по ней при необходимости, а поисковой робот ссылку не увидит, он расценит её только по анкору, то есть, как текст. И проиндексирует только текст, и по ссылке на другую страницу переходить не станет. Поэтому вес страницы останется при ней. Более подробно о понятии веса страницы почитайте тут.

Работает ли rel=”nofollow” на самом деле

Если бы всё было так просто… Практика показывает, что rel=”nofollow” не всегда работает адекватно и иногда всё-таки ссылка индексируется либо Яндексом, либо Google. С чем это связанно, не ясно. Возможно, с периодическим изменением алгоритмов поисковиков или некоторые практики просто неверно используют rel=”nofollow”, но факт остаётся таким.

Поэтому не стоит особо надеяться на то, что страница не потеряет веса, если на ней фигурируют какие-то ссылки на другие сайты. И по возможности, лучше избегать этого. Но если избежать не получается, то rel=”nofollow” – единственный и ненадёжный способ закрыть ссылку.

Как закрыть текст от индексации

В отличие от ссылок, с текстом всё проще, метод работает, и практика всегда показывает это. Чтобы закрыть текст от индексации, необходимо использовать тег </noindex>. Выглядеть должно так:

<noindex>то, что закрывается от индексации</noindex>

Результат будет такой: посетитель текст, конечно же, увидит и сможет его прочитать, но поисковик его проигнорирует и включать в поисковую базу не станет.

Зачем закрывать текст от индексации

Казалось бы, зачем это делать. Ведь мы все так стараемся преподнести поисковику побольше текста и так хотим, что бы он его, наконец, проиндексировал. Но смысл в этом есть.

Например, если вы делаете интернет-магазин с компьютерами и даёте описания компьютерной техники, а потом вам нужно привести параметры устройства, они окажутся не уникальными. Их нельзя переделать, и убрать их тоже не практично. И чтобы не скормить не уникальный текст поисковику, нужно закрыть его с помощью тегов </noindex>.

Если вы нашли ошибку, то выделите её и нажмите клавиши Shift + Enter или нажмите сюда, чтобы проинформировать нас.

Также по этой теме:

wpuroki.ru