[Modx Revo] SEO настройка сайта MODX Revo robots.txt .htaccess. Modx robots

MODX Revolution. Создание файла robots.txt

Файл robots.txt запрещает (разрешает) индексирование и посещение поисковыми роботами файлов из указанных в нём директорий. Давайте создадим файл robots.txt для MODX Revo.

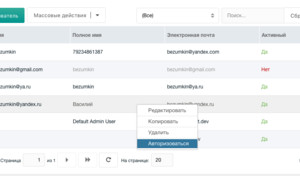

Войдите в панель администратора: ваш_домен/manager/

В левой части находим вкладку: Файлы → Filesystem. Правой кнопкой мыши нажимаем на Filesystem и выбираем Создать файл:

В открывшемся окне в поле Имя файла необходимо прописать robots.txt, в поле Содержимое:

User-agent: * Disallow: /cgi-bin Disallow: /manager/ Disallow: /assets/components/ Disallow: /core/ Disallow: /connectors/ Disallow: /index.php Disallow: *? Host: mysite.ru Sitemap: http://mysite.ru/sitemap.xmlДля понимания:

User-agent: * — для всех поисковых роботов;

Disallow: — закрыть для индексирования;

/cgi-bin — каталог, который содержит (или не содержит — пустой) серверные скрипты. Как правило, есть на всех хостингах;

/manager/, /assets/components/, /core/, /connectors/ — директории, которые поисковые роботы не будут индексировать;

/index.php — это дубль главной страницы сайта;

*? — удаляем дубли для всех страниц;

mysite.ru — поменяйте на ваш домен.

Сохраните файл и проверьте его по адресу: https://ваш_домен/robots.txt

СВами

MODX Revolution. Настройка ЧПУ

MODX Revolution. Настройка файла .htaccess, ЧПУ и SEO

Яндекс, файл robots.txt и поисковая индексация сайта

opencentr.ru

Правильный robots.txt для MODX Revo

Сегодня мы составим правильный robots.txt для MODX Revo. Данный файл в первую очередь создается для того что бы закрыть дубли страниц от индексации в поисковых системах.

Как создать robots.txt для MODX Revo

Перед тем как начать вы должны включить ЧПУ MODX в настройках сайта.

robots.txt можно создать 2-мя способами:

Первый — прямо на компьютере при помощи блокнота создать текстовый документ с именем robots и расширением txt.

Второй — непосредственно в самом modx (создать документ — и в настройках выбрать тип содержимого txt)

Выбирайте любой способ, который больше нравится. Ну а теперь самое главное.

Правильный robots.txt для MODX Revo

User-agent: * Disallow: /cgi-bin Disallow: /manager/ Disallow: /assets/components/ Disallow: /core/ Disallow: /connectors/ Disallow: /index.php Disallow: *? Allow: /core/cache/phpthumb/*.jpeg Allow: /core/cache/phpthumb/*.png Allow: /core/cache/phpthumb/*.svg Host: сайт.ru Sitemap: http://сайт.ru/sitemap.xml

User-agent: *

Disallow: /cgi-bin Disallow: /manager/ Disallow: /assets/components/ Disallow: /core/ Disallow: /connectors/ Disallow: /index.php Disallow: *?

Allow: /core/cache/phpthumb/*.jpeg Allow: /core/cache/phpthumb/*.png Allow: /core/cache/phpthumb/*.svg

Host: сайт.ru Sitemap: http://сайт.ru/sitemap.xml |

Краткий разбор «роботс» для CMS MODX

Disallow — запрещает индексирование

Allow — разрешает индексирование

- cgi-bin — данная папка есть практически на каждом хостинге и в ней зачастую хранятся файлы конфигураций

- index.php — это дубль главной страницы сайта

- с помощью *? мы удаляем дубли для всех страниц

С остальным думаю понятно, если нет то спрашивайте в комментариях и если есть предложения по модернизации robots.txt тоже указывайте в комментариях.

web-revenue.ru

Настройка правильных файлов robots.txt и .htaccess для MODX Revolution

Для удачного SEO продвижения веб-сайта на Modx Revolution необходимо правильно настроить файл robots.txt и файл .htaccess.

Файл robots.txt для Modx — текстовый файл в формате .txt, ограничивающий поисковым роботам доступ к содержимому на http-сервере. Файл .htaccess - файл дополнительной конфигурации для веб-сервера Apache и ему подобных.Настройка файлов:

Изначально необходимо сделать так, что бы все странички были без добавочных окончаний типа .html .php, а смотрелись к примеру вот так:

http://yotadom.com/indexhttp://yotadom.com/about

Контейнеры в свою очередь без слешей в конце, вот таким образом:

http://modx.cc/novosti

Для этого входим:

Система - Типы содержимого далее text/html и в text extensions стираем .html, сохраняем.

Далее:

Система→Настройки системы→Дружественные URL по фильтру и в Суффикс контейнера стираем слеш.

Настройка файла .htaccess для ModxRevo

В случае если движок расположен не в корневой директории, а в подпапке, то будет:

<IfModulemod_rewrite.c> Options +FollowSymlinks RewriteEngine On RewriteBase /subdirectory/Веб-сайт обязан располагать лишь одним именем с www или без www, раскоментируйте необходимые строки в корневом файле .htaccess

К примеру, если без www, то:

RewriteCond %{HTTP_HOST} . RewriteCond %{HTTP_HOST} !^example-domain-please-change\.com [NC] RewriteRule (.*) http://www.example-domain-please-change.com/$1 [R=301,L]Добавляем строчки для переадресации со странички со слешем в конце, для того что бы не 404 открывалась:

# Remove trailing slash RewriteRule^(manager)/*$ — [L] # exclude manager folder RewriteCond %{REQUEST_URI} (.*)/ RewriteRule ^(.*)/$ http://example.com/$1 [R=301,L]В случае если в начале и конце странички 404 появляются каки-то символы, необходимо добавить в файл .htaccess еще строки:

SetEnv force-no-vary SetEnv downgrade-1.0В случае если есть сложности с кодировкой, то нужно добавить:

AddDefaultCharset utf8ROBOTS.TXT

User-agent: * Disallow: /assets/ Disallow: /connectors/ Disallow: /core/ Disallow: /manager/ Disallow: /? Disallow: /*?id= Host: modx.ccwww.modx.cc

MODx robots txt

Файл robots.txt содержит инструкции для поисковых роботов, которые указывают на структуру сайта и помогают им определить, какой контент необходимо проиндексировать, а какой должен быть закрыт от индексации.

Рекомендуется закрывать от индексации весь мусор на сайте и весь дублирующий контент, или контент который не представляет для пользователя никакого интереса. К примеру, я закрываю результаты поиска на сайте, по скольку это дублирующая информация, а также все системыне файлы движка.

Далее я предлагаю ознакомиться с корректным содержимым файла robots.txt:

User-agent: YandexDisallow: /assets/cache/Disallow: /assets/docs/Disallow: /assets/export/Disallow: /assets/import/Disallow: /assets/modules/Disallow: /assets/plugins/Disallow: /assets/snippets/Disallow: /assets/packages/Disallow: /assets/tvs/Disallow: /install/Disallow: /manager/

User-agent: GoogleDisallow: /assets/cache/Disallow: /assets/docs/Disallow: /assets/export/Disallow: /assets/import/Disallow: /assets/modules/Disallow: /assets/plugins/Disallow: /assets/snippets/Disallow: /assets/packages/ Disallow: /assets/tvs/Disallow: /install/Disallow: /manager/

User-agent: Mail.ruDisallow: /assets/cache/Disallow: /assets/docs/Disallow: /assets/export/Disallow: /assets/import/Disallow: /assets/modules/Disallow: /assets/plugins/Disallow: /assets/snippets/Disallow: /assets/packages/ Disallow: /assets/tvs/Disallow: /install/Disallow: /manager/

User-agent: *Disallow: /assets/cache/Disallow: /assets/docs/Disallow: /assets/export/Disallow: /assets/import/Disallow: /assets/modules/Disallow: /assets/plugins/Disallow: /assets/snippets/Disallow: /assets/packages/Disallow: /assets/tvs/Disallow: /install/Disallow: /manager/

Host: http://site.ruSitemap: http://site.ru/sitemap.xml

Я рекомендую указывать инструкции для каждого поисковика, который представляет для вас интерес по отдельности, а также для указать инструкцию для всех других поисковиков.

User-agent - указывает на поисковик, дял которого пишется инструкция.

Allow - разрешает индексацию.

Disallow - запрещает индексацию.

Host - указывает на основной хост.

Sitemap - указывает поисковику на xml карту сайта.

modx-evo.ru

[Modx Revo] SEO настройка сайта MODX Revo robots.txt .htaccess от Василисы Белозеровой

Для успешного SEO продвижения сайта на Modx Revolution необходимо произвести нижеописанные настройки.

Для начала нам необходимо сделать так, что бы все страницы были без дополнительных окончаний типа .html .php,

а выглядели например так:

http://yotadom.com/indexhttp://yotadom.com/about

а контейнеры без слешей на конце, вот так:

http://yotadom.com/novosti

Для этого заходим

System→Content types выбираем text/html и в text extensions стираем .html, сохраняем.

Система→Типы содержимого выбираем text/html и в расширении файла стираем .html, сохраняем.

Далее

System→System settings и в Container Suffix стираем слэш.

Система→Настройки системы→Дружественные URL по фильтру и в Суффикс контейнера стираем слеш.

.htaccess Modx Revo

Если движок находится не в корневой директории, а в подпапке, то должно быть

<IfModule mod_rewrite.c> Options +FollowSymlinks RewriteEngine On RewriteBase /subdirectory/ </IfModule>Сайт должен иметь только одно имя с www или без www, раскоментируйте нужные строки в корневом файле .htaccess

Например, если без www, то

RewriteCond %{HTTP_HOST} . RewriteCond %{HTTP_HOST} !^example-domain-please-change\.com [NC] RewriteRule (.*) http://example-domain-please-change.com/$1 [R=301,L]Добавляем строки для переадресации со страницы со слешем на конце, что бы не 404 открывалась

# Remove trailing slashRewriteRule ^(manager)/*$ — [L] # exclude manager folderRewriteCond %{REQUEST_URI} (.*)/RewriteRule ^(.*)/$ http://example.com/$1 [R=301,L]

Если в начале и конце страницы 404 появляются каки-то символы, то необходимо добавить в файл .htaccess еще строки

SetEnv force-no-varySetEnv downgrade-1.0

Если есть проблемы с кодировкой, то надо добавить

AddDefaultCharset utf8

Устанавливаем сниппет Strict URL

- Создаем новый сниппет с именем strict_url, вставляем в него код

- Во всех шаблонах прописать в самом начале, без пробелов и энтеров

[[strict_url]]

ROBOTS.TXT

User-agent: * Disallow: /manager/ Disallow: /assets/components/ Disallow: /core/ Disallow: /connectors/ Disallow: /index.php Disallow: *? Host: mysite.ru Sitemap: http://mysite.ru/sitemap.xmlyotadom.com

Правильный файл robots txt для сайта на MODx - видео урок

Всем привет друзья! Продолжаю вместе с вами осваивать премудрости системы управления сайтом под названием MODx и сегодняшний урок я вместе с вами решил посвятить созданию файла robots txt для нее.

Скажу честно, эта CMS немного непонятная…была, как мне показалось, но как только стал в ней «ковыряться», крутить болтики и гаечки, то все вроде как стало на свои места.

Ничего сложного никогда не бывает, только в самом начале пути, а потом все нормально.

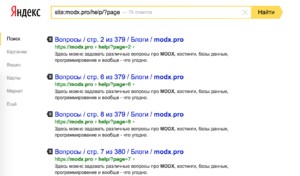

Итак, будем вместе составлять правильный robots txt для поисковых роботов яндекса и гугла, чтобы наш сайт на MODx быстрее проиндексировался и в него попали только страницы с информативным содержанием.

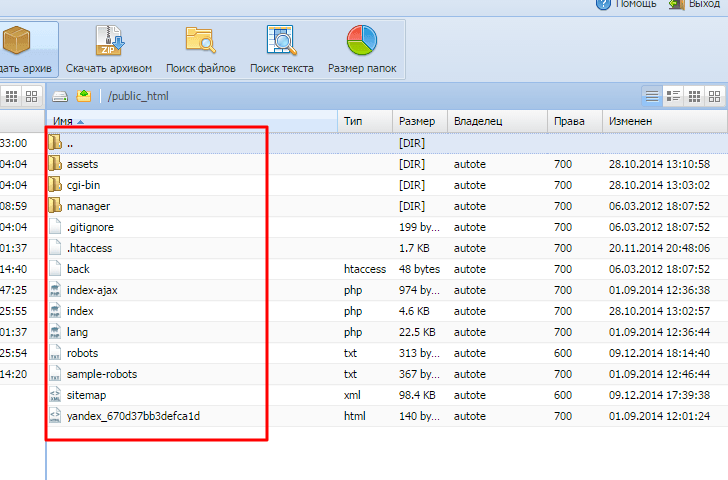

У меня есть клиентский сайт интернет магазин автомагнитол у него имеется вот такая структура файлов и папок.

Для этого сайта мой правильный robots для modx был вот таким:

User-agent: * Disallow: /assets/cache/ Disallow: /assets/docs/ Disallow: /assets/export/ Disallow: /assets/import/ Disallow: /assets/modules/ Disallow: /assets/plugins/ Disallow: /assets/snippets/ Disallow: /install/ Disallow: /manager/ Host: ms-autotech.ru Sitemap: http://ms-autotech.ru/sitemap.xml

User-agent: * Disallow: /assets/cache/ Disallow: /assets/docs/ Disallow: /assets/export/ Disallow: /assets/import/ Disallow: /assets/modules/ Disallow: /assets/plugins/ Disallow: /assets/snippets/ Disallow: /install/ Disallow: /manager/

Host: ms-autotech.ru Sitemap: http://ms-autotech.ru/sitemap.xml |

Обязательно сделайте sitemap, чтобы поисковый робот занес к себе в базу нужные страницы.

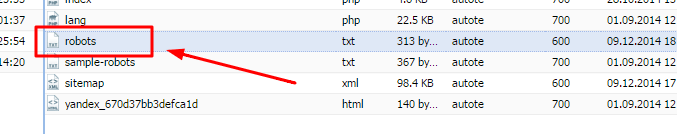

Далее все просто. Сохраняете выше приведенную инструкцию в файлик с расширением robots.txt и заливаете его в корень вашего сайта, как это показано у меня вот здесь:

И с последующей переиндексацией служебные и ненужные страницы не будут ранжироваться и показываться во всех поисковых системах, поскольку вы указали следующее правило User-agent: * , эта запись говорит, что содержимое должны сканировать все без исключения роботы.

Важно! Если вы не используете на своем сайте файл robots.txt, то вы сильно рискуете в продвижении своего проекта в интернете. В индекс будет попадать весь «мусор» и поисковые системы просто будут понижать вас в выдаче и не давать вашему сайту пробиться в ТОП. Внимательно отнеситесь к этому.

На этом урок завершен. Записал небольшое короткое видео для любителей посмотреть все в живую. Всем спасибо и до встречи в следующих выпусках!

smarticle.ru