Какие страницы сайта WordPress не нужно индексировать. Закрыть wordpress от индексации

Закрыть сайт, домен от индексации

У каждого вебмастера или SEO-оптимизатора рано или поздно возникает необходимость закрыть сайт от индексации поисковыми роботами. Причиной тому является то, что роботу не стоит «видеть» Ваш сайт вообще. По каким причинам роботу не стоит индексировать сайт?

Во-первых, закрыть домен от индексации нужно в случае, когда Вы начинаете только-только создавать сайт, наполняете его контентом или же он просто создается, как демо-версия будущего полноценного. Я, обычно, закрываю сайт от индексации в момент, как купил домен и установил CMS на хостинг. Когда же его не стыдно будет показать людям — нужно снять запрет индексации.

И так, как закрыть сайт от индексации? Все предельно просто. Для этого нужно внести изменения в файл robots.txt. Смотрим пример ниже.

User-agent: * Disallow: /Данные строчки определяют, что необходимо закрыть индексацию главной страницы (Disallow: /) всем поисковым роботам (User-agent: *). Остальные разделы сайта указывать нет смысла, так как закрыта уже главная страница. Когда нужно закрыть доступ от индекса конкретному роботу, например Яндексу, пишем следующее:

Конечно, такое используется крайне редко, но все же имеет место на практике. Вместо Yandex можно указать любого другого робота ПС.

Если в файле robots.txt указано следующее:

User-agent: *Disallow: /

User-agent: GoogleDisallow: /

В любом случае будет закрыт от индексации сайт для всех поисковых роботов, так как указано *, что нивелирует последующие строки.

В CMS WordPress можно закрыть сайт от индексации через админку: «Настройки—>Чтение—>Рекомендовать поисковым машинам не индексировать сайт«. Конечно же гарантий того, что робот не проиндексирует сайт нету, но ленивые могут воспользоваться.

На этом всё. Надеюсь, инструкция Вам пригодится.

С уважением, Блог свободного человека!

web-ru.org

Как закрыть ссылки от индексации в Wordpress? И как их открыть?

В данной статье рассмотрим такие вопросы: «Как закрыть в WordPress внешние ссылки от индексации?» и «Как сделать ссылки в комментариях блога DoFollow?». Статья в категории плагинов, поэтому делать все будем именно с их использованием.

Но для начала необходимо разобрать, для чего вообще нужно что-либо открывать и закрывать.

Если вебмастер не уверен в качестве ресурса, на который ведет ссылка, то он закрывает ее от индексации с помощью атрибута rel=”nofollow”. Поисковые системы Яндекс и Гугл, видя у ссылки данное значение, не будут по ней переходить, а так же не будут передавать вес.

А теперь вполне резонный вопрос: «А зачем тогда открывать ссылки для индексации поисковиками, делать их Dofollow, если в таком случае будет передаваться вес?».

Тут все достаточно просто: те, кто занимается продвижение сайтов, используют комментарии Dofollow блогов как неисчерпаемый ресурс, где можно добыть бесплатные внешние ссылки. А ссылки, как известно, оказывают определенное влияние на продвижение сайта, пусть и не такое сильное как раньше.

Вебмастера же используют это в своих целях, а именно – автоматическое наполнение сайта или блога контентом (комментариями). А так же это создает некую оживленность на блоге, точнее ее видимость, так как сообщения по факту оставляются спаммерами. Но даже в таком случае посетители, увидев сумасшедшее количество комментариев на блоге, будут испытывать определенное доверие к автору. И не исключено что даже добавят страницу в закладки.

Плагин WP No External Links – закрываем ссылки от индексации

Плагин WP No External Links – отличный WordPress плагин, позволяющий не только автоматически добавлять всем ссылками атрибут, закрывающий ссылки от индексации, но так же делать из внешней ссылки внутреннюю с помощью редиректа. В настройках плагина это указывается как – «маскировка» ссылки. Кстати этот же метод «маскировки» используется для того, чтобы скрыть реферальные ссылки.

Плагин можно скачать и установить из админки Вордпресс, либо отсюда: http://wordpress.org/plugins/wp-noexternallinks/

Перейдем к настройкам:

Маскировать ссылки в постах – закрытие ссылок от индексации внутри тела статьи.

Маскировать ссылки в комментариях – маскировка ссылки внутри комментария.

Маскировать ссылки комментаторов – данная опция скроет ссылки в имени комментатора от поисковиков.

Добавлять rel=nofollow – добавление значения nofollow для атрибута rel.

Добавлять target=”_blank” – очень полезная опция, которая добавляет target=”_blank” всем внешним ссылкам. Включив данную опцию все внешние ссылки будут открываться в новом окне. Для оптимизации сайта данный параметр имеет важное значение.

Добавлять теги noindex – целесообразность использования данного параметра можно поставить под сомнение, так как rel=”nofollow” вполне хватит, для того чтобы поисковые системы Яндекс и Google поняли, что переходить по этой ссылке не нужно.

Не маскировать ссылки при помощи редиректа – лично мое мнение, эту функцию необходимо включить. Поисковики постоянно твердят: «Сайт должен быть естественным!». Что может быть более естественным, чем простая внешняя ссылка?

А теперь последний штрих: вышеописанный плагин не позволяет открыть для индексации ссылки в имени автора, при отправке комментария.

С этой задачей поможет справится плагин – Do Follow. О его настройках писать ничего не буду, по одной простой причине – их нет. Плагин выполняет все свои функции сразу после его активации. Скачать можно все оттуда же – из админки WP.

needsite.net

Закрыть от индексации страницу на wordpress без robots txt — ТОП

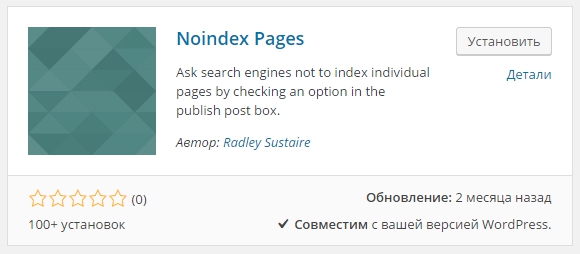

С помощью плагина — Noindex Pages вы сможете скрыть от индексации поисковыми системами любую страницу на вашем сайте wordpress. Если вы хотите чтобы определённая страница вашего сайта не попадала в поисковые системы, то вы можете воспользоваться данным плагином. Установить плагин вы сможете прямо из админ-панели wordpress. Перейдите на страницу: Плагины — Добавить новый, введите название плагина в форму поиска, нажмите Enter, установите и активируйте плагин.

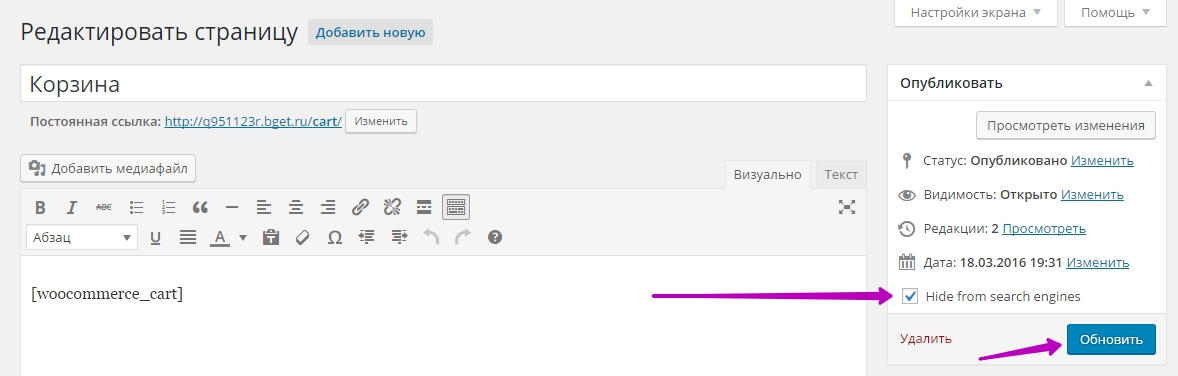

После установки и активации плагина, перейдите на страницу редактирования страницы, которую вы хотите скрыть от индексации поисковыми системами. На странице справа, в виджете Опубликовать, у вас появится новое значение — Hide from search engines, что означает — скрыть от поисковой системы. Поставьте галочку возле данного значения и обновите страницу.

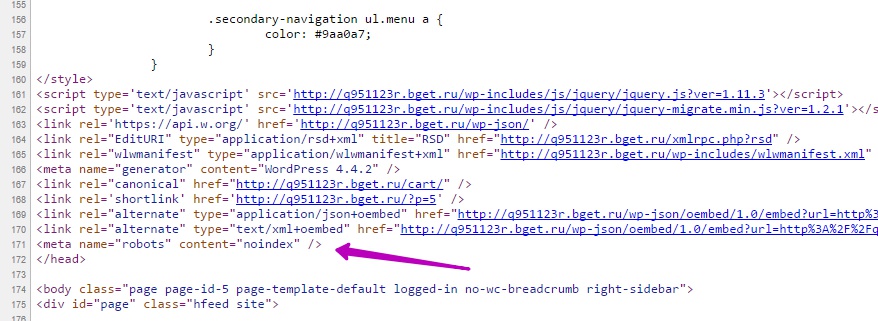

Чтобы проверить, что ваша страница действительно скрывается от поисковых систем, перейдите на страницу. Откройте исходный код страницы с помощью правой кнопки мыши, в коде должен появиться специальный мета тег noindex, который запрещает поисковым роботам индексировать страницу. Чтобы быстро найти мета тег, вы можете воспользоваться поиском по странице, нажав на сочетание клавиш Ctrl + F.

Чтобы удалить мета тег из кода, то просто деактивируйте плагин.

info-effect.ru

Гибкое закрытие индексации на примере WordPress CMS

Гибкое закрытие индексации на примере WordPress CMS

Фрилансеру стоит больше всего опасаться заказчиков, любящих употреблять слова «сайтик», «простенький», «логотипчик», потому что нередко бюджет у них тоже с уменьшительно-ласкательным суффиксом.С weblancer.net

В продолжении статьи об отличиях индексации через robots.txt и meta расскажу о гибкой настройке индексации. Все примеры привожу для WordPress CMS, однако уверен, что идентичные аналоги этих способов есть и у других развитых CMS.

Иногда бывает так, что пока вы чухались с перекрытием индексации, какая-то категория или какой-то тег уже начались неплохо собирать трафик. Что ж, теперь придется оставлять открытыми для индексации отдельно взятую категорию или тег. Как это сделать? В случае с WP я знаю несколько вариантов.

1. Conditional Comments: в header.php в разделе <head> вставляем

<? if(is_archive() || is_tag() || is_category() && !(is_category('78'))) {<code><meta name="robots" content="noindex,follow" />} ?>

Этот код закроет от индексации через meta страницы архивов, тегов и всех категорий кроме категории с id=78. Аналогично условие с id можно применить и к тегам. Естественно, при этом вы не должны использовать для закрытия индексации robots.txt, так как его приоритет является самым высоким. Плагины типа All in One SEO Pack также могут перебивать условия индексации, заданные в Conditional Comments, потому при использовании плагинов рекомендуется отказаться от использования их опций индексации.

По аналогии с Conditional Comments в других движках можно использовать $_SERVER['REQUEST_URI'].

2. Robots Meta: если речь идет о постах или страницах (может быть и такое), то можно воспользоваться плагином robots meta, который для каждой страницы/записи создаст чекбоксы со всевозможными вариантами index и follow.

3. Custom Post/Page Template. Не слишком рациональный способ, однако он есть, потому расскажу и про него. Использовать этот способ можно для закрытия индексации страниц и записей. В WordPress при помощи функций/плагинов можно подключать для страниц/записей отдельные шаблоны, которые нужно поместить в папку темы с соответствующим заголовком. При подключении поддержки отдельных шаблонов на странице создания страницы/записи у вас появится выпадающий список со всеми доступными шаблонами, благодаря чему вы легко сможете оформлять одни страницы/посты одним образом, другие — другим, применяя любое количество заранее созданных шаблонов. Немножко сумбурно, но по хорошему этому нужно посвятить целый пост, здесь же я лишь рассказал о существовании такой возможности в WordPress. В общем, имея возможность использовать различные шаблоны для различных страниц, вы можете практически любым способом (кроме robots.txt, при его использовании у него максимальный приоритет) закрыть индексацию набора страниц/записей, а для тех, закрывать которые не надо, использовать другой шаблон, на который ваши средства перекрытия индексации не будут иметь влияние.

4. Используя иерархию шаблонов WordPress: способ аналогичен предыдущему с одним отличием — используя иерархию шаблонов можно использовать различные шаблоны для абсолютно любой базовой единицы WP, будь то страница/запись/метка/категория и т.п. Про иерархию шаблонов WP здесь. Также как и в предыдущем методе мы просто создаем открытый/закрытый для индексации шаблон для нужной нам страницы или набора страниц сайта.

По возможности рекомендую обходиться первым и вторым способами. Третий и четвертый способы приведены для очень неординарный редких случаев.

В приведенных способах отсутствует закрытие через robots.txt, поскольку я считаю, что robots.txt подходит больше для глобального закрытия от индексации больших зон сайта и при этом не является гибким методом, поскольку чтобы оставить какую-либо страницу перекрываемой, к примеру, категории индексируемой, нам придется перечислить в robots.txt абсолютно все страницы категории кроме данной, т.к. директива Allow вопреки мнению многих, для этого файла неприемлема.

И в завершение небольшое видео о том, как создать произвольный шаблон для страниц (custom page template) в WordPress:

Полезные источники:

http://blogto4ka.ru

Также рекомендую прочесть

blogto4ka.ru

Как закрыть внешние ссылки от индексации Wordpress

Установка плагина для закрытия внешних ссылок от индексации

Данный плагин является бесплатным и простым решением для закрытия всех внешних ссылок автоматически, без Вашего участия. Чтобы установить его переходим в раздел с плагинами в панели управления WordPress и жмём «Добавить новый», в поле поиска вводим Nofollow for external link. После этого первый в списке увидите плагин, на всякий случай проверьте название и жмите кнопку «Установить» и потом «Активировать».

После этого первый в списке увидите плагин, на всякий случай проверьте название и жмите кнопку «Установить» и потом «Активировать».

Настройка плагина для закрытия внешних ссылок от индексации

После установки и активации плагина в настройках появится раздел «Nofollow extlink» — переходим в него. Как я уже говорил плагин весьма прост в настройке — здесь нужно только отметить добавлять ли тег «nofollov» в меню (если в меню нет ссылок на другие сайты то делать этого не нужно) и добавить домены-исключения.

- Защита репутации сайта в глазах поисковых систем

- Значительное уменьшение количества СПАМа в комментариях, т.к. причин для него становится меньше)

yablogo.su

Какие страницы сайта WordPress не нужно индексировать

В совершенстве, наш сайт должен обеспечивать максимально открытый и полный доступ к индексации полезного контента как пользователей, так и поисковый машин, но в то же время скрывать все технические страницы и дублирующий контент сайта/блога.

Но к сожалению, подобное в WordPress по-умолчанию бывает крайне редко (а точнее никогда), и поэтому об этом должен позаботиться сам вебмастер, используя такие приемы как: добавление файла robots.txt, в котором прописывается табу для поисковых систем (более подробно о robots, можно прочитать в статье “Зачем нужен файл robots.txt?“, а также “Правильный файл robots.txt для WordPress“), использование закрывающих тегов “Noindex/Nofollow“, и конечно не попадание в индексацию дублирующих страниц предусмотрено плагином All In One SEO Pack.

Зачем нужно закрывать подобную информацию от поисковых систем? Поисковики крайне негативно относятся к ресурсам, на которых находится большое количество дублирующего контента, а также технической информации (к примеру данные о зарегистрированных пользователях), и как следствие, могут быть наложены некие санкции, которые будут портить нам жизнь.

Давайте обозначим основные пункты, которые желательно закрыть от индексации поисковыми системами:

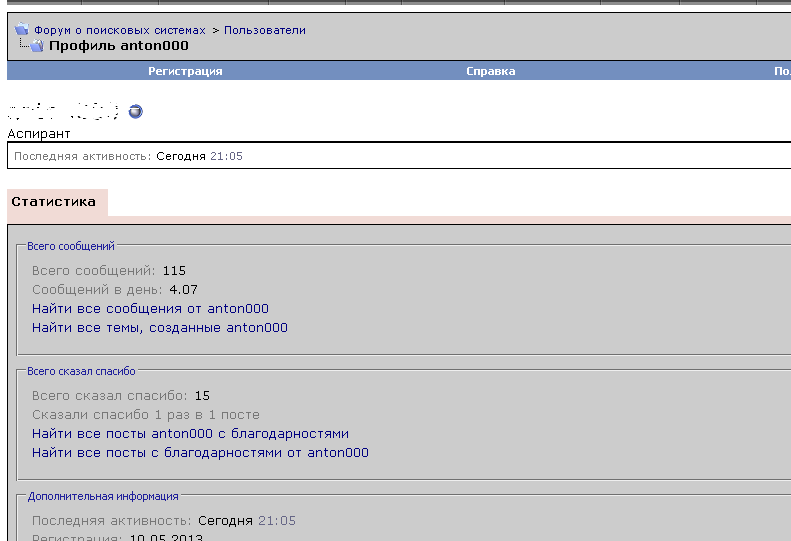

Данные о зарегистрированных пользователях.

По сути, что такое информация о зарегистрированном пользователе? Это совсем небольшая страничка на сайте, в которой прописано всего пара фраз о пользователе: его имя и e-mail, которая не несет в себе совершенно никакой полезной информации. А ведь таких пользователей может быть несколько тысяч, а это значит – несколько тысяч одинаковых страниц.

RSS — лента

Ее желательно также закрыть от индексации, так как не всегда поисковые системы корректно работают с данной системой (в особенности на данный момент). При переходе поискового робота на RSS ленту, у него чаще всего возникает несколько десятков ошибок, которые повторяются раз за разом, при их посещении вашей rss ленты.

Данный пункт весьма индивидуален, и если вы не замечаете особых проблем с индексацией rss, то закрывать от индексации ленту новостей не стоит.

Страницы – дубли

Это пожалуй самая распространенная проблема большинства WordPress блогов, поскольку поисковые роботы, а в особенности Google, индексируют все без разбору, а значит могут проиндексировать одну и ту же страницу несколько раз, но под разными url адресами. Подобные страницы необходимо закрывать от индексации.

К примеру, если страница находится в общем списке, а также в списке тегов, то получается дубль одной и той же страницы. Поэтому последний список лучше закрыть от индексирования. Также в этом нам помогает правильно настроенный плагин All In One SEO Pack (или подобный), который по большей части не допускает индексации дублированного контента.

Облако тегов или Облако меток

Вы наверное не раз замечали на многих сайтах различные виды облака тегов, которые как правило расположены в сайдбаре? Это по сути просто набор ключевых слов, расположенных в виде списка, или круга тех же ключевых слов, который вращается.

Подобную фишку лучше не использовать вовсе или закрыть тегами noindex и nofollow, поскольку для поисковых систем, подобное видится обычным списком ключевых слов, которые представляют собой какой-то бессмысленный набор слов, расположенных в хаотичном порядке.

Внешние ссылки

И конечно же стоит забывать о внешних ссылках, особенно которые обитают на вашем сайте без вашего ведома. Подобные ссылки необходимо закрыть от индексации закрывающими тегами noindex и nofollow, или если есть возможность вообще их удалить. Как выявить и обезвредить все внешние ссылки можно прочитать в статье “Определяем количество внешних ссылок на сайте, после чего закрываем их тегами noindex и nofollow“.

Также многие вебмастеры закрывают индексацию ссылок в комментариях, так как считается, что подобные ссылки отдают достаточно большой “вес” посторонним сайтам. Но конечно же бездумно закрывать вообще все комментарии не следует, поскольку бывают случаи, что благодаря грамотным комментариям пользователей, страница часто вырывается в ТОП поискового запроса.

comments powered by HyperCommentswordpressmaster.ru

Какие страницы закрывать от индексации и как

Любая страница на сайте может быть открыта или закрыта для индексации поисковыми системами. Если страница открыта, поисковая система добавляет ее в свой индекс, если закрыта, то робот не заходит на нее и не учитывает в поисковой выдаче.

При создании сайта важно на программном уровне закрыть от индексации все страницы, которые по каким-либо причинам не должны видеть пользователи и поисковики.

К таким страницам можно отнести административную часть сайта (админку), страницы с различной служебной информацией (например, с личными данными зарегистрированных пользователей), страницы с многоуровневыми формами (например, сложные формы регистрации), формы обратной связи и т.д.

Пример:Профиль пользователя на форуме о поисковых системах Searchengines.

Обязательным также является закрытие от индексации страниц, содержимое которых уже используется на других страницах.Такие страницы называются дублирующими. Полные или частичные дубли сильно пессимизируют сайт, поскольку увеличивают количество неуникального контента на сайте.

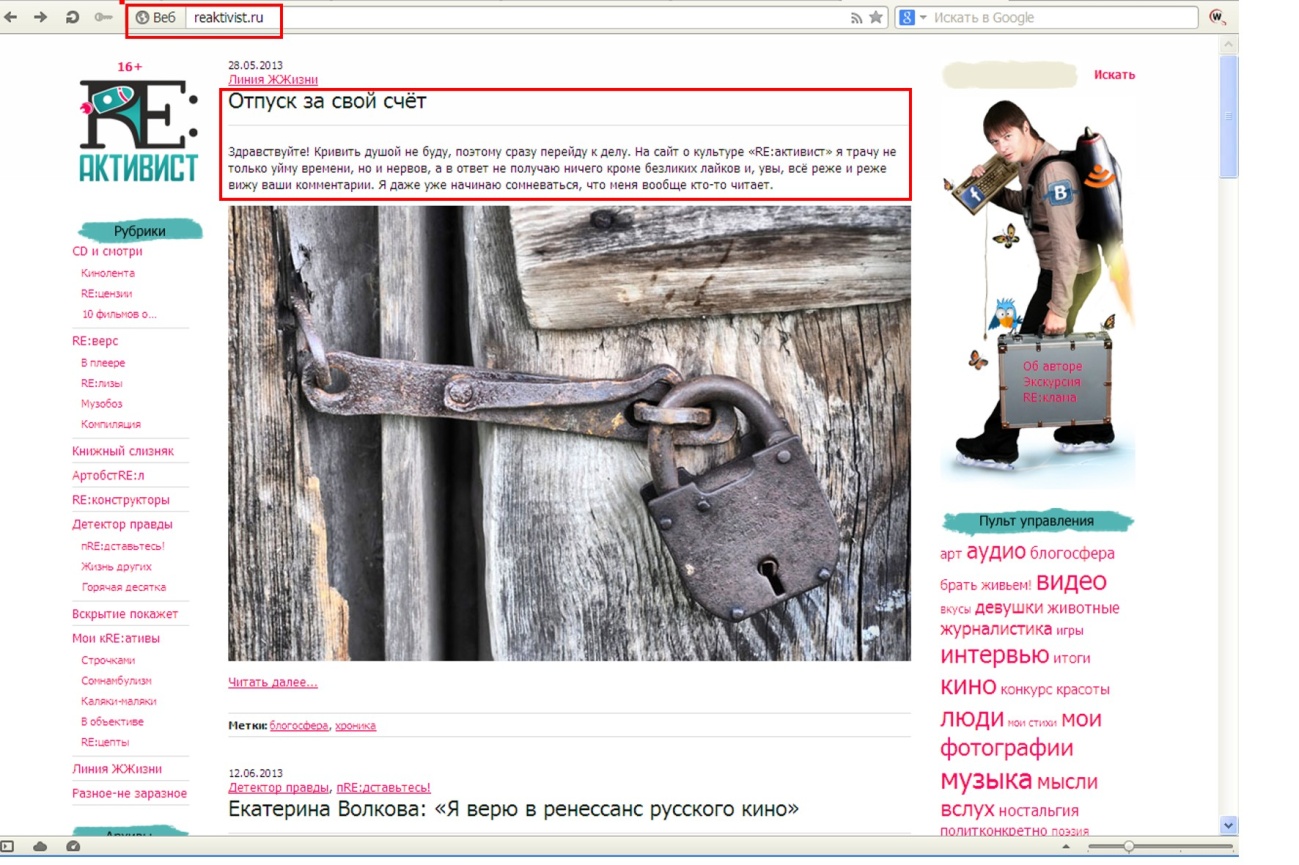

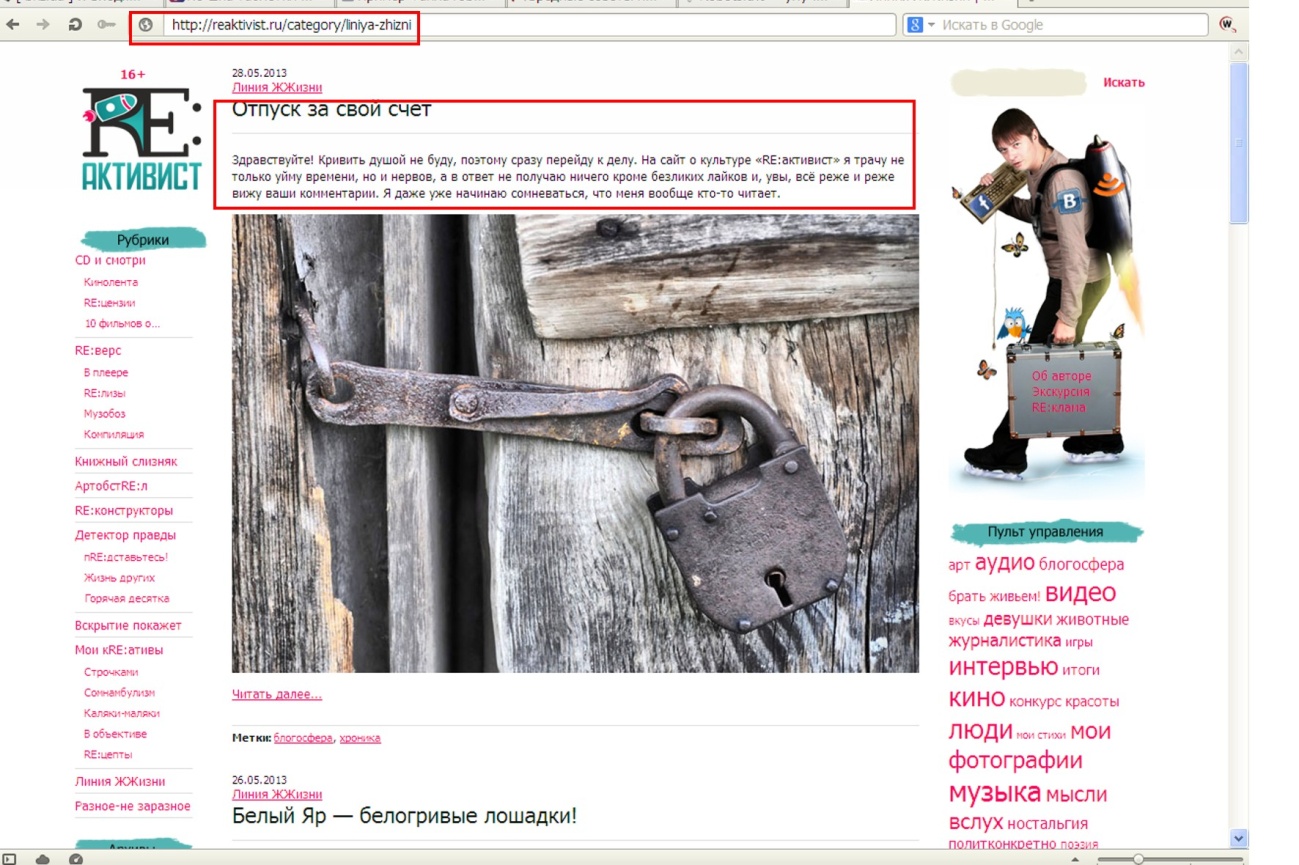

Пример:Типичный блог на CMSWordPress, который содержит дубли.

http://reaktivist.ru/ — главная страница.

http://reaktivist.ru/category/liniya-zhizni — страница категории.

Как видим, контент на обеих страницах частично совпадает. Поэтому страницы категорий на WordPress-сайтах закрывают от индексации, либо выводят на них только название записей.

То же самое касается и страниц тэгов– такие страницы часто присутствуют в структуре блогов на WordPress. Облако тэгов облегчает навигацию по сайту и позволяет пользователям быстро находить интересующую информацию. Однако они являются частичными дублями других страниц, а значит – подлежат закрытию от индексации.

Еще один пример – магазин на CMS OpenCart.

Страница категории товаров http://www.masternet-instrument.ru/Lampy-energosberegajuschie-c-906_910_947.html.

Страница товаров, на которые распространяется скидка http://www.masternet-instrument.ru/specials.php.

Данные страницы имеют схожее содержание, так как на них размещено много одинаковых товаров.

Особенно критично к дублированию контента на различных страницах сайта относится Google. За большое количество дублей в Google можно заработать определенные санкции вплоть до временного исключения сайта из поисковой выдачи.

Мы рекомендуем закрывать страницу от индексации, если она содержит более 40 % контента с другой страницы. В идеале структуру сайта нужно создавать таким образом, чтобы дублирования контента не было вовсе.

Примечание:Для авторитетных сайтов с большим количеством страниц и хорошей посещаемостью (от 3000 человек в сутки) дублирование не столь существенно, как для новых сайтов.

Еще один случай, когда содержимое страниц не стоит «показывать» поисковику – страницы с неуникальным контентом. Типичный пример — инструкции к медицинским препаратам в интернет-аптеке. Контент на странице с описанием препарата http://www.piluli.ru/product271593/product_info.html неуникален и опубликован на сотнях других сайтов.

Сделать его уникальным практически невозможно, поскольку переписывание столь специфических текстов – дело неблагодарное и запрещенное. Наилучшим решением в этом случае будет закрытие страницы от индексации, либо написание письма в поисковые системы с просьбой лояльно отнестись к неуникальности контента, который сделать уникальным невозможно по тем или иным причинам.

Как закрывать страницы от индексации

Классическим инструментом для закрытия страниц от индексации является файл robots.txt. Он находится в корневом каталоге вашего сайта и создается специально для того, чтобы показать поисковым роботам, какие страницы им посещать нельзя. Это обычный текстовый файл, который вы в любой момент можете отредактировать. Если файла robots.txt у вас нет или если он пуст, поисковики по умолчанию будут индексировать все страницы, которые найдут.

Структура файла robots.txt довольно проста. Он может состоять из одного или нескольких блоков (инструкций). Каждая инструкция, в свою очередь, состоит из двух строк. Первая строка называется User-agent и определяет, какой поисковик должен следовать этой инструкции. Если вы хотите запретить индексацию для всех поисковиков, первая строка должна выглядеть так:

User-agent: *

Если вы хотите запретить индексацию страницы только для одной ПС, например, для Яндекса, первая строка выглядит так:

User-agent: Yandex

Вторая строчка инструкции называется Disallow (запретить). Для запрета всех страниц сайта напишите в этой строке следующее:

Disallow: /

Чтобы разрешить индексацию всех страниц вторая строка должна иметь вид:

Disallow:

В строке Disallow вы можете указывать конкретные папки и файлы, которые нужно закрыть от индексации.

Например, для запрета индексации папки images и всего ее содержимого пишем:

User-agent: *

Disallow: /images/

Чтобы «спрятать» от поисковиков конкретные файлы, перечисляем их:

User-agent: *Disallow: /myfile1.htmDisallow: /myfile2.htmDisallow: /myfile3.htm

Это – основные принципы структуры файла robots.txt. Они помогут вам закрыть от индексации отдельные страницы и папки на вашем сайте.

Еще один, менее распространенный способ запрета индексации – мета-тэг Robots. Если вы хотите закрыть от индексации страницу или запретить поисковикам индексировать ссылки, размещенные на ней, в ее HTML-коде необходимо прописать этот тэг. Его надо размещать в области HEAD, перед тэгом <title>.

Мета-тег Robots состоит из двух параметров. INDEX – параметр, отвечающий за индексацию самой страницы, а FOLLOW – параметр, разрешающий или запрещающий индексацию ссылок, расположенных на этой странице.

Для запрета индексации вместо INDEX и FOLLOW следует писать NOINDEX и NOFOLLOW соответственно.

Таким образом, если вы хотите закрыть страницу от индексации и запретить поисковикам учитывать ссылки на ней, вам надо добавить в код такую строку:

<meta name=“robots” content=“noindex,nofollow”>

Если вы не хотите скрывать страницу от индексации, но вам необходимо «спрятать» ссылки на ней, мета-тег Robots будет выглядеть так:

<metaname=“robots” content=“index,nofollow”>

Если же вам наоборот, надо скрыть страницу от ПС, но при этом учитывать ссылки, данный тэг будет иметь такой вид:

<meta name=“robots” content=“noindex,follow”>

Большинство современных CMS дают возможность закрывать некоторые страницы от индексации прямо из админ.панели сайта. Это позволяет избежать необходимости разбираться в коде и настраивать данные параметры вручную. Однако перечисленные выше способы были и остаются универсальными и самыми надежными инструментами для запрета индексации.

seo.gruz0.ru