Как оптимизировать файл WordPress Robots для SEO. Robots txt wordpress настройка

Правильная настройка robots.txt для Google и Яндекс

Тема настройки robots.txt сотни раз поднималась на разных форумах, про нее написано на сотнях блогов. И все же, я видел очень мало сайтов, у которых данный файл настроен абсолютно корректно. Поэтому решил написать статью о том, как правильно настраивать robots.txt, исходя из рекомендаций ПС Google и Яндекс, а также собственного опыта.

Основные правила настройки robots.txt

Перед тем, как приступить к настройке роботса для вашего сайта, советую ознакомиться с официальными рекомендациями Яндекс и Google. Однако, как обычно и бывает, информация там не  очень легкая для восприятия, именно поэтому я пишу данный гайд.

очень легкая для восприятия, именно поэтому я пишу данный гайд.

Теперь о том, что должно быть в файле robots.txt. По моему мнению, в нем необходимо создавать 3 отдельные наборы директив — для Яндекс, для Google, и для остальных роботов-краулеров. Почему отдельно? Да потому что есть директивы, предназначенные только для определенных ПС, а также можете считать это неким проявлением уважения к основным поисковикам рунета 🙂

Следовательно, роботс должен состоять из таких секций:

Web@District - ответы на вопросы SEO, которые вас давно интересуют

User-agent: * User-agent: Yandex User-agent: Googlebot

User-agent: * User-agent: Yandex User-agent: Googlebot |

Между наборами директив для разных роботов необходимо оставлять пустую строку.

В robots.txt необходимо указать путь к XML карте сайта. Директива является межсекционной, поэтому она может быть размещена в любом месте файла, однако перед ней рекомендуется вставить пустой перевод строки. Запись должна выглядеть так:

Sitemap: http://site.com/sitemap.xml

Sitemap: http://site.com/sitemap.xml |

Адрес сайта и сам путь к карте необходимо заменить на те, которые являются актуальными для вашего сайта. Также следует помнить, что для сайтов с большим количеством страниц (более 50 000) необходимо создать несколько карт и все их прописать в роботсе.

Настройка robots.txt для Яндекс

Для того, чтобы наглядно показать правильную настройку директив для Яши, я возьму в качестве примера стандартный robots.txt для WordPress.

User-agent: Yandex Disallow: /cgi-bin Disallow: /wp-admin Disallow: /wp-includes Disallow: /wp-content/plugins Disallow: /wp-content/cache Disallow: /wp-content/themes Disallow: /wp-trackback Disallow: /wp-feed Disallow: */trackback Disallow: */feed

User-agent: Yandex Disallow: /cgi-bin Disallow: /wp-admin Disallow: /wp-includes Disallow: /wp-content/plugins Disallow: /wp-content/cache Disallow: /wp-content/themes Disallow: /wp-trackback Disallow: /wp-feed Disallow: */trackback Disallow: */feed |

Обратите внимание на отсутствие директивы Host для Яндекса. Она указывала пауку-роботу Яндекса, какое из зеркал сайта является главным. Директива прекратила существование в начале весны 2018 года, о чем есть соответствующая запись в блоге Яндекса.

Проверить корректность настройки robots.txt для Яндекса можно при помощи данного сервиса.

Настройка robots.txt для Google

Для Google настройка роботса мало чем отличается от уже написанного выше. Однако, есть пара моментов, на которые следует обратить внимание.

User-agent: Googlebot Allow: *.css Allow: *.js Disallow: /cgi-bin Disallow: /wp-admin Disallow: /wp-includes Disallow: /wp-content/plugins Disallow: /wp-content/cache Disallow: /wp-content/themes Disallow: /wp-trackback Disallow: /wp-feed Disallow: */trackback Disallow: */feed

User-agent: Googlebot Allow: *.css Allow: *.js Disallow: /cgi-bin Disallow: /wp-admin Disallow: /wp-includes Disallow: /wp-content/plugins Disallow: /wp-content/cache Disallow: /wp-content/themes Disallow: /wp-trackback Disallow: /wp-feed Disallow: */trackback Disallow: */feed |

Как видно из примера, появились две директивы, разрешающие индексировать JS скрипты и CSS таблицы. Это связано с рекомендацией Google, в которой говорится, что следует разрешать роботу индексировать файлы шаблона (темы) сайта. Естественно, скрипты и таблицы в поиск не попадут, однако это позволит роботам корректнее индексировать сайт и отображать его в результатах выдачи. Данные директивы я внедрил не на один десяток сайтов и по крайней мере, лишние страницы в выдаче не появились.

Ну а корректность настройки директив для Google вы можете проверить инструментом проверки файла robots.txt, который находится в Google Webmaster Tools.

Что еще стоит закрывать в роботсе?

Конечно, статья была бы далеко не полной, если бы я не рассказал, какие файлы и папки следует закрывать от индексирования.

- Страницы поиска. Тут кое-кто может поспорить, так как бывают случаи, когда на сайте используют внутренний поиск именно для создания релевантных страниц. Однако, так поступают далеко не всегда и в большинстве случаев открытые результаты поиска могут наплодить невероятное количество дублей. Поэтому мой вердикт — закрыть.

- Корзина и страница оформления/подтверждения заказа. Данная рекомендация актуальна для интернет-магазинов и других коммерческих сайтов, где есть форма заказа. Данные страницы ни в коем случае не должны попадать в индекс ПС.

- Фильтры и сравнение товаров. Рекомендация относится к интернет-магазинам и сайтам-каталогам.

- Страницы регистрации и авторизации. Информация, которая вводится при регистрации или входе на сайт, является конфиденциальной. Поэтому следует избегать индексации подобных страниц, Google это оценит.

- Системные каталоги и файлы. Каждый сайт состоит из множества данных — скриптов, таблиц CSS, административной части. Такие файлы следует также ограничить для просмотра роботам.

Замечу, что для выполнения некоторых из вышеописанных пунктов можно использовать и другие инструменты, например, rel=canonical, про который я позже напишу в отдельной статье. Кроме этого, не подходите к рекомендациям буквально — всегда есть исключения. Например, фильтры в некоторых магазинах имеют свои чпу, уникальные мета, контент. Конечно, не надо такие страницы закрывать — это дополнительные релевантные страницы под ключи.

Мой вариант robots.txt для WordPress и Joomla

Дописываю эти строки спустя какое-то время после написания статьи. Дело в том, что несмотря на пользу различных директив и объяснении мною их функций, я забыл добавить информацию о том, как должен выглядеть роботс в конечном итоге. Поэтому добавляю мои наборы директив для двух моих любимых и часто используемых CMS — WordPress и Joomla. Естественно, не забывайте, что некоторые параметры вам понадобится дописать самим, поэтому обязательно ознакомьтесь с рекомендациями Google и Яндекс (ссылки на оф. источники во втором абзаце данной статьи).

robots.txt для WordPress

User-agent: * Disallow: /cgi-bin Disallow: /wp-admin Disallow: /wp-includes Disallow: /wp-content/plugins Disallow: /wp-content/cache Disallow: /wp-content/themes Disallow: */trackback Disallow: */feed Disallow: /*? Disallow: /author/ Disallow: /transfers.js Disallow: /go.php Disallow: /xmlrpc.php User-agent: Yandex Disallow: /cgi-bin Disallow: /wp-admin Disallow: /wp-includes Disallow: /wp-content/plugins Disallow: /wp-content/cache Disallow: /wp-content/themes Disallow: */trackback Disallow: */feed Disallow: /*? Disallow: /author/ Disallow: /transfers.js Disallow: /go.php Disallow: /xmlrpc.php User-agent: Googlebot Allow: *.css Allow: *.js Allow: /wp-includes/*.js Disallow: /cgi-bin/ Disallow: /wp-admin/ Disallow: /wp-includes/ Disallow: /wp-content/cache Disallow: */trackback Disallow: */feed Disallow: /author/ Disallow: /transfers.js Disallow: /go.php Disallow: /xmlrpc.php Disallow: /*? Sitemap: http://site.com/sitemap.xml

|

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 |

User-agent: * Disallow: /cgi-bin Disallow: /wp-admin Disallow: /wp-includes Disallow: /wp-content/plugins Disallow: /wp-content/cache Disallow: /wp-content/themes Disallow: */trackback Disallow: */feed Disallow: /*? Disallow: /author/ Disallow: /transfers.js Disallow: /go.php Disallow: /xmlrpc.php

User-agent: Yandex Disallow: /cgi-bin Disallow: /wp-admin Disallow: /wp-includes Disallow: /wp-content/plugins Disallow: /wp-content/cache Disallow: /wp-content/themes Disallow: */trackback Disallow: */feed Disallow: /*? Disallow: /author/ Disallow: /transfers.js Disallow: /go.php Disallow: /xmlrpc.php

User-agent: Googlebot Allow: *.css Allow: *.js Allow: /wp-includes/*.js Disallow: /cgi-bin/ Disallow: /wp-admin/ Disallow: /wp-includes/ Disallow: /wp-content/cache Disallow: */trackback Disallow: */feed Disallow: /author/ Disallow: /transfers.js Disallow: /go.php Disallow: /xmlrpc.php Disallow: /*?

Sitemap: http://site.com/sitemap.xml |

Обратите внимание, что директиву Sitemap в вашем роботсе нужно заменить на необходимые вам.

robots.txt для Joomla

User-agent: * Disallow: /administrator/ Disallow: /cache/ Disallow: /cli/ Disallow: /components/ Disallow: /includes/ Disallow: /language/ Disallow: /libraries/ Disallow: /logs/ Disallow: /media/ Disallow: /system/ Disallow: /modules/ Disallow: /plugins/ Disallow: /templates/ Disallow: /tmp/ Disallow: /component/ Disallow: /*start Disallow: /*searchword User-agent: Yandex Disallow: /administrator/ Disallow: /cache/ Disallow: /cli/ Disallow: /components/ Disallow: /includes/ Disallow: /language/ Disallow: /libraries/ Disallow: /logs/ Disallow: /system/ Disallow: /media/ Disallow: /modules/ Disallow: /plugins/ Disallow: /templates/ Disallow: /tmp/ Disallow: /component/ Disallow: /*start Disallow: /*searchword User-agent: Googlebot Allow: *.css Allow: *.js Disallow: /administrator/ Disallow: /cli/ Disallow: /components/ Disallow: /includes/ Disallow: /language/ Disallow: /libraries/ Disallow: /logs/ Disallow: /system/ Disallow: /media/ Disallow: /modules/ Disallow: /plugins/ Disallow: /tmp/ Disallow: /component/ Disallow: /*start Disallow: /*searchword Sitemap: http://site.com/sitemap.xml

|

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 |

User-agent: * Disallow: /administrator/ Disallow: /cache/ Disallow: /cli/ Disallow: /components/ Disallow: /includes/ Disallow: /language/ Disallow: /libraries/ Disallow: /logs/ Disallow: /media/ Disallow: /system/ Disallow: /modules/ Disallow: /plugins/ Disallow: /tmp/ Disallow: /component/ Disallow: /*start Disallow: /*searchword

User-agent: Yandex Disallow: /administrator/ Disallow: /cache/ Disallow: /cli/ Disallow: /components/ Disallow: /includes/ Disallow: /language/ Disallow: /libraries/ Disallow: /logs/ Disallow: /system/ Disallow: /media/ Disallow: /modules/ Disallow: /plugins/ Disallow: /templates/ Disallow: /tmp/ Disallow: /component/ Disallow: /*start Disallow: /*searchword

User-agent: Googlebot Allow: *.css Allow: *.js Disallow: /administrator/ Disallow: /cli/ Disallow: /components/ Disallow: /includes/ Disallow: /language/ Disallow: /libraries/ Disallow: /logs/ Disallow: /system/ Disallow: /media/ Disallow: /modules/ Disallow: /plugins/ Disallow: /tmp/ Disallow: /component/ Disallow: /*start Disallow: /*searchword

Sitemap: http://site.com/sitemap.xml |

Замечу, что в наборе поисковых правил для Joomla я закрыл пагинацию страниц в разделах, а также страницу поиска по сайту. Если вам необходимы данные страницы в поиске — можете убрать из robots.txt эти две строчки:

Disallow: /*start Disallow: /*searchword

Disallow: /*start Disallow: /*searchword |

Немного о нестандартном использовании robots.txt

С учетом написанного выше, тему правильной настройки robots.txt можно считать раскрытой, однако есть еще кое-что, о чем я бы хотел рассказать. Роботс можно с пользой применять помимо назначения и без вреда для сайта. Дело в том, что в файле можно использовать такой знак, как «#» — он обозначает комментарии, не учитываемые роботами. Данный знак действителен в пределах одной строки, там, где он используется. Его можно использовать для пометок, чтобы не забыть, что и зачем было закрыто от поисковых систем.

Но есть и другое применение. Например, после знака комментария, вы можете разместить полезную информацию: контакты сайта, вакансию для оптимизатора, ссылку на важную информацию, и даже рекламу. Не буду заниматься плагиатом, так как идея не моя, поэтому предлагаю ознакомиться с различными вариантами на блоге Devaka. Уверен, вы будете удивлены, узнав, насколько разнообразным может быть использование роботса не по назначению.

На этом все, правильная настройка robots.txt описана в полной мере, надеюсь, вы узнали что-то новое. Если же после прочтения статьи у вас остались вопросы — задавайте их в комментариях, и я постараюсь на них ответить.

sky-fi.info

Правильный robots.txt для сайта – настройка и проверка

Пришел час, когда нужно поговорить о настройке robots.txt для сайта. Файл должен находиться в корневой папке и открываться по адресу имя_сайта/robots.txt. При работе над оптимизацией сайтов часто приходится вносить правки в содержимое.

Можно выделить 3 причины, по которым поднимаю, казалось бы, избитую тему:

- Изменения в поисковых системах, касающиеся файла роботс.

- Генерирующееся автоматически содержимое robots.txt на некоторых CMS, когда без разбору закрываются папки и служебные, динамические страницы.

- Копирование новичками стандартного содержимого из ставших неактуальными статей в Интернете.

В чем изменилась настройка robots.txt для Яндекса

- Боты Яндекса перестали учитывать директиву host. Анонсировалась новость весной 2018 года. От хоста можно смело очистить строчку, даже если сайт недавно переведен на безопасный протокол. Яндекс склеивает зеркала при наличии 301 редиректа с http на https.

- Crawl-delay тоже в Яндексе больше не работает. Если возникла необходимость настроить скорость сканирования яндекс ботами, это делается в вебмастере Яндекса. Точно так же временные ограничения задаются в поисковой консоли Гугла. Бывает, что поисковые роботы проявляют повышенный интерес к сайту и создают большую нагрузку. Выяснить, кто именно повинен в повышении нагрузки, можно только изучив лог-файлы. И ограничения стоит выставлять в разумных пределах. Естественно, данные должны собираться на хостинге. На Бегете, например, есть вкладка «Журналы». По умолчанию они выключены.

Заблокированные ресурсы в robots.txt

Уже даже не помню, как давно Гугл захотел, чтобы гуглеботу на сайте для сканирования было доступно все, что видит пользователь, во всей красе – со стилями, скриптами, элементами оформления дизайна. Поэтому, закрывая определенную папку в Disallow, следует задуматься, не блокируются ли файлы css, js png, находящиеся в этой папке. Если по каким-то соображениям решили закрыть к папке доступ, то стоит дополнить роботс директивами Allow с указанием расширений файлов, например: Allow: /*.css.

То же, вероятнее всего, придется сделать, если установлен запрет на URLs, содержащие знак вопроса. Вопросительный знак присутствует в адресе динамической страницы или результата поиска, что само по себе равно. Но «?» может быть и в ссылке на css.

Проверка robots.txt

Лучше всего с этим поможет поисковая консоль Гугла, и в ней разделы

- “Индекс Google — Заблокированные ресурсы”

- “Сканирование – Инструмент проверки файла robots.txt”.

Информация по вновь добавленным в консоль сайтам собирается примерно две недели. Если в заблокированных ресурсах видите сторонний домен, с которого на сайт выводятся какие-то элементы, здесь что-то предпринять не удастся – запрет установлен не нами. Можно игнорировать эти замечания.

Информация по вновь добавленным в консоль сайтам собирается примерно две недели. Если в заблокированных ресурсах видите сторонний домен, с которого на сайт выводятся какие-то элементы, здесь что-то предпринять не удастся – запрет установлен не нами. Можно игнорировать эти замечания.

Файл robots.txt для WordPress

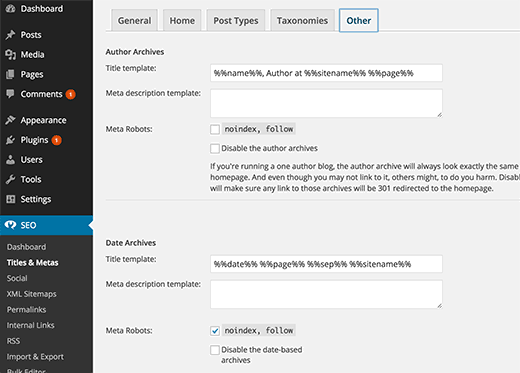

Все, что написано выше, можно применить при создании роботс на любом движке. Главное – следовать логике. Содержание файла robots.txt представлено для коммерческих сайтов на Вордпресс, без интернет-магазина. В ИМ обычно ставят запрет на корзину, страницу оформления заказа, оплаты и другие служебные страницы, участвующие в работе магазина. Шаблон robots.txt для WordPress с использующимся плагином Yoast Seo, в котором включена переадресация со страниц вложения медиафайлов на адрес изображения. Если страницы attachment открываются, на них тоже ставят запрет в robots.txt.

Делить ботов по поисковым системам, на мой взгляд, теперь не требуется.

User-agent: * Disallow: /wp-admin/ Disallow: /xmlrpc.php Disallow: /wp-json/ Disallow: /*?pcf=* Disallow: /?* Allow: /wp-admin/admin-ajax.php Allow: /*.css Allow: /*.jsSitemap: протокол://домен/sitemap.xml

Директивы в файле robots.txt носят, как правило, рекомендательный характер для сканирования (не индексирования) ботами. Какой контент будет участвовать в поисковой выдаче, поисковые системы прекрасно разберутся и самостоятельно. Поэтому с запретами нужно быть аккуратными и, конечно, ни в коем случае не запрещать доступ к удаленным страницам, отдающим код 404.

nadezhdakhachaturova.ru

Плагин wordpress robots.txt установка и настройка — WDfiles — Блог файлообменника

Здравствуйте !

Сегодня я покажу вам и расскажу как пользоваться файлом robots.txt. Что это такое ? файл robots.txt позволит вам скрывать от индексации некоторые разделы или отдельные страницы вашего сайта, чтобы они не попадали в поиск Google и Yandex. Для чего это нужно ? поисковые системы индексируют всё содержимое вашего сайта без разбора, поэтому если вы хотите скрыть какую-либо конфиденциальную информацию,

например личные данные ваших пользователей, переписка, счета и т.д., то вам нужно будет самостоятельно добавить адреса страниц с данными в файл robots.txt. Что ещё можно сделать с помощью файла robots.txt ? если у вашего сайта есть зеркала, то в их файлах robots.txt можно указать на главный сайт, чтобы индексировался только он.

Видео о файле robots.txt

Настраивать файл robots.txt мы будем с помощью плагина — DL Robots.txt. Установить данный плагин вы сможете прямо из своей админ-панели wordpress. Перейдите по вкладке: Плагины — Добавить новый, введите название плагина в форму поиска, нажмите Enter, установите и активируйте открывшийся плагин.

Чтобы попасть на страницу настроек плагина, перейдите по вкладке: DL Robots.txt. Данная вкладка появится у вас в меню админ-панели wordpress, после того как вы установите и активируете плагин.

На странице настройки файла robots.txt, вы можете прочитать и посмотреть видео о том, что такое файл robots.txt. Так же здесь можно проверить файл, нажав на вкладку — Robots.txt, если файл откроется в браузере значит всё нормально.

Если на вашем сайте нет файла robots.txt, значит сейчас мы добавим его в специальное окно, которое находится на странице настроек плагина. Итак, конечно же создавать файл robots.txt необходимо исходя из предпочтений каждого отдельного сайта, но я вам предложу готовый вид файла, который подойдёт любому сайту на wordpress. В случае чего вы сможете с лёгкостью добавить в файл свои дополнения.

Вот как выглядит файл robots.txt для моего сайта.

Сейчас я объясню вам, что всё это значит.

В общем, если не вдаваться в подробности, то я запретил поисковикам индексировать: темы и плагины wordpress, кэш сайта, то есть дубликаты страниц, feed — это rss лента с записями. Теперь объясню зачем это делать, этим самым мы облегчаем работу поискового робота, чтобы он не индексировал лишний груз сайта, темы, плагины, кэш, фид, всё это можно не индексировать, в поиске вся эта информация просто не нужна.

Так же в файле указано — разрешить поисковикам индексировать все загруженные медиафайлы на вашем сайте. Такой файл robots.txt подойдёт любому сайту на wordpress.

Смотрите, к примеру вы хотите не индексировать ещё какую-либо отдельную страницу или запись на вашем сайте, тогда файл будет выглядеть следующим образом:

Поняли да, то есть добавляете только название страницы из её ссылки и впереди ставите флэш /, а для записи, название записи.html и впереди флэш /.

Итак, скачать готовый файл robots.txt можно — Здесь ! Только Внимание ! ! ! укажите свой адрес сайта вместо моего.

После того как вы скачаете файл, у вас будет два варианта:

- Загрузить файл в свою корневую директорию на хостинге. (в этом случае плагин можно не устанавливать)

- Скопировать содержание файла и вставить в специальное окно на странице настройки плагина DL Robots.txt

На этом у меня всё, если у вас остались вопросы по данной статье, то обязательно напишите мне в Обратную связь, либо оставьте комментарий к данной записи. Я всем отвечу ! Кстати, а вы проверяли файл robots.txt в Яндекс вебмастер ?

Удачи вам и до новых встреч !

wdfiles.ru

Настройка robots для WordPress | Workion.ru

Некоторые новички, которые создают сайты на WordPress, уверены, что после установки движка можно приступать к наполнению сайта. На самом деле, существует масса тонкостей, о которых необходимо задуматься ещё до того, как поисковые роботы начнут индексировать сайт.

Файл robots.txt содержит в себе данные, которые помогают ограничить поисковых роботов от лишней информации на сайте, его присутствие и настройка является обязательным действием.Файл robots.txt для WordPress устанавливается по умолчанию, поэтому вам остается лишь заняться его настройкой.

Настройка robots для WordPress

В robots.txt, который устанавливается по умолчанию, уже присутствуют некоторые данные например, строка User-agent. Данная строчка позволяет указать, для какого поискового робота вы устанавливаете настройки. Символ * обозначает, что настройки общие для роботов всех поисковых систем.

При необходимости, вы можете прописать в строке User-agent название одного из роботов поисковиков и тем самым установить индивидуальные параметры. Вот названия поисковых роботов:

В каждой из поисковых систем есть ещё и отдельные роботы, которые отвечают за определенный контент. В сети вы сможете найти названия каждого из них, но используются они довольно редко. Для примера представим несколько роботов Яндекса:

Следующие важные части файла robots.txt – это директивы Disallow, Host и Satemap.

Вы можете посмотреть файл Robots любого сайта, используя ссылку следующего вида workion.ru/robots.txt.Disallow – благодаря этому значению, вы можете скрывать от поисковых роботов часть информации сайта. По умолчанию в вашем robots.txt уже должны быть закрыты от индексации следующие директории:

Disallow: /wp-admin/Disallow: /wp-includes/Disallow: /wp-trackbackDisallow: /wp-feedDisallow: /wp-commentsDisallow: /wp-content/pluginsDisallow: /wp-content/themesDisallow: /wp-login.phpDisallow: /wp-register.php

Это не весь список закрытых директорий, в котором находятся различные страницы плагинов, КЭШа, административной панели и прочих директорий.

Что лучше закрывать от поисковых роботов?

Это может быть не уникальный контент или дубли страниц. Как показывает практика, при использовании CMS у многих появляется проблема с дублями, которые проще всего скрыть.

Host – следующая функция позволяет указать главный адрес сайта. Даже если у вашего сайта один домен, он имеет 2 значения, например, www.workion.ru и просто workion.ru. При покупке ссылок, вы должны использовать один из видов адреса вашего сайта, а в файле robots.txt, укажите какой из них главный.

Satemap – эта строчка предназначена для указания пути к карте сайта. Создать карту сайта на WordPress не сложно, для этого есть специальные плагины. Нужна она для того, чтобы поисковики могли быстро находить новые материалы для индексации.

Вопросы по настройке Robots.txt

Мои постоянные читатели буквально засыпают разными вопросами, связанными с данным файлом. Чтобы не писать много раз одно и тоже, я решил составить подборку популярных вопросов и ответить на них:

- Как запретить индексацию страницы?

Чтобы запретить индексацию отдельной страницы, используйте функцию Disallow, вот пример:

Disallow: http://www.домен.ru/shop/22

- Как запретить индексацию сайта?

Здесь также пригодится Disallow, ссылку ставьте на корень сайта (можно устанавливать для определенных поисковых систем, используя User-agent):

Disallow: /

- Как указать Sitemap?

Чтобы поисковые системы правильно находили карту сайта, используйте функцию Sitemap:

Sitemap: http://sait/sitemap.xml

- Как запретить битые ссылки?

При работе разных плагинов, могут появиться битые ссылки. Чтобы не запрещать полностью компоненты, определяйте их и поочередно добавляйте в код Robots:

Disallow: /index.php?option=com_jreviews&Itemid=91

- Как запретить индексацию поддомена?

Чтобы закрыть поддомен, необходимо в корне дополнительного сайта создать Robots.txt и там прописать такой же код, как во втором вопросе (полный запрет от индексации сайта).

Вот несколько простых решений сложных вопросов. Новички часто этим интересуются, поэтому информация должна быть полезной.

Правильный Robots для WordPress, как настроить?

Для каждого сайта необходимо создавать индивидуальный файл robots.txt, для блога Workion.ru он выглядит так:

User-agent: *Disallow: /wp-adminDisallow: /wp-includesDisallow: /wp-content/pluginsDisallow: /wp-content/cacheDisallow: /wp-content/themesDisallow: /trackbackDisallow: */trackbackDisallow: */*/trackbackDisallow: */*/feed/*/Disallow: */feedDisallow: /*?*Disallow: /tag

User-agent: YandexDisallow: /wp-adminDisallow: /wp-includesDisallow: /wp-content/pluginsDisallow: /wp-content/cacheDisallow: /wp-content/themesDisallow: /trackbackDisallow: */trackbackDisallow: */*/trackbackDisallow: */*/feed/*/Disallow: */feedDisallow: /*?*Disallow: /tagHost: ваш_сайт.ru

Sitemap: http://ваш_сайт.ru /sitemap.xml.gzSitemap: http://ваш_сайт.ru /sitemap.xml

Если уже создали сайт на CMS WordPress и вы никогда не обращали внимания на файл robots.txt, настоятельно рекомендуем вам это сделать. Чтобы даже у новичков не возникало проблем при настройке этого важного файла, давайте разберемся, для чего прописаны все эти строчки:

User-agent: - указывает на то, что указанные правила будут учитываться всеми поисковыми системами. Если требуется задать правила для определенного поисковика, прописывается формат User-agent: Yandex.

Allow – обратная функция Disallow, она разрешает индексацию (для WordPress можно не использовать).

Звездочка * - указывает на произвольную установку символов.

Остальные функции уже описаны в данной статье. В принципе, разбираться в этом не обязательно, ведь вы можете взять готовый вариант чуть выше.

На официальном сайте Яндекса есть подробное описание всех важных моментов по настройке robots.txt (читайте здесь).После настройки разных параметров и установке выше указанного кода, появились проблемы. Оказалось, что на сайте не настроено ЧПУ (что такое URL и ЧПУ). Если и на вашем ресурсе не настроены человекопонятные адреса, используйте следующий код в Robots.txt:

User-agent: *Disallow: /cgi-binDisallow: /wp-adminDisallow: /wp-includesDisallow: /wp-content/pluginsDisallow: /wp-content/cacheDisallow: /wp-content/themesDisallow: /trackbackDisallow: */trackbackDisallow: */*/trackbackDisallow: */*/feed/*/Disallow: */feedDisallow: /tagUser-agent: YandexDisallow: /cgi-binDisallow: /wp-adminDisallow: /wp-includesDisallow: /wp-content/pluginsDisallow: /wp-content/cacheDisallow: /wp-content/themesDisallow: /trackbackDisallow: */trackbackDisallow: */*/trackbackDisallow: */*/feed/*/Disallow: */feedDisallow: /tagHost: ваш_сайт.ruSitemap: http://ваш_сайт/sitemap.xml.gzSitemap: http://ваш_сайт/sitemap.xml

Каждый раз, после внесения изменений в данном файле, проводите его проверку. Для этого у поисковых систем есть специальные инструменты (проверка Robots у Яндекса).

Если не хотите вручную настраивать данный файл, можно использовать плагин для настройки Robots.txt All in One SEO Pack.Поисковые боты не могут самостоятельно определить, в какие директории вашего сайта заходить и что именно индексировать.

Им нужно помогать с этим, а настройка Robots.txt реально помогает это сделать. Сделайте так, чтобы данный файл был идеальным для вашего ресурса, это один из важных моментов оптимизации.

Вам также будет интересно:- Как получать естественные ссылки?- Бесплатный конструктор сайтов Fo- Негативное влияние прогонов по каталогам

workion.ru

Как настроить Robots.txt для WordPress

robots.txt — это текстовый файл, который используется для того, чтобы запретить роботам (в частности ботам поисковых систем) индексацию и «обход» определенных частей вашего сайта. Без этого файла боты смогут свободно гулять по вашему сайту, что не очень то и хорошо.

По-умолчанию WordPress не создает файл robots.txt, поэтому его необходимо создать самостоятельно и настроить тоже самому.

Общий смысл запрета доступа к определенным частям вашего сайта в том, чтобы сфокусировать внимание роботов на важном контенте.

Что произойдет, если у вас не будет файла robots.txt?

Вкратце, будет индексироваться все подряд.

Для WordPress это означает следующее:

- /cgi-bin

- /wp-admin

- /wp-includes

- /wp-content/themes

- /wp-content/plugins/

Как вы уже, наверное, догадались, ничего из вышеперечисленного не является релевантным контентом для SEO и может даже навредить вашему сайту. Google разрешает только определенное количество «ссылочного мусора», поэтому имеет смысл сконцентрировать усилия на контенте и страницах.

Как можно контролировать индексацию своего сайта?

Решение очень простое.

Создайте текстовый файл, используя ваш любимый текстовый редактор, или же, если на хостинге у вас установлена Cpanel, то создайте новый файл в файловом менеджере и назовите его robots.txt.

Скопируйте и вставьте в него следующее:

User-agent: * Disallow: /cgi-bin Disallow: /wp-admin Disallow: /wp-includes Disallow: /wp-content/themes Disallow: /wp-content/plugins/ Allow: /wp-content/uploads Allow: /feed*Сохраните файл. Если же вы создали его вне сервера, то просто загрузите в корневую директорию сайта. Это та же директория, где расположены папки wp-admin, wp-includes и wp-content.

Вот и все. Теперь вы заметите, что некоторые ссылки сайта станут выпадать из поиска в течение нескольких дней или даже недель.

Если вы захотите добавить другие файлы, просто добавьте правило вроде этого:

Allow: /путь_к/папкеОбратите внимание, что мы пропускаем домен сайта, а добавляем путь к папке начиная с прямого слеша (/).

За несколько лет работы с WordPress мы собрали для себя оптимальный «набор» правил для robots.txt. Ниже приводим его содержание. Его можно взять за основу, однако стоит разобраться что именно вы закроете от индексации. Некоторые вебмастера предпочитают закрывать рубрики и теги, другие же — наоборот, оставляют открытыми для ботов.

# All User-agent: * Disallow: /wp-login.php Disallow: /wp-register.php Disallow: /xmlrpc.php Disallow: /template.html Disallow: /cgi-bin Disallow: /wp-admin Disallow: /wp-includes Disallow: /wp-content/plugins Disallow: /wp-content/cache Disallow: /wp-content/themes Disallow: /page* Disallow: /page Disallow: /author/* Disallow: /20* Disallow: /feed Disallow: /*/feed Disallow: */comme Disallow: */feednt-page-* Disallow: */trackback Disallow: /trackback Disallow: /*?* Disallow: /*? Disallow: /*.php$ Disallow: /*.js$ Disallow: /*.inc$ Disallow: /*.css$ Disallow: /search/*/feed Disallow: /search/*/* Disallow: /tag/ Disallow: */*?replytocom* Disallow: */*/feed/*/ Disallow: */feed Allow: /wp-content/uploads/ Sitemap: http://site.ru/sitemap.xml Sitemap: http://site.ru/sitemap.xml.gz # Google Image User-agent: Googlebot-Image Disallow: Allow: /* # Google AdSense User-agent: Mediapartners-Google* Disallow: Allow: /* # Yandex User-agent: Yandex Host: site.ru Disallow: /wp-login.php Disallow: /wp-register.php Disallow: /xmlrpc.php Disallow: /template.html Disallow: /cgi-bin Disallow: /page* Disallow: /page Disallow: /wp-admin Disallow: /wp-includes Disallow: /wp-content/plugins Disallow: /wp-content/cache Disallow: /wp-content/themes Disallow: /20* Disallow: /feed Disallow: /author/* Disallow: */comme Disallow: */feednt-page-* Disallow: */trackback Disallow: /trackback Disallow: /*?* Disallow: /*? Disallow: /*.php$ Disallow: /*.js$ Disallow: /*.inc$ Disallow: /*.css$ Disallow: /search/*/feed Disallow: /search/*/* Disallow: /tag/ Disallow: */*?replytocom* Disallow: */*/feed/*/ Disallow: */feed Allow: /wp-content/uploads/ Sitemap: http://site.ru/sitemap.xml Sitemap: http://site.ru/sitemap.xml.gz # YandexBlog User-agent: YandexBlog Disallow: Allow: /*VN:F [1.9.22_1171]

Rating: 5.0/5 (3 votes cast)

wpincode.com

Файл robots (роботс) txt - правильный robots для блога Wordpress, настройка и оптимизация для Seo

Вы хотите оптимизировать файл robots txt для WordPress? Или вы пока еще не знаете, насколько полезен и важен данный файл для SEO? Я помогу вам разобраться в этом вопросе.

В этой статье я не только расскажу, что такое настройка robots, но и покажу, как оптимизировать его для SEO, а также объясню, почему это так важно сделать.

В последнее время я все чаще получаю вопросы, связанные с файлом роботс – зачем он нужен и в чем его важность. Данный файл оказывает большое влияние на продвижение всего сайта; он как бы настраивает связь между вами и поисковыми системами, сообщая им какие именно части сайта они должны проиндексировать.

Так ли нужен файл Robots.txt?

Его отсутствие, конечно, не остановит поисковых ботов лазить и индексировать страницы вашего сайта. Тем не менее, я настоятельно рекомендую создать этот файл. Все дело в том, что файл robots помогает роботам узнать о существовании на вашем сайте файла XML sitemap, который является своеобразным путеводителем по сайту, указывающим ботам какие именно материалы нуждаются в первоочередной индексации. В противном случае вам придется прописывать ссылку на адрес карты сайта через Google Webmaster Tools. Впрочем, вы можете использовать два этих способа одновременно.

Но я все же настоятельно рекомендую создать на своем сайте правильный robots txt для WordPress.

Где находится файл роботс? Как его создать?

Обычно он располагается в корневой папке сайта. Для его просмотра необходимо установить соединение с FTP-сервером (через Total Commander), либо воспользоваться файловым менеджером cPanel.

Он как и любой другой текстовый файл можно открыть в документе Блокнот.

Если в корневой папке вашего сайта нет этого файла, то вы всегда можете его создать. Для этого всего лишь нужно создать новый текстовый файл и сохранить его как robots.txt, а затем загрузить его в корневую папку сайта.

Как его использовать

На самом деле формат файла robots.txt file предельно прост. Первая его строка – это, как правило, имя пользовательского агента. В качестве пользовательского агента выступает название поискового бота, который вы хотите привлечь на свой сайт. Например, это может быть Googlebot или Bingbot. Впрочем, вы можете здесь прописать «*», если хотите привлечь всех ботов.

Следующая строка должна содержать пометку «Allow» (разрешить) или «Disallow» (запретить), т.е. вы сообщаете поисковым системам, какие файлы, папки, разделы сайта и т.п. они должны индексироваться, а какие нет.

Вот пример:

User-Agent: * Allow: /wp-content/uploads/ Disallow: /wp-content/plugins/ Disallow: /readme.html

User-Agent: * Allow: /wp-content/uploads/ Disallow: /wp-content/plugins/ Disallow: /readme.html |

Из данного примера видно, что мы сообщаем всем поисковым ботам индексировать директорию, в которой хранятся все загруженные нами изображения сайта.

Следующие две строки файла запрещают поисковым ботам индексировать категорию плагинов WordPress и файл readme.html.

Оптимизация файла Robots.txt для SEO

Руководство от Google для веб-мастеров советует не использовать файл robots.txt в случае если вы хотите скрыть от ботов контент низкого качества. Так что если вы собирались воспользоваться этим файлом для скрытия каких-либо категорий, данных и архивных страничек, то это далеко не самое мудрое решение.

Помните, цель robots.txt – это дать инструкции ботам, что делать с контентом, по которым они лазают, но никак не препятствовать их лазанью по вашему сайту.

У Вордпресса есть плагины, которые позволяют добавлять мета-теги «nofollow» и «noindex» к архивным страничкам, а также для этих целей существует SEO плагин.

Я не то чтобы рекомендую этим заниматься, но если вы решили не индексировать архивные страницы, то вышеописанные способы являются лучшим решением.

Вам не нужно добавлять страницу админки WordPress, каталог администратора или регистрационный страницу в файл robots.txt, т.к. у этих страниц тег «noindex» помечен WP в качестве мета-тега.

Добавление XML Sitemap в файл Robots

Если вы используете вордпрессовский SEO плагин Yoast или какой-либо другой плагин для создания файла XML sitemap, то он постарается автоматически добавить в роботс строки, связанные с картой сайта.

Однако если у него по каким-либо причинам не получится это сделать, то он покажет вам ссылку на XML Sitemap, которую необходимо будет вручную добавить в файл robots. Выглядеть это будет примерно так:

Sitemap: http://www.example.com/post-sitemap.xml Sitemap: http://www.example.com/page-sitemap.xml

Sitemap: http://www.example.com/post-sitemap.xml Sitemap: http://www.example.com/page-sitemap.xml |

Как выглядит идеально составленный файл Robots.txt?

Честно говоря, у многих популярных блогов он выглядит предельно просто. Конечно, содержание варьируется в зависимости от нужд конкретного сайта, но картинка примерно такая:

User-agent: * Disallow: Sitemap: http://www.example.com/post-sitemap.xml Sitemap: http://www.example.com/page-sitemap.xml

User-agent: * Disallow:

Sitemap: http://www.example.com/post-sitemap.xml Sitemap: http://www.example.com/page-sitemap.xml |

Расшифровка этого файла следующая: всем поисковым ботом сообщается индексировать весь контент, и предоставляются ссылки на XML sitemaps сайта.

Вот еще один пример файла robots.txt, использующегося на сайте WPBeginner:

User-Agent: * Allow: /?display=wide Allow: /wp-content/uploads/ Disallow: /wp-content/plugins/ Disallow: /readme.html Disallow: /refer/ Sitemap: http://www.wpbeginner.com/post-sitemap.xml Sitemap: http://www.wpbeginner.com/page-sitemap.xml Sitemap: http://www.wpbeginner.com/deals-sitemap.xml Sitemap: http://www.wpbeginner.com/hosting-sitemap.xml

User-Agent: * Allow: /?display=wide Allow: /wp-content/uploads/ Disallow: /wp-content/plugins/ Disallow: /readme.html Disallow: /refer/

Sitemap: http://www.wpbeginner.com/post-sitemap.xml Sitemap: http://www.wpbeginner.com/page-sitemap.xml Sitemap: http://www.wpbeginner.com/deals-sitemap.xml Sitemap: http://www.wpbeginner.com/hosting-sitemap.xml |

А вот еще один правильный вариант файла на моем блоге. По крайней мере, ошибок не обнаружено, лишних мусорных страниц в индексе нет, все прекрасно живет в ТОП 10 🙂

User-agent: * Disallow: /wp-admin Disallow: /wp-includes Disallow: /feed/ Disallow: */feed Disallow: */trackback Disallow: */comments Disallow: /*? Disallow: /*?* Disallow: /tag Disallow: /wp-content/plugins Disallow: /wp-content/cache Disallow: /wp-content/themes Disallow: /xmlrpc.php Host: smarticle.ru Sitemap: http://smarticle.ru/sitemap.xml User-agent: Googlebot-Image Allow: /wp-content/uploads/ User-agent: YandexImages Allow: /wp-content/uploads/ Disallow: /CE20257AD2088B189632FDA110A16EB2.html

|

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 |

User-agent: * Disallow: /wp-admin Disallow: /wp-includes Disallow: /feed/ Disallow: */feed Disallow: */trackback Disallow: */comments Disallow: /*? Disallow: /*?* Disallow: /tag Disallow: /wp-content/plugins Disallow: /wp-content/cache Disallow: /wp-content/themes Disallow: /xmlrpc.php Host: smarticle.ru Sitemap: http://smarticle.ru/sitemap.xml User-agent: Googlebot-Image Allow: /wp-content/uploads/ User-agent: YandexImages Allow: /wp-content/uploads/ Disallow: /CE20257AD2088B189632FDA110A16EB2.html |

Вот и все. Надеюсь, что данная статья была вам полезна, и вы теперь знаете, что такое настройка robots и его оптимизация для SEO.

Если вам понравилась статья, то не забывайте ею делиться, ставить лайки, а также подписывайтесь на мой блог и канал в YouTube. Вы также можете найти меня вконтакте и заглядывайте в группу «Прибыльный e-mail маркетинг 2.0».

smarticle.ru

Супер файл robots txt для сайта wordpress — ТОП

![]() Всем привет ! Наконец-то «дошли мои руки»

Всем привет ! Наконец-то «дошли мои руки» ![]() до файла robots txt, давно я уже хотел снова написать статью о данном файле, который не даёт ни кому покоя. Есть у меня на сайте уже пару статей о файле роботе, но их можно не читать, так как время тикает и всё меняется. Я пришёл к новым ума-заключениям, более осмысленным, наконец-то сам разобрался что к чему, а то знаете копировать робота с других сайтов и тупо вставлять на свой сайт…не дело это.

до файла robots txt, давно я уже хотел снова написать статью о данном файле, который не даёт ни кому покоя. Есть у меня на сайте уже пару статей о файле роботе, но их можно не читать, так как время тикает и всё меняется. Я пришёл к новым ума-заключениям, более осмысленным, наконец-то сам разобрался что к чему, а то знаете копировать робота с других сайтов и тупо вставлять на свой сайт…не дело это.

![]() Сайты то у всех разные и если вы думаете, что есть один универсальный файл robots txt для всех сайтов, то вы ошибаетесь. Сегодня я дам вам практически самый универсальный файл робот, но вам нужно будет ещё кое-что проработать, я покажу что. Файл робота нужно составлять не только под каждый сайт индивидуально, но и под каждую поисковую систему (Яндекс, Google) тоже индивидуально.

Сайты то у всех разные и если вы думаете, что есть один универсальный файл robots txt для всех сайтов, то вы ошибаетесь. Сегодня я дам вам практически самый универсальный файл робот, но вам нужно будет ещё кое-что проработать, я покажу что. Файл робота нужно составлять не только под каждый сайт индивидуально, но и под каждую поисковую систему (Яндекс, Google) тоже индивидуально.

![]() Благодаря моим наблюдениям я вычислил, что для Google вообще не надо ничего закрывать, за исключением wp-admin. Речь идёт о: wp-content и wp-includes, в данных разделах находятся плагины, темы, скрипты, стили, CSS, JS. Если вы закроете от гугл разделы wp-content и wp-includes, то гугл заблокирует все записи сайта, в которых указаны ссылки на данные разделы.

Благодаря моим наблюдениям я вычислил, что для Google вообще не надо ничего закрывать, за исключением wp-admin. Речь идёт о: wp-content и wp-includes, в данных разделах находятся плагины, темы, скрипты, стили, CSS, JS. Если вы закроете от гугл разделы wp-content и wp-includes, то гугл заблокирует все записи сайта, в которых указаны ссылки на данные разделы.

![]() Откройте любую запись вашего сайта, с помощью правой кнопки мыши перейдите в исходный код страницы. Практически на всех сайтах wordpress, в исходном коде любой записи отображаются ссылки на разделы wp-content и wp-includes. CSS и JS файлы нужны для отображения стилей и скриптов. Дело в том, что в отличии от Яндекса, Гугл не любит когда от него скрывают CSS и JS файлы. Для полноценной индексации записи, для гугла должны быть открыты файлы wp-content и wp-includes.

Откройте любую запись вашего сайта, с помощью правой кнопки мыши перейдите в исходный код страницы. Практически на всех сайтах wordpress, в исходном коде любой записи отображаются ссылки на разделы wp-content и wp-includes. CSS и JS файлы нужны для отображения стилей и скриптов. Дело в том, что в отличии от Яндекса, Гугл не любит когда от него скрывают CSS и JS файлы. Для полноценной индексации записи, для гугла должны быть открыты файлы wp-content и wp-includes.

![]() Могут быть и другие файлы, отдельные скрипты или стили, которые находятся в отдельных папках, не входящих в основные разделы wp-content и wp-includes. Здесь очень парадоксальный момент, то что для гугла надо открыть в файле робота, то для Яндекс надо закрыть в файле робота, чтобы он не наплодил дублей. Вообще, что касается Google, то файл robots txt не предназначен для закрытия индексации.

Могут быть и другие файлы, отдельные скрипты или стили, которые находятся в отдельных папках, не входящих в основные разделы wp-content и wp-includes. Здесь очень парадоксальный момент, то что для гугла надо открыть в файле робота, то для Яндекс надо закрыть в файле робота, чтобы он не наплодил дублей. Вообще, что касается Google, то файл robots txt не предназначен для закрытия индексации.

![]() Вы можете закрыть (Disallow) какие-то файлы, чтобы поисковый робот гугл не сканировал их, к примеру для снижения нагрузки на сервер, но скрыты от индексации они не будут. К примеру, ссылка на ваш сайт может отображаться на другом сайте и тогда гугл проиндексирует её, не смотря на запреты в файле robots. Чтобы гугл не индексировал ваш сайт или какую-то его часть, раздел, страницу и т.д., то вам нужно использовать специальные мета теги, либо добавлять их на сайт вручную, либо с помощью плагина.

Вы можете закрыть (Disallow) какие-то файлы, чтобы поисковый робот гугл не сканировал их, к примеру для снижения нагрузки на сервер, но скрыты от индексации они не будут. К примеру, ссылка на ваш сайт может отображаться на другом сайте и тогда гугл проиндексирует её, не смотря на запреты в файле robots. Чтобы гугл не индексировал ваш сайт или какую-то его часть, раздел, страницу и т.д., то вам нужно использовать специальные мета теги, либо добавлять их на сайт вручную, либо с помощью плагина.

User-agent: YandexDisallow: /wp-admin/Disallow: /wp-content/Disallow: /wp-includes/Disallow: /wp-json/Disallow: /page/Disallow: /wp-login.phpDisallow: /simpleboxDisallow: /?wp-subscription-managerHost: info-effect.ruSitemap: http://info-effect.ru/sitemap.xml

User-agent: *Disallow: /wp-admin/

![]() Как видите по моему файлу, для Яндекса нужно закрыть все основные раздела wordpress сайта, в том числе wp-json и wp-login. А далее вам уже нужно лезть в исходный код своего сайта и вычислять какие ссылки ещё необходимо закрыть от Яндекса. Делается это очень просто, открываете любую запись своего сайта, переходите в исходный код, находите все ссылки (href) и закрываете все ссылки в файле robots, которые отображаются в каждой записи (в исходном коде).

Как видите по моему файлу, для Яндекса нужно закрыть все основные раздела wordpress сайта, в том числе wp-json и wp-login. А далее вам уже нужно лезть в исходный код своего сайта и вычислять какие ссылки ещё необходимо закрыть от Яндекса. Делается это очень просто, открываете любую запись своего сайта, переходите в исходный код, находите все ссылки (href) и закрываете все ссылки в файле robots, которые отображаются в каждой записи (в исходном коде).

![]() К примеру у меня есть скрипт simplebox, для открытия изображений, в каждой записи есть ссылка на данный скрипт (в исходном коде). «Все ссылки» это не все ссылки сайта, это ссылки которые не нужны для индексации, которым нет смысла находится в поиске, пример — http://info-effect.ru/wp-json/oembed/1.0/embed?url=http%3A%2F%2Finfo-effect.ru%2Fkak-sdelat-izobrazhenie-adaptivnym-masshtabiruemym-chtoby-rastyagivalos.html

К примеру у меня есть скрипт simplebox, для открытия изображений, в каждой записи есть ссылка на данный скрипт (в исходном коде). «Все ссылки» это не все ссылки сайта, это ссылки которые не нужны для индексации, которым нет смысла находится в поиске, пример — http://info-effect.ru/wp-json/oembed/1.0/embed?url=http%3A%2F%2Finfo-effect.ru%2Fkak-sdelat-izobrazhenie-adaptivnym-masshtabiruemym-chtoby-rastyagivalos.html

![]() Повторюсь, для гугла нет смысла что-то скрывать в файле robots, за исключением wp-admin, чтобы гугл не сканировал административную часть сайта. А чтобы гугл не добавлял в поиск определённые страницы и разделы, нужно добавлять на сайт специальные мета теги и плагины. Что касается дублей, то у гугла в кабинете вебмастера есть специальный инструмент — «Параметры URL», который автоматически определяет что к чему.

Повторюсь, для гугла нет смысла что-то скрывать в файле robots, за исключением wp-admin, чтобы гугл не сканировал административную часть сайта. А чтобы гугл не добавлял в поиск определённые страницы и разделы, нужно добавлять на сайт специальные мета теги и плагины. Что касается дублей, то у гугла в кабинете вебмастера есть специальный инструмент — «Параметры URL», который автоматически определяет что к чему.

![]() На данный момент, такой вариант файла robots меня полностью устраивает и самое главное он устраивает поисковые системы Яндекс и Google. Индексация наладилась, всё в норме, в поиск попадают только необходимые страницы и записи, ничего лишнего. Совет вам вот какой — обязательно настройте правильно файл robots txt и следите за индексацией сайта, причём на постоянной основе. Успехов вам !

На данный момент, такой вариант файла robots меня полностью устраивает и самое главное он устраивает поисковые системы Яндекс и Google. Индексация наладилась, всё в норме, в поиск попадают только необходимые страницы и записи, ничего лишнего. Совет вам вот какой — обязательно настройте правильно файл robots txt и следите за индексацией сайта, причём на постоянной основе. Успехов вам !

info-effect.ru