Правильный файл robots.txt WordPress для Яндекса и Google. Robot txt для wordpress

Создаём идеальный Robots.txt для WordPress

Содержание статьи:

- Robots.txt – что это такое?

- Зачем он нужен?

- Где находится?

- Robots txt для WordPress

- Пример Robots.txt: disallow и allow, host и sitemap

- Disallow

- Allow

- Прописываем Host и карту сайта

- Проверка Robots.txt Яндексом и Google

Здравствуйте! После того как мы разобрались с правильной структурой сайта настало время поговорить о robots.txt, что это такое и с чем его едят. Кроме того, из данной статьи вы узнаете, каков он, идеально правильный robots.txt для WordPress, как с его помощью запретить индексацию сайта или разрешить всё.

Robots.txt – что это такое?

Файл robots.txt — это файл, с помощью которого можно выставить запрет на индексацию каких-либо частей сайта или блога поисковым роботом.

Создается единый стандартный robots txt для Яндекса и для Google, просто вначале прописываются запреты для одной поисковой сети, а затем для другой. В принципе в нём можно прописать параметры для всех поисковых систем, однако, зачастую не имеет смысла это делать, т.к. конкретно для России основными считают Яндекс и Гугл, с остальных поисковых систем трафик настолько мал, что ради них нет необходимости прописывать отдельные запреты и разрешения.

Зачем он нужен?

Если вы сомневаетесь нужен ли robots txt вообще, то ответ однозначный – ДА. Данный файл показывает поисковым системам куда им ходить нужно, а куда нет. Таким образом, с помощью «Роботса» можно манипулировать поисковыми системами и не давать индексировать те документы, которые вы бы хотели оставить в тайне.

Важно! К файлу robots txt Яндекс относится, так сказать, с уважением, он всегда учитывает все нововведения и поступает так, как указано в файле. С Google ситуация сложнее, чаще всего поисковый гигант игнорирует запреты от «Роботса», но тем не менее лично я рекомендую всё равно прописывать все необходимые данные в этот файлик.

Зачем не пускать поисковики к каким-то файлам или директориям?

- Во-первых, некоторые директории (например теги в WordPress или страницы пагинации) оставляют много «мусора» в выдаче, что негативно сказывается на самом сайте.

- Во-вторых, быть может вы разместили неуникальный контент, но очень нужно, чтобы он был на сайте, с помощью robots.txt можно не дать поисковому роботу добраться до такого документа.

Где находится?

Файл robots.txt располагается в корне сайта, т.е. он всегда доступен по адресу site.ru/robots.txt. Так что если вы раньше не знали, как найти robots txt на сайте, то теперь вы с лёгкостью сможете посмотреть и возможно отредактировать его.

Зная, где находится данный файл, вы теперь без труда сможете заменить старый и добавить новый robots.txt на сайт, если в этом есть необходимость.

Robots txt для WordPress

Правильный robots.txt для WordPress вы можете скачать с моего блога.

User-agent: * Disallow: /cgi-bin Disallow: /wp-admin Disallow: /wp-includes Disallow: /wp-content/plugins Disallow: /wp-content/cache Disallow: /wp-content/themes Disallow: /trackback Disallow: */trackback Disallow: */*/trackback Disallow: */*/feed/*/ Disallow: */feed Disallow: /*?* Disallow: /tag Disallow: */attachment/* Disallow: /page Disallow: */page/ Disallow: /poisk User-agent: Yandex Disallow: /cgi-bin Disallow: /wp-admin Disallow: /wp-includes Disallow: /wp-content/plugins Disallow: /wp-content/cache Disallow: /wp-content/themes Disallow: /trackback Disallow: */trackback Disallow: */*/trackback Disallow: */*/feed/*/ Disallow: */feed Disallow: /*?* Disallow: /tag Disallow: */attachment/* Disallow: /page Disallow: */page/ Disallow: */seo/seo-sovety Host: house-computer.ru Sitemap: http://house-computer.ru/sitemap_index.xml

|

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 |

User-agent: * Disallow: /cgi-bin Disallow: /wp-admin Disallow: /wp-includes Disallow: /wp-content/plugins Disallow: /wp-content/cache Disallow: /wp-content/themes Disallow: /trackback Disallow: */trackback Disallow: */*/trackback Disallow: */*/feed/*/ Disallow: */feed Disallow: /*?* Disallow: /tag Disallow: */attachment/* Disallow: /page Disallow: */page/ Disallow: /poisk

User-agent: Yandex Disallow: /cgi-bin Disallow: /wp-admin Disallow: /wp-includes Disallow: /wp-content/plugins Disallow: /wp-content/cache Disallow: /wp-content/themes Disallow: /trackback Disallow: */trackback Disallow: */*/trackback Disallow: */*/feed/*/ Disallow: */feed Disallow: /*?* Disallow: /tag Disallow: */attachment/* Disallow: /page Disallow: */page/ Disallow: */seo/seo-sovety

Host: house-computer.ru

Sitemap: http://house-computer.ru/sitemap_index.xml |

После того как вы скачали мой robots.txt для WordPress, в нём необходимо будет исправить домен на свой, после этого смело заливайте файлик к себе на сервер и радуйтесь тому, как из поисковой выдачи выпадают ненужные «хвосты».

Кстати, не пугайтесь, если после 1-2 АПов Яндекса у вас вдруг резко сократится количество страниц в поисковой выдаче. Это нормально, даже наоборот – это отлично, значит ваш robots.txt начал работать и в скором времени вы избавитесь от не нужного хлама, который раньше висел в SERP’e.

Так что если вы не знаете, как создать robots txt для WordPress самостоятельно, то рекомендую просто скачать готовый вариант с моего блога, лучше вы вряд ли составите.

Теперь давайте поговорим о том, как полностью закрыть от индексации весь сайт с помощью данного чудо-файлика или наоборот, как разрешить всё, используя robots.txt.

Пример Robots.txt: disallow и allow, host и sitemap

Как было сказано выше, с помощью robots txt можно как запретить индексацию сайта, так и разрешить всё.

Disallow

Данной командой вы закроете весь сайт от индексации поисковых систем. Выглядеть это будет так:

User-agent: *Disallow: /

Таким образом, вы полностью закроете сайт от индексации. Для чего это делать? Ну, например, как я рассказывал ранее, в статье про стратегию наполнения нового сайта. Изначально вы добавляете файл robots.txt в корень сайта и прописываете код, который указан выше.

Добавляете необходимое количество статей, а затем, скачав мой идеальный robots txt, открываете от индексации только необходимые разделы на сайте или блоге.

Чтобы в robots txt разрешить всё, вам необходимо написать в файле следующее:

User-agent: *Disallow:

Т.е. убрав слэш, мы показываем поисковым системам, что можно индексировать абсолютно всё.

Кроме того, если вам необходимо закрыть какую-то конкретную директорию или статью от индексации, необходимо просто дописывать после слэша путь до них:

Disallow: /page.htm

Disallow: /dir/page2.htm

Allow

Данный параметр наоборот открывает для индексации какую-то конкретную страницу из закрытой Disallow директории. Пример:

Disallow: /dir/

Allow: /dir/ page2.htm

Прописываем Host и карту сайта

В конце файла robots txt вам необходимо прописать два параметра host и sitemap, делается это так:

Host: www.site.ru

Sitemap: www.site.ru/sitemap.xml

Host указывается для определения правильного зеркала сайта, а второе помогает роботу узнать, где находится карта сайта.

Проверка Robots.txt Яндексом и Google

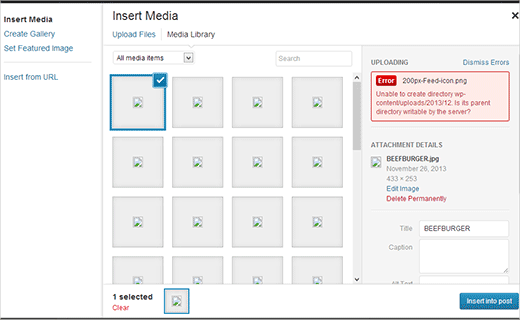

После того как вы сделали правильный robots.txt и разместили его на сайте, вам необходимо добавить и проверить его в вебмастере Яндекса и Гугла, кстати, о том, как добавить сайт в вебмастеры этих поисковых систем я уже писал.

Чтобы проверить Robots.txt Яндексом необходимо зайти в https://webmaster.yandex.ru/ —> Настройка индексирования —> Анализ robots.txt.

В Google заходим http://google.ru/webmasters —> Сканирование —> Инструмент проверки файла robots.txt

Таким образом вы сможете проверить свой robots.txt на ошибки и внести необходимые коррективы, если они есть.

Резюме

Ну вот, думаю, мне удалось объяснить вам, что такое robots.txt, для чего он нужен.

В следующий раз я расскажу вам о супер-плагине WordPress SEO by Yoast, без которого, я считаю, нельзя начинать успешное продвижение сайта.

Похожие статьи:

house-computer.ru

Самый правильный robots.txt для wordpress 2016

В этой статье расскажу как правильно составить robots.txt для сайта на движке wordpress , для чего он служит, и конечно же приведу пример его правильного написания.

Для чего нужен текстовый файлик robots.txt?

Файлик robots.txt требуется для правильной индексации сайта ,он сообщает поисковым роботам что именно можно индексировать а что нет. В этом файле можно запрещать индексирование различных папок движка, файлов, запрещать индексировать админ часть сайта и т.д.

Для того чтобы поисковый робот правильно индексировал сайт, необходимо грамотно прописать файл robots.txt. Тем самым роботы будут индексировать нужные разделы сайта не тратя при этом время на внутренние файлы сайта которые должны быть обязательно закрыты.

Поисковый робот Яндекса будет строго придерживаться правилам которые вы пропишете в файле robots.txt и тем самым ускорить индексацию нужных разделов сайта. Что касается робота Гугла, если не настроить файл robots.txt , то все что связанно с движком и не нужными разделами сайта, все это попадет в поиск Гугл а это не есть хорошо.

Для проверки файла robots.txt можете воспользоваться обеими инструментами Вебмастера Гугла Яндекса.

Как найти файл robots.txt ?

Файл robots.txt расположен в корневом каталоге вашего сайт. Если данного файла нет создайте его и залейте через FTP в корневой каталог вашего сайта. Залить его можно разными способами. Воспользоваться специальной программой под названием FileZilla или создать его на хостинге, если это позволяет данный ресурс.

Если хотите просмотреть что содержится в вашем robots.txt, напишите в браузерной строке http://адрес_сайта/robots.txt

Правильный robots.txt для WordPress

Как и обещал правильный robots.txt для WordPress, перепишите его, после чего вставте его в корневой каталог и все готово.

Обозначения строк и правил Robots.txt/

- «User-agent: *» Все правила которые мы прописываем, относятся и будут работать для всех поисковиков и поисковых роботов.

- «User-agent: Yandex». Это правило означает что приведенные правила в нашем файле относятся только к поисковику Яндекс.

- «Allow:» — это правило для разрешения к индексации.

- «Disallow:» — это правило запрещает индексировать разделы сайта и файлы,папки, которые вы укажите в robots.txt.

- «Host: ваш_сайт.ru» Это правило для указания зеркала вашего сайта.С www или без него.

- «Sitemap:» — ссылка на XML-карту вашего сайта.

На этом я думаю закончим, я не стал выкладывать файл для скачки а выставил на скриншоте, так как хочу что бы разобрались в нем пока будете самостоятельно переписывать его)) Удачи всем!!

Так же вам будет интересно:

blogerwork.ru

Примеры robots.txt WordPress для Яндекса и Google. Как правильно составить robots.txt

В сегодняшнем видео уроке по WordPress SEO я расскажу и покажу на примерах особенности создания и использования файла robots.txt для WordPress, этот урок не планировался как исчерпывающее руководство по robots.txt, но он должен дать вам хорошее представление о том что это за файл и что туда добавлять для минимизации попадания ненужных файлов в индекс поисковых систем и как его использовать для управления тем как поисковые роботы Google и Яндекс индексируют ваш сайт. Если у вас возникнут вопросы — пишите в комметариях, ниже привожу текстовый транскрипт видео, на тот случай если у вас возникнут вопросы или будет нужен фрагмент кода в текстовом виде.

Текстовый транскрипт видео:

Здравствуйте,

Меня зовут Дмитрий, и в этом видео вы узнаете о том, как контролировать индексирование вашего сайта поисковыми системами с помощью файла robots.txt. Плюс в качестве примера мы разберем robots.txt для WordPress, который минимизирует индексирование ненужных файлов поисковыми системами. Итак, приступим.

Для чего нужен файл robots.txt

Файл robots.txt – это текстовый файл, находящийся в корневой директории сайта, в котором записываются специальные инструкции, запрещающие посещение и индексирование отдельных разделов сайта. robots.txt предназначен для использования ботами, в качестве примера ботов можно назвать поисковых роботов Яндекса и Google или ботов архиваторов, как например робот Web Archive.

Для создания robots.txt воспользуйтесь любым текстовым редактором, заполните его в соответствии с вашими пожеланиями и примерами в этом видео и сохраните как просто тест без форматирования, расширение файла должно быть .txt. После этого необходимо загрузить файл в корневой каталог вашего сайта.

Используйте файл robots.txt для ограничения поисковых роботов от индексации отдельных разделов вашего сайта. Вы можете указать параметры индексирования своего сайта как для всех роботов сразу, так и для каждой поисковой системы в отдельности, используя директиву User-Agent. Для списка роботов популярных поисковых систем перейдите по ссылке в описании этого видео.

Пример robots.txt для WordPress

В качестве примера robots.txt для WordPress, который минимизирует индексирование ненужных файлов поисковыми системами, вы можете использовать следующий шаблон:

User-Agent: * Disallow: /wp-content/plugins/ Disallow: /wp-content/themes/ Disallow: /wp-admin/ Disallow: /*.swf Disallow: /*.flv Disallow: /*.pdf Disallow: /*.doc Disallow: /*.exe Disallow: /*.htm Disallow: /*.html Disallow: /*.zip Allow: /Давайте разберем по порядку, что здесь написано. Строчка User-Agent: * говорит, что это относится к любым агентам, к любым поисковым системам, к любым ботам, которые посещают сайт. Строчки, начинающиеся с Disallow: — это директивы, запрещающие индексирование какой-либо части сайта. Например, строчка Disallow: /wp-admin/ запрещает индексирование папки /wp-admin/, любых файлов, которые находятся в папке /wp-admin/. Сейчас у нас запрещены к индексированию папки – плагины, темы и wp-admin (/plugins/ /themes/ /wp-admin/). Директива Disallow: /*. и расширение файла запрещает к индексированию определенный тип файлов. В данный момент запрещены к индексированию .swf, *.flv, *.pdf, *.doc, *.exe, *.js, *.htm, *.html, *.zip. Последняя строчка Allow: / разрешает индексирование любых других частей сайта и любых других файлов.

Если вы используете плагин кеширования, который генерирует статичные версии ваших страниц или структуру постоянных ссылок, оканчивающуюся .htm/.html, уберите строчки

Disallow: /*.htm Disallow: /*.htmlВ общем, если в адресной строке браузера адреса ваших страниц заканчиваются на .htm или .html, то уберите эти две строчки из robots.txt, иначе вы запретите к индексированию большую часть вашего сайта. Если вы хотите открыть все разделы сайта для индексирования всем роботам, то можете использовать следующий фрагмент:

User-agent: * Disallow:Так как помимо полезных ботов (например, роботы поисковых систем, которые соблюдают директивы указанные в robots.txt) ваш сайт посещается вредными ботами (спам боты, скрейперы контента, боты которые ищут возможности для инъекции вредоносного кода), которые не только не соблюдают правила, указанные в robots.txt, а, наоборот, посещают запрещенные папки и файлы с целью выявления уязвимостей и кражи пользовательских данных. В таком случае если вы не хотите явно указывать адрес папки или файла, запрещенного к индексированию, вы можете воспользоваться директивой частичного совпадения. Например, у вас есть папка /shop-zakaz/, которую вы хотите запретить к индексированию. Для того, чтобы явно не указывать адрес этой папки для скрейперов и ботов шпионов вы можете указать часть адреса:

Disallow: *op-za*или

Disallow:*zakaz*Символ * заменяет произвольное количество символов, тогда любые папки и файлы, содержащие в своем названии эту комбинацию, будут запрещены к индексированию. Старайтесь выбирать часть адреса, который уникален для этой папки, потому что если эта комбинация встретится в других файлах и папках, вы запретите их к индексированию.Для того, чтобы случайно не запретить к индексированию нужную часть сайта всегда имеет смысл проверить, как поисковые системы воспринимают правила, указанные в вашем robots.txt. Если вы — подтвержденный владелец сайта в инструментах вебмастера Google или Яндекс — вы можете воспользоваться встроенными инструментами для проверки правил robots.txt.

Проверка robots.txt в Google Webmaster Tools

Для того, чтобы проверить robots.txt в Google Webmaster Tools перейдите в секцию «Crawl>Blocked URLs», здесь вы можете воспользоваться текущей версией robots.txt или же отредактировать ее, чтобы протестировать изменения, затем добавьте список URL, которые вы хотите протестировать и нажмите на кнопку «Проверить». Результаты теста покажут, какие из указанных URL разрешены к индексированию, а какие запрещены.

Проверка robots.txt в Яндекс Вебмастер

Для того, чтобы проверить robots.txt в Яндекс Вебмастер перейдите в секцию «Настройка индексирования>Анализ robots.txt», при необходимости внесите изменения в robots.txt, добавьте список URL и нажмите кнопку «Проверить». Результаты теста покажут, какие из указанных URL разрешены к индексированию, а какие запрещены.

Редактируя правила составьте файл robots.txt, подходящий для вашего сайта. Помните, что файл на сайте при этом не меняется. Для того, чтобы изменения вступили в силу, вам потребуется самостоятельно загрузить обновленную версию robots.txt на сайт.

Заключение

Ну, вот мы и осветили основные моменты работы с robots.txt. Если вам нужны фрагменты и примеры файлов robots.txt, которые я использовал в этом видео, перейдите по ссылке, которая указана в описании этого видео. Спасибо за то, что посмотрели это видео, мне было приятно его для вас делать, буду вам благодарен, если вы поделитесь им в социальных сетях)) Ставьте «палец вверх» и подписывайтесь на новые видео.

Если у вас возникли проблемы с просмотром – вы можете посмотреть видео «Уроки WordPress — правильный файл robots.txt WordPress для Яндекса и Google» на YouTube.

www.azoogle.ru

Как сделать правильный robots.txt для WordPress? |

Приветствую вас мои уважаемые читатели. В этой статье я вам наглядно покажу, как сделать правильный robots.txt, чтобы у вас не было никаких ошибок, которые могут существенно повлиять на продвижение в поисковых системах, таких как Яндекс и Google. Итак, начнем по порядку, чтобы всем было все понятно.

robots.txt – это простой текстовый блокнот в корне вашего сайта, в котором прописаны правила для поисковых ботов, которые индексируют, и заносят новый материал (страницы) в базу поиска. В robots.txt вы множете прописать, что можно индексировать на вашем сайте, а что нельзя.

Данный файлик очень важно создать еще в самом начале создания блога, так как если этого не сделать все ваши усилия могут пойти прахом и ваш сайт попадет просто в бан поисковых систем. Если это случится, то развивать сайт уже не будет никакого смысла, так как вывести сайт из бана, который, кстати, еще называют фильтром АГС, будет очень трудно. На практике мало кто смог вывести сайт из АГС меньше чем за год.

Теперь я думаю, вы понимаете, как важен для вас правильный файл robots.txt. Дело в том, что движок WordPress это непростой сайт на html в котором все просто. WordPress создает очень много дублей, на которые у поисковиков аллергия. Дубль — это когда одна и та же страница или часть страницы доступна по разным адресам (урлам) на блоге.

Это также ведет к частичному копипасту, то есть к неуникальному тексту. Например, на моей главной странице http://firstprize.ru/ всегда находится маленький анонс статьи, который принадлежит к статье, которая находится по другому адресу.

Как видите движок WordPress весь так устроен, что у него просто куча дублей, которые делают: метки, категорий, теги, которые надо закрывать от индексаций, а то бан в самом начале пути обеспечен.

Также помимо дублей надо закрыть от индексаций и другие страницы, которые не представляют интереса и ценности, как для поисковиков, так и для посетителей. Например, страницу админки блога там, где вы вводите свой логин и пароль, чтобы зайти на блог. Я думаю, вы не очень обрадуетесь, если однажды увидите в статистке переходов, как кто-то часто вам заходит на эту страницы пытаясь взломать ее, тем самым украсть у вас ваше детище.

Ну, ладно больше не буду вас пугать, а то у вас наверно уже начал глаз дергаться, от того ужаса, что я тут описал ^_^. Чтобы лучше понять, что делает этот файл, просто посмотрите на картинку ниже.

Как сделать правильный robots.txt для WordPress?

1) Сделайте на рабочем столе файл, который называется блокнот, и назовите его robots.txt. Хочу подметить, что некоторые делают одну грубую ошибку называя файл Robots.txt или robot.txt. Внимательно смотрите, как вы называете файл, а то поисковые боты просто будут игнорировать его, что непременно приведет, как я уже писал выше к фильтру АГС.

2) Теперь нам надо заполнить данный файл, то есть прописать в нем правила для ботов их называют директориями.

1) Первая директория, с которой обязательно должен начинаться файл robots.txt это User-agent. Он отвечает, какую выполнить команду роботу той или иной поисковой системы, которая будет указана далее. Например, если вы хотите данное правило прописать для всех поисковых ботов, то надо добавить в конце звездочку.

Пример: User-agent: *

Если же вы хотите, чтобы данным правилам придерживался только поисковые боты Google, то вместо звездочки надо прописать называние бота Google.

Пример: User-agent: Googlebot

Вот вам, кстати, список названий ботов популярных поисковых систем.

Поисковики. Поисковые роботы.

Google Googlebot

Yahoo! Slurp

Яндекс Yandex

Рамблер StackRambler

Мэйл.ру Mail.Ru

Апорт Aport

В нашем случай мы будем прописывать две директорий. Одну для всех поисковиков и одну для Яндекса, так как он у нас жутко капризный и требует к себе особого внимания.

2) В robots.txt есть еще две важные директорий. Первая это Allow, которая разрешает ботом индексировать и Disallow, которая запрещает индексировать. Какой бы вы не составляли robots.txt в нем обязательно должна быть хотя бы одна директория Disallow в отличи от Allow, а то ваш robots.txt будет неправильным.

По сути можно вообще не пользоваться директорией Allow, так как с помощью директорий Disallow можно не только закрыть, но и открыть индексацию роботом. Вот смотрите, если мы так пропишем в нашем robots.txt директорий, то мы разрешим индексировать поисковому роботу Яндекса весь блог.User-agent: *Disallow:

А вот если поставить черточку / после Disallow: то мы запретим индексировать наш блог Яндексу.User-agent: *Disallow: /

Некоторые веб-мастера закрывают свой ресурс от ботов Yahoo, так как у него есть специальная панель, по которой можно спалить (посмотреть) ссылки, ведущие на другие сайты. То есть по нему можно наглядно определить, какое количество и качество ссылок надо купить, чтобы добиться таких же результатов, как сайт конкурента.

Поэтому многие прописывают дополнительную директорию для Yahoo, чтобы он не индексировал их ресурс и заодно не палил их беки (ссылки) ведущие на сайт. Если вы тоже хотите закрыть индексацию от Yahoo, то пропишите в вашем robots.txt такую строчку:

User-agent: Slurp

Disallow: /

3) Теперь нам надо закрыть страницы, которые относятся непосредственно к движку WordPress.Disallow: / wp-login.phpDisallow: /wp-register.phpDisallow: /webstat/Disallow: /wp-content/themesDisallow: /wp-content/pluginsDisallow: /wp-content/languagesDisallow: /wp-content/cacheDisallow: /wp-admin/Disallow: / wp-includes/

В папке wp-content нет ничего ценного кроме наших картинок, которые лежат в папке uploads поэтому мы отдельно прописали правила для всех папок, которые лежат в wp-content. Если же в папке wp-content у вас есть еще свой папки, в которых лежат скрипты или еще что-то, что лучше на вид не показывать, то также прописываем в файле robots.txt эту папку.

4) Теперь закрываем страницы, которые делают нам дубли.

Disallow: /feed/Disallow: /trackbackDisallow: */trackbackDisallow: */feedDisallow: */commentsDisallow: /*?*Disallow: /*?Disallow: /category/*/*

5) Ок и в самом конце прописываем еще три строчки.Host: firstprize.ruSitemap: http://firstprize.ru/sitemap.xmlSitemap: http://firstprize.ru/sitemap.xml.gz

sitemap.xml — это карта вашего сайта для поисковых роботов, которая помогает намного быстрее проиндексировать ваш ресурс. Данную карту можно сделать с помощью плагина Simple Google Sitemap или на этом сайте. Если будете делать на mysitemapgenerator.com, то после того, как сделайте карту sitemap.xml вам надо будет ее потом закинуть в корень вашего блога.

6) Вот вам пример, как должен выглядеть правильный файл robots.txt для WordPress. Только не копируйте его себе, так как я тут просто поясняю, какая страница за что отвечает.

User-agent: * — разрешить индексировать блог всем ботам поисковых систем.Disallow: /wp-login.php – запретить индексировать страницу авторизаций.Disallow: /wp-register.php – запретить индексировать страницу регистраций.Disallow: /webstat/ — запретить индексировать служебные файлы.Disallow: /feed/ — запретить индексировать дубли RSS.Disallow: /trackback — запретить индексировать уведомления в комментариях.Disallow: */trackback — запретить индексировать уведомления в комментариях.Disallow: */feed — запретить индексировать дубли RSS.Disallow: */comments — запретить индексировать комментарии.Disallow: /*?* — запретить индексировать дубли при поиске.Disallow: /*? — запретить индексировать дубли поиска.Disallow: /category/*/* — запретить индексировать дубли в категориях.Disallow: /wp-content/plugins — запретить индексировать плагины блога.Disallow: /wp-content/themes – запретить индексировать тему оформления блога.Disallow: /wp-admin/ — запретить индексировать страницу вход в админку.Disallow: /wp-includes/ — запретить индексировать служебные файлы.Disallow: /comments – запретить индексировать комментарии.

User-agent: Yandex - разрешить индексировать блог поисковику Яндекс.Disallow: /wp-login.phpDisallow: /wp-register.phpDisallow: /webstat/Disallow: /feed/Disallow: /trackbackDisallow: */trackbackDisallow: */feedDisllow: */commentsDisallow: /*?*Disallow: /*?Disallow: /category/*/*Disallow: /wp-content/pluginsDisallow: /wp-content/themesDisallow: /wp-admin/Disallow: /wp-includes/Disallow: /commentsHost: firstprize.ru – название домена вашего сайта, блога.Sitemap: http://firstprize.ru/sitemap.xml — адрес, где лежит карта для ботов.Sitemap: http://firstprize.ru/sitemap.xml.gz — сжатая карта сайта.

3) А вот этот список директорий можно уже скопировать и вставить в ваш robots.txt.User-agent: *Disallow: /wp-login.phpDisallow: /wp-register.phpDisallow: /webstat/Disallow: /feed/Disallow: /trackbackDisallow: */trackbackDisallow: */feedDisallow: */commentsDisallow: /*?*Disallow: /*?Disallow: /category/*/*Disallow: /wp-content/pluginsDisallow: /wp-content/themesDisallow: /wp-admin/Disallow: /wp-includes/Disallow: /comments

User-agent: YandexDisallow: /wp-login.phpDisallow: /wp-register.phpDisallow: /webstat/Disallow: /feed/Disallow: /trackbackDisallow: */trackbackDisallow: */feedDisallow: */commentsDisallow: /*?*Disallow: /*?Disallow: /category/*/*Disallow: /wp-content/pluginsDisallow: /wp-content/themesDisallow: /wp-admin/Disallow: /wp-includes/Disallow: /commentsHost: домен вашего блога

Sitemap: http://ваш блог/sitemap.xmlSitemap: http://ваш блог/sitemap.xml.gz

Только не забудьте в самых последних строчках указать домен вашего блога и его адрес.

Тут, кстати, есть еще пара важны моментов, которые надо обсудить. Как мы видим, я закрыл комментарий от индексации. Некоторые могу не понять, зачем я это сделал? Зачем закрывать комментарий, от индексаций это же бесплатный контент, который помогает нам, нравится поисковикам.

Тут, кстати, есть еще пара важны моментов, которые надо обсудить. Как мы видим, я закрыл комментарий от индексации. Некоторые могу не понять, зачем я это сделал? Зачем закрывать комментарий, от индексаций это же бесплатный контент, который помогает нам, нравится поисковикам.

Дело в том, что многие затачивают каждую свою статью под определенное поисковое слово или фразу, которое должно повторяться в тексте статьи определенное количество раз. Это количество повтора зависит от размера статьи. Так вот если разрешить индексировать комментарий, то нужное количество повтора этого слово будет уменьшаться, то есть в ответах на комментарий надо будет писать ту же самую фразу, по которой продвигается статья.

Также из-за комментариев может поменяться Description (кусок текста статьи в поиске) не в самом привлекательном виде, что уменьшит наши шансы заинтересовать посетителя перейти на наш сайт, блог.

Помимо этого если у вас не стоит какая-нибудь защита от спама, то вас могут завалить левыми ссылками. В этом случай это очень плохо отразится на вашем сайте и Яндекса может даже стошнить, от того обилия спама ведущего на сайты по заказу курительных смесей (спайсы), на сайты адалт тематики (порно), и конечно же на разнообразные лохотроны.

Ок, с этим разобрались теперь поговорим, зачем я закрыл категорий. Ну, как я уже писал выше, они делают дубли на сайте, но тут нужно быть поосторожнее. Дело в том, что некоторые темы для WordPress выводят статьи только по категориям и не показывают их анонсы на главной странице, как у меня. Если у вас нет карты сайта для людей, и у вас не отображаются анонсы на главной страницы блога, то категорий надо открыть, а то поисковики никогда не смогут проиндексировать у вас ни одну статью.

Как проверить robots.txt на ошибки?

4) После того как вы прописали все директорий в файле robots.txt вам нужно закачать его в ваш корень сайта через программу FTP в папку httpdocs (или public_html , www, domains). Потом перейти по ссылке в панель Яндекс Вебмастер и зайти в «настройки индексирования», «анализ robots.txt». Теперь просто нажмите на кнопку «Загрузить robots.txt с сайта» а потом «проверить». Если вы увидите следующие строчки, то у вас правильный robots.txt.

Ок, теперь тоже самое проверим у Google по этой ссылке. Заходим в «сканирование» а потом в «заблокированные URL» и нажимаем «проверить». Тут вам Google также выдаст информацию как Яндекс, если в вашем файле robots.txt будут ошибки. Ну, там например, если вы написали Disllow вместо Disallow.

После того, как вы измените robots.txt его настройки не сразу вступят в силу а тогда, когда к вам снова придет поисковой бот и проиндексирует этот файл заново, после чего вам надо будет еще немного подождать апдейт поисковой выдачи (1-3 месяца).

На этом все. Если у вас еще остались вопросы, как сделать правильный robots.txt для WordPress, то задавайте мне их здесь.

Рубрика: Вебмастеру в помощь Метки: WordPress, Как ускорить индексацию сайта, Коды

firstprize.ru

Идеальный robots.txt для WordPress

Создаём запрет на индексирование непонятных ссылок для сайта работающего на WordPress. Инструкция для сайта на ЧПУ формате. Добавляем директивы в файл robots.txt.

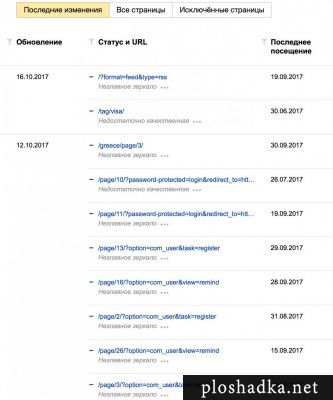

Правильный robots.txt для сайта очень важен. Если его нет или он настроен неверно, то Вордпресс нагенерирует очень много бессмысленных страниц. Особенно это касается сайтов переведенных на «дружественные ссылки» (friendly URL). Такие бессмысленные для поисковика страницы приводят к бану в поисковых системах. Например, Яндекс точно накладывает фильтр на такие сайты.

Если сайт на ЧПУ, то обязательно надо запретить все страницы в адресе которых знаки вопроса. Такие страницы генерируют, как некоторые установленные на сайт плагины, так и сам WordPress:

123 | ?option?formatpage/10/?option=com_user&view=remind |

Страницы могут иметь и другие структуры, но объединяет их всех то, что в своём названии они содержат знаки вопроса. Подобные страницы часто дублируют основные страницы сайта. Откуда берутся такие ссылки непонятно. Например, на одном из своих сайтов я обнаружил в индексе Яндекса очень много таких страниц:

И хотя Яндекс старается исключать такие ссылки автоматически, лучше помочь ему это сделать на раннем этапе и не допускать попадание таких ссылок в индекс. Для этого в файл robots.txt добавим следующее:

Этим самым мы запрещаем все возможные URL вида со знаком вопроса. На сайтах работающих на ЧПУ ссылках все страницы со знаками вопроса — лишние. От таких ссылок можно и нужно избавляться.

Содержимое robots для WordPress

Ниже привожу свою базовую конфигурация для файла robots.txt для WordPress. Под базовой, я подразумеваю файлы, папки и структуры, которые находятся в WordPress с самого начала. Например, категории category или метки tag.

12345678910111213141516171819202122 | User-agent: * Disallow: /cgi-bin Disallow: /wp-admin Disallow: /wp-includes Disallow: /wp-login.php Disallow: /wp-register.php Disallow: /comment-subscriptions Disallow: /tag/*/page/Disallow: /category/*/page/Disallow: /*/*/*/ Disallow: /date/Disallow: /author/Disallow: /*/feed/Disallow: */commentDisallow: /*.php Disallow: /*?* Sitemap: https://ploshadka.net/sitemapindex.xmlHost: https://ploshadka.net |

Поясню ещё несколько моментов.

Эта директива запрещает индексировать все длинные структуры сайта:

Например, у меня на сайтах нет таких длинных адресов, однако кто-то может их использовать. Если таких адресов нет, то WordPress иногда сам их создаёт, тем самым создавая дубли страниц. Как раз для этого и нужна эта строчка. Т.е. такая страница будет проиндексирована:

1 | https://ploshadka.net/programming/php/ |

А такая нет:

1 | https://ploshadka.net/programming/php/something_else/ |

Следующие строчки запрещают индексировать все дополнительные страницы разделов и меток:

12 | Disallow: /tag/*/page/Disallow: /category/*/page/ |

Они не нужны, ведь индексация всех записей будет проходить через навигацию на главной странице.

Последнее на чем я хотел бы заострить внимание:

12345 | Disallow: /date/Disallow: /author/Disallow: /*/feed/Disallow: */commentDisallow: /*.php |

Запрещаем страницы авторов, архивы дат, дубли основных страниц (feed), отдельные страницы с комментариями и любые файлы c php.

ploshadka.net

robots.txt для Wordpress • iTshnick

Что же за файл такой robots.txt и почему он так важен? В этой статье мы разберемся и сами создадим правильный файл robots.txt для WordPress.

- Что за robots.txt такой и зачем он нужен?

- Правильный robots.txt для сайта WordPress

- Проверяем robots.txt в Яндекс Вебмастер и Google Search Console

Для чего нужен robots.txt

robots.txt — это простой текстовый файл на хостинге в корне вашего сайта . Файл-то простой, а вот инструкции которые в нем описаны могут испугать неподготовленный глаз. Но обо всем по порядку.

Файл этот нужен для того чтобы сообщить ПС(поисковые системы — google, yandex, bing…) какие страницы можно индексировать на вашем сайте. Важно чтобы ПС не сканировали внутренние страницы, такие как панель администратора и личные кабинеты пользователей, иначе в сеть могут «утечь» конфиденциальные данные(ФИО, номера телефонов, банковские счета и т.д.) — мы ведь этого не хотим, верно?

Правильный файл robots.txt для сайта WordPress

Ниже приведен пример файла robots.txt для сайта WordPress.

Для использования на вашем сайте:

- Замените site.ru в директиве Host, на URL вашего сайта.

- Замените site.ru в директиве Sitemap, на URL вашего сайта и укажите адрес до файла sitemap.xml если он отличается.

- Добавьте в файл robots.txt вручную или с использованием плагинов WordPress(читайте ниже).

User-agent: Yandex Disallow: /wp-admin Disallow: /wp-includes Disallow: /wp-content/plugins Disallow: /wp-content/themes Disallow: /wp-login.php Disallow: /wp-register.php Disallow: /comments Disallow: */trackback Disallow: */embed Disallow: */feed Disallow: /cgi-bin Disallow: *?s= Host: site.ru User-agent: * Disallow: /wp-admin Disallow: /wp-includes Disallow: /wp-content/plugins Disallow: /wp-content/themes Disallow: /wp-login.php Disallow: /wp-register.php Disallow: /comments Disallow: */trackback Disallow: */embed Disallow: */feed Disallow: /cgi-bin Disallow: *?s= Sitemap: http://site.ru/sitemap.xml

Как добавить или заменить файл robots.txt на сайте WordPress?

Есть несколько вариантов редактирования файла robots.txt.

Ручной способ:

Заходим через FTP в папку с вашим сайтом на хостинге, находим и редактируем файл robots.txt или создаем новый если его нет.

C помощью плагинов:

В плагине Yoast SEO есть возможность редактирования файлов robots.txt и .htaccess. Это очень удобно, так как не нужно лишний раз подключатся на сайт по FTP.

Переходим SEO -> Инструменты -> Редактор файлов и видим такое окно(если файла robots.txt нет, вы увидите кнопку создать файл)

Вносим изменения, сохраняем и радуемся, что наши секретные данные не утекут в поиск Яндекса или Google.

Ах да, еще не все. Нужно ведь добавить файл в консоли поисковиков — как это сделать читаем ниже.

Проверяем robots.txt в Яндекс Вебмастер и Google Search Console

Для этого нам нужно сначала зарегистрировать сайт WordPress в консоли Яндекса и Google, если сайт уже там, просто проверяем наш файл robots.txt.

Для Google Search Console:

- Переходим по адресу https://www.google.com/webmasters/tools/ и выбираем наш сайт

- Дальше меню слева Сканирование -> Инструмент проверки файла robots.txt

- Ошибок нет, поздравляю, можно идти пить кофе… есть конфетки… 🙂

Для Яндекс Вебмастер:

- Переходим по адресу https://webmaster.yandex.ru и выбираем наш сайт

- Дальше меню слева Инструменты -> Анализ robots.txt

- Проверяем наш файл robots.txt на ошибки. Здесь же можно проверить разрешенные URL, что довольно удобно.

- Ошибок нет, поздравляю, можно идти пить пиво… есть чипсики… гладить кота… 🙂

Понравилась статья, помогла? Напиши в комментарии! Покорми Васяна! 😉

itshnick.ru

Robots.txt для WordPress

Все поисковые роботы, прежде чем сканировать сайт, в первую очередь определяют наличие файла robots.txt.

Все поисковые роботы, прежде чем сканировать сайт, в первую очередь определяют наличие файла robots.txt.

Robots.txt как правило индивидуален как и все сайты в интернете. Поэтому, чтобы правильно составить robots.txt для WordPress, сначало надо четко представлять его назначение и вникнуть в правила написания инструкций. Простое копирование чужого файла может вообще не подойти для вашего сайта и даже препятствовать его индексации. Продвижение неизбежно только в случае вдумчивого подхода и правильном файле robots.txt.

Назначение файла robots.txt

Robots.txt — текстовый файл, который предназначен для роботов поисковых систем. Файл находится в корне сайта (путь относительно доменного имени /robots.txt) и содержит инструкции при помощи которых можно:

- запретить индексацию некоторых разделов, отдельных файлов, страниц или сайта целиком

- указать главное зеркало сайта (основной домен).

Инструкции могут быть как для всех роботов сразу, так и для каждой поисковой системы по отдельности.

Как создать robots.txt

Robots.txt можно создать в обычном Блокноте. Заполните его необходимыми инструкциями и загрузите в корневой каталог вашего сайта. Можете проверить правильность обработки инструкций файла robots.txt, с помощью анализатора файла robots.txt.

Директива User-agent

Робот Яндекса поддерживает стандарт описания www.robotstxt.org/wc/norobots.html с расширенными возможностями.

Перед закачкой определенного пула страниц, робот Яндекса закачивает robots.txt сайта. Если файл не обнаружен или на запрос робота возвращается HTTP-код отличный от 200, считается, что доступ роботу не ограничен.

В самом robots.txt проверяется наличие записей, начинающихся с User-agent:, в них ищутся подстроки Yandex, либо * (регистр значения не имеет), причем, если обнаружена строка User-agent: Yandex, директивы для User-agent: * не учитываются. Если записи User-agent: Yandex и User-agent: * отсутствуют, считается, что доступ роботу не ограничен.

Пример файла robots.txt для WordPress

User-agent: * Allow: /wp-content/uploads Disallow: /download Disallow: /wp-admin Disallow: /wp-content Disallow: /wp-trackback Disallow: /wp-feed Disallow: /wp-comments Disallow: /wp-includes Disallow: /wp-login.php Disallow: /wp-register.php Disallow: /xmlrpc.php Disallow: /topic Disallow: /tag Disallow: /archive Disallow: /page Disallow: /attachment Disallow: */comments Disallow: /comments Disallow: */trackback Disallow: */feed Disallow: /feed Disallow: /?feed= Disallow: /?s= Disallow: /*utm_ Disallow: */comment-page-* Disallow: *?replytocom Clean-param: utm_source Host: www.fortress-design.com User-agent: MediaPartners-Google Allow: / Sitemap: //www.fortress-design.com/sitemap.xmlUser-agent: – указание робота (бота), для которого предназначены нижеуказанные директивы

Disallow: – запрет доступа робота к некоторым частям сайта или сайту целиком

Sitemap: – указание пути к карте сайта sitemaps.xml

Host: – указывается адрес главного зеркала (директиву Host понимает только робот Яндекса)

В 30-й строке дается разрешение роботу Mediapartners-Google (AdSense) анализировать страницы, чтобы определить, какие объявления нужно показывать. Робот Mediapartners-Google имеет отдельный доступ к страницам, независимый от других агентов Google. Обратите внимание, что робот AdSense никак не связан с поисковым роботом Google и его работа не влияет на рейтинг вашего сайта в поиске Google.

Вот какие роботы посещают мой блог

Yandex bot Googlebot WordPress Sogou Spider Google AdSense Unknown robot (identified by 'crawl') Unknown robot (identified by 'bot*') Feedburner Yahoo Slurp Feedfetcher-Google DoCoMo The World Wide Web Worm Unknown robot (identified by empty user agent string) Java (Often spam bot) MagpieRSS Unknown robot (identified by hit on 'robots.txt') BlogPulse ISSpider intelliseek.com NewsGator Online The web archive (IA Archiver) Nutch MJ12bot Alexa (IA Archiver) Speedy Spider Unknown robot (identified by '*bot') Jakarta commons-httpclient Mail.ru bot BaiDuSpider W3C Validator MSNBot NG 1.x (Exalead) StackRambler MSNBot-media Voyager GigaBot Unknown robot (identified by 'robot') Perl tool Powermarks FaceBook bot SurveyBot larbin Netcraft AportДополнительная информация

fortress-design.com