Как создать файл robots.txt для WordPress. Как создать robots txt для wordpress

Как создать файл robots.txt для Wordpress

Всем привет! Начитался и поэкспериментировал я с Robots.txt для WordPress, что информация уже сама просится с кем-нибудь поделиться. Ладно, если было бы что-то страшное и архисложное, а так простенький, текстовый файл, который всего лишь нужно создать на рабочем столе с помощью правой кнопки мыши, переименовать его в robots.txt, записать в нем несколько директив и (закинуть) перенести, с помощью Ftp-клиента ( Total Commander или FileZilla) на сервер, в корневой каталог вашего сайта. Все господа! Дело сделано! Можно теперь и «Трубку Мира» закурить. Но без нескольких уточнений, все же, нам не обойтись.

Всем привет! Начитался и поэкспериментировал я с Robots.txt для WordPress, что информация уже сама просится с кем-нибудь поделиться. Ладно, если было бы что-то страшное и архисложное, а так простенький, текстовый файл, который всего лишь нужно создать на рабочем столе с помощью правой кнопки мыши, переименовать его в robots.txt, записать в нем несколько директив и (закинуть) перенести, с помощью Ftp-клиента ( Total Commander или FileZilla) на сервер, в корневой каталог вашего сайта. Все господа! Дело сделано! Можно теперь и «Трубку Мира» закурить. Но без нескольких уточнений, все же, нам не обойтись.

• Для чего нужен Robots.txt?

Все очень просто. Чтобы поисковые роботы-пауки не «шастали» по вашему сайту где им не следует и не индексировали все, что попало им в «лапы», мы, с помощью разрешающих (Allow) или запрещающих (Disallow) директив (команд), даем им указание (а скорее рекомендуем), что нужно индексировать, а на что не стоит тратить время и трафик.

Кстати, потраченное поисковиком время на сканирование сайта/блога, может отразиться на том, как часто робот будет заходить на вашу интернет-страницу в будущем и, к тому же, будет влиять на дальнейшее seo – продвижение вашего проекта. И если у вас Seo-файла robots.txt нет вообще, или он создан не правильно или с ошибками, то не стоит надеяться на ежедневное сканирование страниц вашего сайта, а это, в свою очередь, чревато редкой индексацией контента. Потому, советую отнестись к составлению Robots.txt со всей ответственностью и, лучше всего, если сделаете это на самом начальном этапе настройки блога/сайта.

♦ Как создать Robots.txt

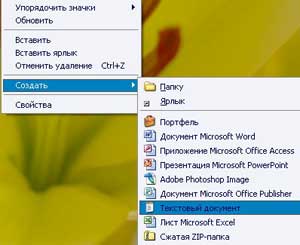

Даже у новичков, надеюсь, это действие не должно вызвать больших проблем. Но, на всякий случай, предлагаю посмотреть скриншот:Повторюсь. На рабочем столе нажимаем правую кнопку мыши и выбираем «Создать» — «Текстовый документ»:

Созданному файлу нужно присвоить имя. Наводим курсор мыши на файл, нажимаем правую кнопку и выбираем «Переименовать». Пишем «robots.txt» без кавычек. Все.Теперь в этот файл нужно записать некоторые директивы.

♦ Что писать в Robots.txt для WordPress?

Основываясь на своей практике, перед тем как создать «robots.txt», было бы не плохо хорошенько изучить дизайн своего блога ( если не вы его делали а, например, поставили шаблонный дизайн), и особенно, обратить внимание на формирование шаблоном ссылок комментариев, rss, feed, меток и т.д., а так же внимательно ознакомьтесь с внутренними файлами и папками, находящимися в корневом каталоге. От этого будет зависеть правильность составления «robots.txt».

Давайте как пример, рассмотрим директивы в моем файле, который можете посмотреть по этой ссылке http://webodyssey.info/robots.txt

User-agent: *Allow: /wp-content/uploads/Disallow: /wp-login.phpDisallow: /wp-register.phpDisallow: /wp-adminDisallow: /wp-includesDisallow: /wp-content/languagesDisallow: /wp-content/pluginsDisallow: /wp-content/cacheDisallow: /wp-content/themesDisallow: /wp-commentsDisallow: */commentsDisallow: /xmlrpc.phpDisallow: /trackbackDisallow: /trackbackDisallow: */trackbackDisallow: /feed/Disallow: */feedDisallow: /*?*Disallow: /*?

Вторая часть файла

User-agent: YandexAllow: /wp-content/uploads/Disallow: /wp-login.phpDisallow: /wp-register.phpDisallow: /wp-adminDisallow: /wp-includesDisallow: /wp-content/languagesDisallow: /wp-content/pluginsDisallow: /wp-content/cacheDisallow: /wp-content/themesDisallow: /wp-commentsDisallow: */commentsDisallow: /xmlrpc.phpDisallow: /trackbackDisallow: /trackbackDisallow: */trackbackDisallow: /feed/Disallow: */feedDisallow: /*?*Disallow: /*?Host: webodyssey.info.Sitemap: http://webodyssey.info/sitemap.xml

♦ Директивы Robots.txt в подробностях

User-agent: — этой записью вы обращаетесь к какому-нибудь поисковому роботу. Как пример, можем записать так: User-agent: YahooВ моем случае, в «User-agent: *» — использован знак подстановки «*», то есть обращение направлено для всех роботов без исключений, тогда как в другой части, те же правила, но предназначены уже для поисковика Yandex.

Allow: /wp-content/uploads/ — Этой командой я разрешил индексировать папкуUploads, (в которой находятся все картинки используемые в статьях), которая, в свою очередь, находится в каталоге wp-content. Эту директорию я прописал в качестве эксперимента, так как мне не очень нравилось, как Гугл индексирует мои картинки.Вам это делать не обязательно и вполне хватит запрещающих команд Disallow:Ведь то, что не запрещено – значит разрешено. Кстати, спустя три месяца, индексация картинок так и не улучшилась (видно причина в другом), потому мне эту строчку, скорее всего, придется убрать.

Disallow: /wp-login.php – такой директивой закроем файл с помощью которого мы, вводя логин и пароль, заходим на блог. К таким служебным, системным файлам и папкам можно отнести:

/wp-register.php/wp-admin/wp-includes/wp-content/languages/wp-content/plugins/wp-content/cache/wp-content/themes/wp-comments

Чтобы запретить роботам индексировать трекбеки, фид и комментарии нужно внести такие записи:

*/comments/xmlrpc.php/trackback/trackback*/trackback/feed/*/feed

Этими записями мы запретим дубли страниц в поисковой выдаче.

Disallow: /*?*Disallow: /*?

Дальше прописан Host: для Яндекса, что бы он видел главное зеркало ( с www или без) вашего блога. Я, например, для пущей уверенности, указал этот же адрес еще и в Вебмастер Яндекс

Ну и в завершении, мы записываем адрес карты сайта в формате .xml. Это делается для облегчения поиска Яндексом этого файла на вашем блоге.

На этом буду заканчивать. Удачи Вам! и до следующих статей.С огромным Уважением, Vladimir Zadorozhnyuk

Понравилась статья? Подпишитесь на новости блога или поделитесь в социальных сетях, а я отвечу вам ВЗАИМНОСТЬЮ

Обратите внимание на другие интересные статьи:

webodyssey.info

Как создать robots.txt для WordPress

Приветствую Вас дорогие читатели — Sozdaiblog.ru!

В данном посте я Вам расскажу, как создать robots.txt для WordPress.

Кто такой, robot.txt? – спросят некоторые.

Чтобы всем было понятно буду объяснять простым и доступным языком.

Robots.txt – это файл, обитающий в корневой папке Вашего блога и указывающий поисковым системам, какие данные Вашего Веб-ресурса нужно сканировать, а какие оставить без внимания.

Тут у Вас опять возникнут вопросы – «Как же так, мы же установили плагин «Google XML Sitemaps» или по другому карта сайта для поисковиков и они знают, что индексировать?

Да, это так, но зачем им, например, индексировать наши каталоги или тысячи комментариев оставленных читателями. Для них, это не целевая и бесполезная информация (индексация Яндекса).

В основном robots.txt, нацелен на работу с поисковой системой – «Яндекс». Но и без него всё будет работать. Не стоит расстраиваться, если у Вас нет или не было данного файла.

Как создать robots.txt для WordPress

Чтобы создать robots.txt для WordPress, Вам потребуется обычный текстовый редактор, который есть на любом компьютере.

На рабочем столе, кликаете правой кнопкой мыши и в открывшемся окне выбираете - Создать =>Текстовый документ.

Создаёте и называете, я думаю, Вы догадались как.

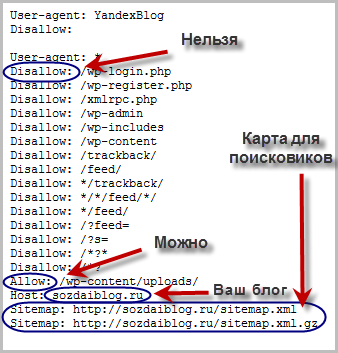

Теперь Вам нужен непосредственно сам файл, выглядит он так:

Специально для Вас, я его уже подготовил, можете скачать по ссылке.

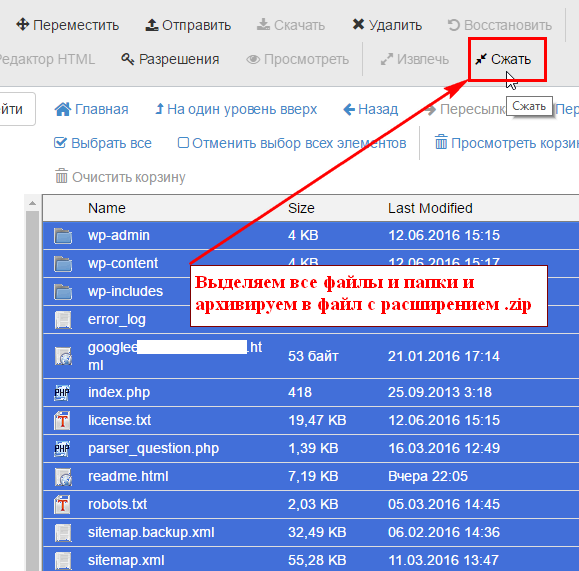

Затем при помощи ftp-клиента закачиваете его в корневую папку Вашего блога.

Вот и всё процедура окончена.

У всех блогов этот файл практически одинаковый.

Для того чтобы посмотреть файл robots.txt любого блога, достаточно в адресной строке браузера, прописать следующее:

- Адрес блога/robots.txt

Если Вы серьёзно захотите углубиться в самостоятельное создание таких файлов, то можете перейти на специализированный сайт. Вот его адрес:

Но, я думаю, данных мною знаний будет вполне достаточно.

Теперь Вы знаете, как создать robots.txt для WordPress и можете пойти прогуляться.

На улице отличная, солнечная погода и много красивых лиц.

А у Вас есть файл robots.txt?

На сегодня это всё. До новых встреч...

С уважением, Денис Черников!

Интересное по теме:

Сделайте, пожалуйста, доброе дело, расскажите о блоге своим друзьям:

Как создать файл Robots txt для WordPress

Всем привет!

Всем привет!

В этой статье поговорим об оптимизации своего блога с помощью файла robots.txt, заточке его под поисковики и зачем это вообще так необходимо.

Как создать Robots txt для WordPress?

Не для кого не секрет, что более 70-80% трафика на наш сайт приходит из поиска или из поисковых систем ( ПС ).

Многие из Вас, имеющие свои личные блоги или сайты пишут на них интересные статьи, тем самым стараясь помочь людям решить их насущные проблемы в той или иной области.

Некоторые блогеры говорят, что им не нужна оптимизация своего сайта( «…зачем нужен этот Robots txt?…») и то,что к ним будет приходить большое количество людей, так как статьи у них уникальные…

Это всё правильно, чем уникальнее статья, тем она лучше индексируется поисковыми системами и тем большее количество людей приходит из поиска. Но нельзя отрицать тот факт, что у поисковых систем есть роботы, которых необходимо задабривать.

Как создать Robots txt

Установим файл Robots на WordPress своего блога и тем самым увеличим поток посетителей с ПС на свой ресурс!

Дело в том, что в директории системы Wordpress находится много вспомогательных скриптов, страниц, файлов, которые просто необходимо закрывать от индексации роботов.

Самая главная функция Robots txt для WordPress это то, что он лежит в корне блога и в нём прописаны все параметры для поисковых роботов, которые указывают, что нужно индексировать на блоге, а что нельзя.

Теперь создадим этот файл, пропишем в него нужные параметры и установим на наш блог. Создать robots.txt для WordPress можно двумя способами :

— Вручную :

Откройте любой текстовый редактор, например Блокнот или Notepad++, создайте новый документ,внесите туда все необходимые параметры (смотрите ниже), сохраните данный документ под названием «robots» и расширением «txt» и затем закачайте на сервер в корень блога.

— С помощью плагина:

Плагин называется «KB Robots.txt». Он очень прост и на странице настроек имеет лишь одно окно формы, в которое и нужно внести все необходимые параметры (смотрите ниже), затем нажать кнопку «Submit» для сохранения.

Вот как выглядит мой вариант файла robots.txt на моём блоге:

User-agent: Yandex Disallow: /wp-admin Disallow: /wp-includes Disallow: /wp-content/plugins Disallow: /wp-content/cache Disallow: /wp-content/themes Disallow: /feed/ Disallow: */feed Disallow: */trackback Disallow: */comments Disallow: /*? Disallow: /*?* Disallow: /tag Disallow: /samorazvitie/ Host: saranchinsergey.ru Sitemap: http://saranchinsergey.ru/sitemap.xmlВнимание!!! Вместо адреса моего блога Вам нужно подставить свой.

Чтобы увидеть как Ваш файл robots.txt (его содержание) выглядит на сервере, в адресной строке браузера к адресу блога через слэш «/» допишите robots.txt

Проблемы при индексации блога

В том случае, если у Вас на сайте не стоит плагин для вывода ссылок ЧПУ, то может возникнуть проблема при индексации страниц.

Всё дело в том, что без ЧПУ ссылки на страницы в адресной строке имеют вот такой вид:

Строчка в файле robots.txt :

Disallow: /*?*как раз запрещает индексацию страниц такого вида. Поэтому, чтобы не возникло проблем, советую Вам перейти по ссылке выше и настроить ссылки ЧПУ на своём блоге.

Как видите я не использую для робота Google запрет Disallow: /*?* в robots.txt и вам не советую. Только для Яндекса!

Запрет Disallow: /*?* не работает для страниц-комментариев, если у вас разрешены древовидные комментарии в WordPress. Поэтому, Яндекс их не будет индексировать, а вот Google за милую душу!

Тем самым таких дублированных страниц у вас появится несметное количество в результатах поисковой выдачи системы Google. Это повлечёт за собой санкции этого поисковика.

Потом будет поздно жаловаться на то, что ваш блог не может подняться на топовые позиции и что трафик упал в несколько раз.

Вы можете просто не использовать кнопку «Ответить» в поле для комментирования, а также чтобы предотвратить эту ситуацию можно просто настроить редирект 301 с таких страниц-дублей.

Для этого зайдите через ФТП в корневую папку своего блога и откройте для редактирования файл .htaccess. Потом пропишите в нём эти строки:

RewriteCond %{QUERY_STRING} ^replytocom= [NC] RewriteRule (.*) $1? [R=301,L]Вот и всё. Теперь если робот перейдёт на такую дублированную страницу, то его сразу же перенаправит на основную страницу.

Правильный robots txt

Кстати, этот вариант файла robots.txt не является истиной в последней инстанции. Но это правильный robots.txt .Я так считаю.

Это связано с тем, что существует большое количество мнений по поводу правильности и целесообразности написания или нет, тех или иных директив в файле.

Однозначный ответ на этот вопрос могут дать только программисты ПС.

Здесь в первую очередь важен результат и результат на данный момент таков:

— В индексе Google и Yandex есть только страницы и публикации блога.

— В панели вебмастера Google и Yandex нет никаких ошибок и замечаний по поводу файла robots.txt

Хочу отметить, что работает мой файл правильно. Я проверял это не раз, проводя аудит блога с помощью различных сервисов.

Ну а теперь ещё одна фишка от меня. Если у Вас блог пока молодой, то в этом надобности нет, но в будущем точно пригодится.

Избавляемся от нагрузки на сервер

Я сейчас говорю о повышенной нагрузке на сервер при сканировании Вашего блога поисковым роботом. Чтобы от этого избавиться, Вам нужно прописать в своём файле robots.txt директиву crawl delay.

Сделать это достаточно просто. Пропишите значение Crawl-delay: 10 после значений Disallow, Allow.

Если Вас интересует тема Как увеличить скорость загрузки блога, то читайте мою статью и применяйте на практике. Очень эффективно!

Обновлённый robots txt для WordPress.

Друзья, а теперь очень важная информация! Если вы посмотрите мой файл robots txt, то увидите, что он уже не похож на тот, который я предлагал вам установить на свой блог ранее в этой статье. А всё потому, что он, к сожалению, не работает!!!

Да, да вы не ослышались. Он не работает! Дело в том, что он на самом деле не запрещает индексацию таких разделов как tag, page, feed, attachment, comment-page, trackback и category. Это приводит к появлению дублей страниц, то есть дублированного контента. А дубли страниц в свою очередь могут привести к фильтрам поисковых систем.

Этот «косяк» заметил уважаемый блогер Александр Борисов и рассказал об этом в статье на своём блоге isif-life.ru. Это был шок для многих блогеров. В результатах выдачи у некоторых были десятки тысяч страниц с дублями. Мой блог тоже попал под раздачу. Посмотрите сколько у меня страниц в индексе Google:

И это притом, что у меня написано 98 статей! 476-98=378 страниц-дублей!!! Фух…мне ещё повезло…

Но ситуация на моём блоге меняется, график уже стабилизировался и скоро этих дублированных страниц будет всё меньше и меньше! Спасибо Александру за помощь!

Поэтому, вы обязательно должны прочитать статью Александра Борисова на блоге isif-life.ru о том, как удалить дубли этих страниц. Но смею заметить, что в статье предоставлена не вся необходимая информация.

Ну вот в принципе и всё. Теперь вы знаете как создать robots.txt для своего блога. Оставьте, пожалуйста комментарии к данной статье. Буду рад услышать Ваше мнение.

Да, кстати, рекомендую вам почитать статью о микроразметке. Это очень важная тема и здорово поможет в продвижении своего блога!

Не забудьте подписаться на обновления моего блога, чтобы получать новые статьи о развитии и продвижении своего блога в сети и заработке в интернете.

P.S. Кстати, ребята, если Вам нужны аккаунты для работы в социальной сети Вконтакте, то есть отличный магазин Грин шоп аккаунтов ВК.

Успехов Вам и Удачи С Уважением,

Другие интересные статьи:

МИНИ-КНИГА ПО ЗАРАБОТКУ В ИНТЕРНЕТЕ: КАК БЫСТРО ВЫУЧИТЬ АНГЛИЙСКИЙ:

КАК БЫСТРО ВЫУЧИТЬ АНГЛИЙСКИЙ:

saranchinsergey.ru