Настройка индексации WordPress сайта поисковыми системами. Индексация wordpress

Настройка индексации Wordpress сайта поисковыми системами

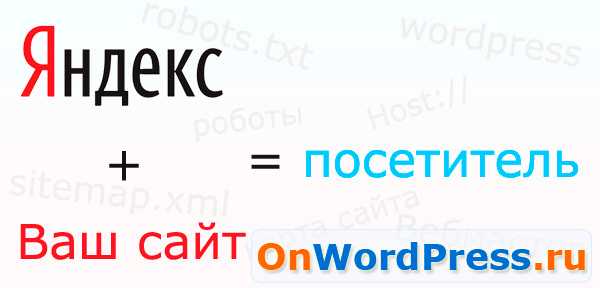

Индексация WordPress сайта крайне важна для успешного продвижения в поисковых системах. От того, насколько хорошо проиндексирован ваш сайт, может зависеть его посещаемость. Поэтому очень важно правильно настроить индексацию WordPress сайта.

Услуга: Настроим индексацию Вашего сайта

Настроим правильную индексацию сайта поисковыми системами. Сэкономьте кучу времени на изучении этого вопроса. Просто закажите услугу, мы сделаем все самостоятельно.

от 900 рублей

Узнать точную стоимость

Как настроить и ускорить индексацию сайта

Настроить индексацию WordPress сайта не сложно. Для этого нужно выполнить следующие действия:

- создать файл robots.txt - очень важно! В этом файле определяются те разделы, которые можно индексировать поисковым система, и те, которые запрещаются для индексирования;

- создать xml карту сайта - sitemap.xml - не менее важный шаг. Карта сайта содержит в себе ссылки на все нужные страницы вашего сайта, и тем самым ускоряет полное индексирование WordPress сайта.

- определить главное зеркало сайта - это нужно для того, чтобы сайт индексировался только по одному адресу. Например www.site.ru и site.ru - это два абсолютно разных сайта в глазах поисковых систем.

Эти процедуры обязательны. Если вы пропустите хотя бы один шаг, ваш сайт, скорее всего, будет индексироваться неправильно или не будет индексироваться вовсе.

Файл robots.txt для wordpress

И так, для сайтов на wordpress мы рекомендуем использовать следующий файл robots.txt. В этом файле вы можете запретить или разрешить индексировать определенные разделы сайта, что направляет поискового робота только в нужные места. Вы можете узнать о настройки файла robots.txt для WordPress более подробно. Ниже вы увидите содержимое стандартного файла robots.txt для wordpress:

User-agent: Yandex Disallow: /cgi-bin/ Disallow: /wp-admin/ Disallow: /wp-includes/ Disallow: /themes/ Disallow: /trackback/ Disallow: /feed/ Disallow: /comment/ Disallow: /tag/ Disallow: /author/ Disallow: /search/ Disallow: /rss/ Disallow: /*.js Disallow: /*.inc Disallow: /*.css Disallow: /*? Disallow: /*.gz Host: www.domen.ru User-agent: * Disallow: /cgi-bin/ Disallow: /*.gz Disallow: /tag/ Disallow: /trackback/ Disallow: /comment/ Disallow: /rss/ Sitemap: http://www.domen.ru/sitemap.xmlКарта сайта - sitemap.xml

Далее необходимо создать карту сайта для wordpress - файл sitemap.xml. Создать XML карту сайта очень легко с помощью специального wordpress плагина Google XML Sitemaps. Очень удобный плагин, легко настраивается под потребности любого сайта. Если у вас блог, то стандартные настройки вполне вам подойдут, и настраивать ничего не потребуется.

Карта сайта отображается в формате .xml и чаще всего доступна по адресу www.yourdomen.ru/sitemap.xml или www.yourdomen.ru/sitemap.xml.gz.

В карте сайта содержатся все ссылки вашего сайта, по которым робот Яндекса легко может определить структуру сайта и перемещаться, индексируя ваш сайт. Желательно добавить карту сайта в панели Яндекс.Вебмастер, на вкладке настройки индексирования сайта. Для этого нужно указать полный путь до карты сайта в единственное поле ввода на странице. Также, я обычно добавляю карту сайта в файл robots.txt:

Sitemap: http://www.domen.ru/sitemap.xmlГлавное зеркало сайта

Для определения главного зеркала сайта, достаточно выбрать его на вкладке настройки индексирования. Также стоит указать главное зеркало в файле robots.txt следующим образом:

Host: www.domen.ruПосле это рекомендуем сделать 301 редирект с не главного зеркала на главное зеркало сайта. Это обычно делается в файле .htaccess вот так:

RewriteEngine On RewriteCond %{HTTP_HOST} ^domen.ru RewriteRule (.*) http://www.domen.ru/$1 [R=301,L]Мифы про индексацию сайта

Хотелось бы немного добавить, также из личного опыта. Я заметил, что поисковый робот Яндекса начинает чаще заглядывать на мои блоги, как только я начинаю чаще писать в них свежие записи. Вероятно, есть какой-то алгоритм, отслеживающий периодичность написания постов, и тем самым поисковый робот адаптируется под ваш конкретный сайт или блог. Возможно это я сам придумал, не воспринимайте буквально :)

Еще заметил, что сайт в последующем лучше индексируется, если при первой индексации было предоставлено «много» контента. Понятие «много» – относительно, но чем больше, тем лучше. А те сайты, на которых при первичной индексации было немного контента - индексировались хуже, даже при том условии, что позже контент добавлялся и обновлялся.

Подробнее про индексацию сайта поисковыми системами

Яндекс, как поисковая система, кажется мне наиболее привлекательной. К тому же, Яндекс имеет удобный интерфейс для веб мастеров. Поэтому я настраиваю индексацию своих сайтов именно под эту поисковую систему.

Для того чтобы ваш сайт на wordpress начал индексироваться, необходимо разрешить доступ поисковым системам к сайту, это делается в панели администратора на вкладке «Параметры - Приватность». Далее следует добавить сайт в очередь на индексацию. Далее, как говорит сам Яндекс, нужно ждать около двух недель, в течение которых поисковый робот проиндексирует ваш сайт. Этого времени вполне достаточно, чтобы наполнить сайт уникальным контентом. Но я считаю, что разрешать индексацию сайта нужно только после того, как сайт будет полностью наполнен информацией.

Чтобы сайт лучше индексировался, его нужно оптимизировать. Как минимум, он должен иметь хорошую навигацию и внутреннюю перелинковку, то есть должно быть достаточное количество внутренних ссылок для наиболее полного сканирования сайта. Соответственно, чем больше внутренних ссылок будет на вашем сайте, тем лучше он будет индексироваться поисковыми системами.

Чтобы анализировать индексацию своего сайта, вам нужно добавить его в список своих сайтов на странице Яндекс.Вебмастер.

Подписывайтесь и получайте полезные статьи на почту!

www.onwordpress.ru

Индексация WordPress сайтов. Файл robots.txt и мета-тег robots

Правильная настройка индексирования сайта напрямую влияет на успешность его будущего продвижения в поисковых системах. В рамках данной статьи я расскажу, как правильно настроить индексацию сайтов на WordPress и полностью избавиться от дублированного контента. Нижеописанная технология многократно опробована и отлично зарекомендовала себя.

Суть данной технологии заключается в том, чтобы использовать для настройки индексации файл robots.txt в сочетании с мета-тегами robots. Таким образом, мы создаем двухуровневую защиту от дублированного контента. При этом даже двойная защита не гарантирует 100% результат, так как поисковые системы могут игнорировать настройки индексации. К счастью, такое бывает очень редко, но мы все же рассмотрим способы для защиты и от этого.

Прежде чем мы перейдем непосредственно к рассмотрению особенностей настройки индексации, определимся, какие страницы существуют в WordPress, какие нужно разрешить индексировать, а какие запретить. Я придерживаюсь мнения, что разрешать индексировать стоит только те страницы, которые нам необходимы. Все остальное необходимо закрывать.

Основные типы страниц в WordPress

В WordPress существует несколько основных типов страниц, которые могут понадобиться нам в работе:

- Статические страницы.

- Страницы записей (постов).

- Страницы категорий (рубрик).

- Страницы тегов (меток).

- Страницы таксономий (произвольные категории и теги).

- Страницы произвольных типов записей.

Также существуют страницы ошибок 404, поиска, страницы вложений и т.д., но с ними мы работать не будем, так как в 99% случаев в этом нет необходимости.

Большинство обычных проектов используют только первые четыре типа страниц, которые доступны в Wordrpess по умолчанию. Чтобы получить доступ ко всем остальным возможностям движка, потребуется внести соответствующие изменения в код шаблона. Так или иначе, мы рассмотрим полную версию кода, чтобы избежать каких-либо проблем в будущем. Код является универсальным и будет работать даже в том случае, если какой-то функционал не реализован.

Использование мета-тега robots

Мета-тег robots является очень мощным инструментом в настройке индексирования сайта. С его помощью можно произвольно разрешать или запрещать индексацию тех или иных страниц, а также разрешать или запрещать поисковым роботам переход по имеющимся на странице ссылкам. Сам мета-тег robots имеет следующий синтаксис:

<meta name="robots" content="значение">В качестве значения мы будем использовать четыре основных конструкции:

- index, follow – разрешить индексацию страницы и переход по ссылкам на ней

- noindex, follow – запретить индексацию страницы, но разрешить переход по ссылкам

- index, nofollow – разрешить индексацию страницы, но запретить переход по ссылкам

- noindex, nofollow – запретить как индексацию, так и переход по ссылкам

Как вы уже поняли, index/noindex разрешает или запрещает индексацию страницы, а follow/nofollow разрешает или запрещает переход по имеющимся на странице ссылкам.

Существуют и другие конструкции, которые могут использоваться в качестве значения для атрибута content в мета-теге robots. Их мы рассматривать не будем, так как практическое применение их невелико.

Код управления мета-тегом robots для сайтов на WordPress

В качестве примера я приведу облегченную версию кода, который позволяет автоматизировать вывод мета-тега robots на сайте, работающем под управлением WordPress. В данном примере не будет возможности произвольно изменять значение мета-тега для отдельных страниц через административную панель сайта. Я убрал эту возможность, так как в 99% случаев в этом просто нет необходимости. К тому же это позволило значительно облегчить код.

if ( ( is_single() || is_page() || is_home() || is_category() || is_tag() || is_tax() || is_post_type_archive() ) && !is_paged() ) { echo '<meta name="robots" content="index, follow" />' . "\n"; } else { echo '<meta name="robots" content="noindex, nofollow" />' . "\n"; }Для установки кода на сайт, достаточно просто добавить его в файл header.php между тегами <head>. Теперь давайте немного разберемся с кодом.

Как видно с примера, мы делаем обычную проверку типов страниц и в зависимости от этого выводим мета-тег robots с нужным нам значением. Для определения типов страниц мы используем встроенные функции WordPress, так называемые условные теги.

- is_single() – для определения отдельных записей (постов).

- is_page() – для определения статических страниц.

- is_home() – для определения главной страницы.

- is_category() – для определения страниц категорий (рубрик).

- is_tag() – для определения страниц тегов (меток).

- is_tax() – для определения архивных страниц пользовательских таксономий.

- is_post_type_archive() – для определения архивных страниц произвольных типов записей.

- is_paged() – для определения страниц с постраничной навигацией.

Вышеприведенный код разрешит индексацию всех страниц постов, статических страниц, страниц категорий и тегов, страниц произвольных таксономий и архивных страниц произвольных типов записей, а также страниц самих произвольных записей, где не выводится постраничная навигация. Все остальные страницы будут автоматически закрыты от индексации при помощи мета-тега robots.

Если вам необходимо запретить индексацию какого-то типа страниц, достаточно просто удалить или закомментировать нужную функцию в коде. Например, если мы хотим запретить индексацию тегов, то достаточно удалить функцию is_tag(). Естественно две вертикальные линии || тоже нужно будет удалить, чтобы избежать синтаксической ошибки в коде.

Если же вам нужно запретить только какую-то конкретную страницу записи, то придется немного модернизировать код. Как вариант, можно использовать произвольные поля. С подробными примерами о том, как это сделать, можно ознакомиться в статье о произвольных полях WordPress.

Итак, с мета-тегами мы разобрались. Теперь перейдем ко второй части статьи и рассмотрим пример оптимального, на мой взгляд, файла robots.txt

Файл Robots.txt для сайтов на WordPress

Файл robots.txt используется для настройки индексации сайта в целом. Обычно в нем используются только общие конструкции, которые позволяют запретить индексирование тех или иных разделов сайта. Все же некоторые умудряются перечислять в нем ссылки на отдельные страницы, с целью исключения их из поиска. Я не считаю это хорошей идеей, поэтому в примере ниже будут только общие конструкции.

User-agent: * Disallow: /wp-admin Disallow: /wp-includes Disallow: /wp-content/plugins Disallow: /wp-content/cache Disallow: /xmlrpc.php Disallow: /wp-content/uploads Disallow: /wp-content/themes Disallow: /trackback/ Disallow: /tag/* Disallow: /feed/ Disallow: */*/feed/*/ Disallow: */feed Disallow: */*/feed Disallow: /*?* Disallow: /?feed= Disallow: /?s=* Disallow: /page/* Disallow: /author/* Host: dmitriydenisov.com Sitemap: http://dmitriydenisov.com/sitemap.xml Sitemap: http://dmitriydenisov.com/sitemap.xml.gzВышеприведенный пример является универсальным для использования на большинстве проектов, работающих под управлением Wordrpess. Он закрывает от индексации системные папки WordPress, требеки, страницы фидов, тегов, поиска, архивные страницы авторов, постраничную навигацию, а также страницы, содержащие в себе параметры GET. Если необходимо добавить/удалить какую-то директорию или страницу, сделать это можно аналогичным образом, используя пример выше.

Защита от дублированного контента на страницах разделовК сожалению, даже все вышеперечисленные способы не дают 100% гарантию того, что закрытые от индексации страницы не будут проиндексированы. Как вариант, кто-то может сослаться на закрытую страницу и она все же может появиться в индексе поисковых систем. Такое иногда бывает. В этом нет ничего плохого, если эта страница не является точной копией другой страницы, которую, к тому же, вы можете продвигать.

Дополнительная защита от дублированного контента особенно актуальна при продвижении страниц с постраничной навигацией. Такими являются страницы разделов, тегов и т.д. Чтобы избежать полных дублей, есть очень простой способ – отключить вывод основного описания страницы при активной постраничной навигации.

if ( !is_paged() ) { основной текст }Таким образом, описание будет отображаться только на первой странице. При переходе на вторую, третью и т.д. описание выводиться не будет. Это позволит избежать дублирования основного текста на страницах с постраничной навигацией.

При использовании всех трех методов можно добиться 100% качества сайта. Под 100% качеством в данном случае я подразумеваю ситуацию, когда в индексе поисковых систем присутствуют только целевые страницы и полностью отсутствуют мусорные. Самый простой способ проверить, все ли сделано правильно – обратиться к поисковой системе Google.

Данная поисковая система очень удобна для проверки сайта тем, что все страницы, которые считает полезными, она заносит в основной индекс. Все остальное попадает в так называемый дополнительный индекс. Сразу хочу заметить, что в поиске участвуют только страницы с основного индекса, поэтому чем ниже качество сайта по мнению Google, тем хуже.

Для проверки качества вы можете использовать следующие конструкции, которые необходимо будет ввести в строку поиска Google.

site:domen.com site:domen.com/&Первая конструкция позволит узнать, какое общее количество страниц проиндексировано поисковой системой. Вторая же конструкция покажет, сколько страниц сайта находится в основном индексе Google. Разделив второе значение на первое и умножив на 100 мы узнаем качество сайта в % по мнению поисковой системы Google.

Для наглядности привожу данные по одному из моих старых проектов.

Также для проверки качества можно использовать плагин для браузера RDS Bar. В нем все расчеты происходят в автоматическом режиме.

Заключение

Использование вышеописанных методов позволит значительно повысить качество сайта в глазах поисковых систем за счет избавления от дублированного контента, что в свою очередь позитивно скажется на динамике продвижения. В индексе будут присутствовать только целевые страницы и ничего больше.

В некоторых случаях это может привести к небольшим потерям трафика за счет уменьшения общего количества страниц в индексе. Это происходит по той причине, что часть страниц с дублями все же попадает в индекс поисковых систем и приносит какой-то трафик. Когда же мы закрываем их от индексации, то исключаем возможность появления этого дополнительного трафика. Это небольшая плата за повышение качества сайта в целом. Так или иначе, каждый сам выбирает, что ему нужно больше.

На этом данная статья подошла к концу. Если у вас остались какие-то вопросы по данному материалу, вы всегда можете задать их в комментариях.

На этом все. Удачи вам и успеха в продвижении сайтов!

Обнаружили ошибку? Выделите ее и нажмите Ctrl+Enter

dmitriydenisov.com

Индексация WordPress. Как закрыть WordPress от индексации

От автора: приветствую вас, друзья. В этой коротенькой и простой статье мы затронем один из многочисленных вопросов, связанных с SEO оптимизацией сайта WordPress. В частности, мы рассмотрим такой вопрос, как индексация WordPress.

На самом деле перед тем, как сесть за написание данной статьи, я сомневался, нужна ли она. Однако, как показывает практика, статья все же может дать ответ на вопрос, который нет-нет да и возникает порой у некоторых владельцев сайта WordPress.

Что же это за вопрос, связанный с индексацией WordPress? Как ни странно, но иногда от пользователей звучит он так: Почему мой сайт не появляется в поисковике? Почему поисковики не индексируют мой сайт? Они его не любят?

Чтобы ответить на такие вопросы, нужно посмотреть на сам сайт, а также уточнить, сколько времени сайт «живет» в сети. Давайте начнем с последнего момента, поскольку зачастую выясняется, что владелец сайта просто оказался нетерпелив. Думаю, вы знаете, что после того, как сайт готов и выложен в сеть, он не сразу появится в поисковике. И даже не через день или неделю. Однако, рядовые пользователи интернета этого вполне могут не знать.

Соответственно, если в ответ на вопрос, сколько сайт «живет» в сети, вы услышите что-то вроде «да вот только вчера сделали», тогда можете успокоить собеседника и объяснить ему, что процесс индексации сайта — это не быстрый и, тем более, не одномоментный процесс. В зависимости от поисковой системы сайт может появится в ней в среднем через пару месяцев. И все это при условии, что поисковому роботу сообщили о появлении нового сайта на просторах интернета.Теперь перейдем к первому моменту, к необходимости взглянуть на сайт. Ведь владелец сайта может сказать, что его детищу уже несколько месяцев, а в результатах поиска его все нет и нет. Здесь уже стоит заглянуть в исходный код сайта, посмотреть файл robots.txt, в общем, необходим хотя бы минимальный аудит сайта.

Хотите быстро научиться создавать сайты и блоги на WordPress с уникальным дизайном?

Получите самую полную в Рунете бесплатную систему обучения создания сайтов на WordPress

Узнать подробнееНебольшой казус из моей практики. Когда-то давно знакомый обратился ко мне со своей ситуацией: полдня, говорит, просидел в Гугле и Яндексе, добрался до сотой страницы в каждом из них, а моего сайта там нет. После недолгого общения выяснилось, что сайт он сделал сам, воспользовавшись одним из бесплатных шаблонов. Сделал он его около года назад. Никаких посторонних ссылок на сайте не размещал. В общем, было понятно, что сайт должен быть уже проиндексирован, но в поиске его действительно не оказалось.

Когда я заглянул в исходный код сайта, то практически сразу все стало понятно. В исходном коде красовалась вот такая вот строка:

<meta name='robots' content='noindex,follow' />Как вы понимаете, эта строка запрещала индексирование сайта. Когда я задал знакомому риторический вопрос, откуда взялось сие безобразие, то в ответ получил ожидаемый недоуменный взгляд.

Прошерстив тему WordPress на предмет «виновника бед», я нигде этого тега не обнаружил. Чтобы исключить возможность вывода зашифрованной в коде темы зловредной строки, я поменял тему на дефолтную, но строка никуда не делась.

И здесь я вспомнил, что WordPress есть возможность закрыть сайт от индексации. Сделать это можно как на этапе установки, так и в дальнейшем из настроек сайта. Вот эта настройка, которую можно отметить на этапе установки:

А вот эта настройка на уже установленном WordPress:

В процессе вспоминания действительно выяснилось, что галочка ставилась знакомым самолично на этапе установки сайта. Поскольку дело сайтостроения для него было новым, то чтобы сайт на второй день не появился в сети в процессе его экспериментов, эта галочка и была отмечена. Впоследствии о ней как-то забылось, а проблема осталась.

В общем, история имела счастливый конец, как в сказке. Ненужная настройка была выключена, строка, блокирующая индексацию, пропала из исходного кода и вскоре сайт уже появился в поисковике.

Вся эта история рассказана как раз для тех пользователей, которые по каким-то причинам использовали данную настройку, закрыв индексацию, а затем просто забыли о ней. Ну и также для тех веб-мастеров, которые столкнутся с аналогичной ситуацией ![]()

Ну а на этом у меня все. Удачи!

Хотите быстро научиться создавать сайты и блоги на WordPress с уникальным дизайном?

Получите самую полную в Рунете бесплатную систему обучения создания сайтов на WordPress

Узнать подробнее

Хотите быстро научиться создавать сайты и блоги на WordPress с уникальным дизайном?

Получите самую полную в Рунете бесплатную систему обучения создания сайтов на WordPress “Уникальный сайт с нуля”

Получить

webformyself.com

Как улучшить индексацию сайта

12.03.2016 | Seo | Теги: seo комментария 3 | 12394 просмотров | Автор статьи: Александр РусУспешность любого интернет-ресурса во многом зависит от его посещаемости. Существует прямая зависимость между высоким процентом посетителей и хорошей системой индексации WordPress сайта. Ниже помещено несколько рекомендаций по соответствующим настройкам и параметрам.

Начнем с описания основных шагов. Для настройки индексации необходимо:

- Создать файл с расширением robots.txt . С помощью него будут определяться разделы, необходимые для индексирования, а также места, запрещенные к доступу.

- Создать sitemap.xml – карту, благодаря которой будут видны ссылки на нужные страницы

- Создать зеркало сайта. Это необходимо для правильного определения главного источника сайта.

Прохождение всех трех шагов крайне важно. Если выпадает какая-либо стратегия, то велика вероятность, что сайт будет индексироваться неправильно или с большим количеством погрешностей.

Основные моменты каждой составляющей

Основным правилом является, наличие и правильная настройка файла robots.txt. Что бы сайт на WordPress нормально индексировался, в нём должно быть прописано следующее

| 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 | User-agent: * Disallow: /cgi-bin/ Disallow: /wp-admin/ Disallow: /wp-includes/ Disallow: /themes/ Disallow: /trackback/ Disallow: /feed/ Disallow: /comment/ Disallow: /tag/ Disallow: /author/ Disallow: /search/ Disallow: /rss/ Disallow: /*.js Disallow: /*.inc Disallow: /*.css Disallow: /*? Disallow: /*.gz Host: www.site.net Sitemap: http://www.site.net/sitemap.xml |

User-agent: * Disallow: /cgi-bin/ Disallow: /wp-admin/ Disallow: /wp-includes/ Disallow: /themes/ Disallow: /trackback/ Disallow: /feed/ Disallow: /comment/ Disallow: /tag/ Disallow: /author/ Disallow: /search/ Disallow: /rss/ Disallow: /*.js Disallow: /*.inc Disallow: /*.css Disallow: /*? Disallow: /*.gz Host: www.site.net Sitemap: http://www.site.net/sitemap.xml

Но в зависимости от тематике, шаблона и многих других аспектов — этот файл подстраивают под сайт, что то удаляют или что то добавляют.

У каждого web-ресурса обязательно должна быть карта.Карта сайта легко создается с помощью соответствующего плагина, как например Google XML sitemap. Его настройки подойдут как для сайтов, так и для блогов. С помощью карты сайта яндекс-робот безошибочно определит все необходимые ссылки. Дополнительно рекомендуется присоединить карту и к панели Вебмастера Яндекса. Для этого полный маршрут к карте вводится в единственное существующее поле.

Зеркало сайта

Необходимо, чтобы главное зеркало сайта находилось в двух важных местах — на вкладке, отвечающей за настройку индексирования, а также в файле robots.txt

Не лишним будет сделать дополнительный редирект 301 с не главного зеркала с помощью файла ht.access.

Настройки индексации через Яндекс

Поисковая система Яндекс имеет удобный интерфейс и является привлекательной для установки индексации для платформы WordPress. Для этого необходимо сделать следующие простые шаги:

- Разрешить доступ систем к сайту

- Добавить желаемый сайт в очередь индексации

- Перед вторым шагом необходимо убедиться, что сайт достаточно наполнен информацией

- Оптимизировать сайт, наполнив его нужным количеством ссылок.

Разрешение/запрещение индексации на WordPress

Важно помнить об установке «по умолчанию», согласно которой на платформе запрещена индексация. Это сделано для защиты поисковых систем от сайтов-«пустышек». Если пользователь уверен, что количества информации на сайте достаточно, можно приступить к следующему шагу — разрешению на индексацию.

Для этого необходимо реализовать следующую цепочку действий. Зайдя в Панель администратора WordPress, необходимо найти вкладку «Параметры-Чтение». На соответствующей странице будет предложено поставить галочку рядом со словами «Запретить» или «Разрешить».

В случае настройки на запрещение индексации, нужно найти опцию «Видимость для поисковых систем». Галочка, расположенная напротив нее, должна быть снята. Еще раз необходимо подчеркнуть, что успешной для индексации является ее правильная настройка. Этой операции должно быть уделено особое внимание.

Условия для ускорения индексации

Существует возможность создания так называемой «быстрой» индексации, которая дает возможность более успешного продвижения сайта в поисковых системах. Данная модель будет работать на основе простого механизма. Поисковый робот будет индексировать страницу только в том случае, если на ней содержится ссылка на другую страницу. Поэтому необходимо правильно настроить систему оповещения.

Оповещение настраивается также пошагово. Необходимо зайти во вкладку «Параметры – Написание». В нижней части странице нужно найти опцию «Сервисы обновления». В ней предстоит работа с текстовым блоком. В него добавляются все адреса систем, которые должны быть уведомлены о поступлении новой информации. Рекомендуемые для уведомления пингаторы можно найти в соответствующих ресурсах в интернете. После того, как система настроек завершена, службы будут уведомлены при каждом новом обновлении сайта/блога.

Установление плагина WordPress Ping Optimizer

Существует опасность, что сигналы об обновлении информации будут поступать слишком часто, и ваш ресурс попадет в черный список. Чтобы этого не случилось, установите плагин WordPress Ping Optimizer. Благодаря ему будет запрещено отправлять пинги при каждом обновлении, но сигнал будет регулярно поступать при создании новой информации.

Данные рекомендации позволят произвести оптимальную индексацию WordPress сайта и обеспечат его эффективную работу.

Автор статьи, Александр Рус.

← Как произвести диагностику сайта через Yandex. Повышение траста сайта. Как оценивается доверие к ресурсу. Что влияет на траст. →

Нажимая на кнопку, я даю согласие на рассылку, обработку персональных данных и принимаю политику конфиденциальности.

myworkpro.ru

Robots.txt для Wordpress - правильная индексация сайта.

Robots.txt определяет правильную индексацию сайтов, в том числе на WordPress CMS. Это делается один раз и помогает акцентировать внимание поисковых систем только на самых значимых страницах сайта, несущих пользу и осмысленное содержание.

Зачем используется файл Robots.txt?

Не секрет, что многие страницы сайтов вне зависимости от желания и намерения его владельца представляют собой технический "мусор". Например, страницы с результатами поиска внутри сайта https://moytop.com/?s=ctr

Поисковики могут неправильно принять эти страницы за важную информацию и начать выдавать их в поиске в ущерб более правильно оптимизированным разделам сайта, отбрасывая их ниже в рейтинге.

Чтобы избежать таких ситуаций, сразу же после создания блога на WordPress рекомендуется составить специальный текстовый файл robots.txt и поместить его в корневую директорию сайта. Каждая поисковая система ориентирована на работу с этим файлом. В нем содержатся конкретные инструкции, с помощью которых можно:

- запретить поисковику проиндексировать весь сайт, отдельные папки или файлы.

- указать на дубликат (зекрало) сайта.

- указать карту сайта.

- дать поисковику рекомендации по установке определенных промежутков времени для того, чтобы оптимально проиндексировать сайт и снизить нагрузку на сервер (актуально для больших многостраничных проектов) и так далее.

Как правильно составить robots.txt для WordPress?

Это обычный текстовый файл, поэтому его можно открыть любым текстовым редактором (я вместо стандартного Notepad, который поставляется с каждой Windows, пользуюсь EditPlus). Повторюсь, находится он в корне сайта. А попасть в корень можно по FTP-доступу, который предоставляет любой хостер (читать "Как зайти на сайт через FTP").

После того, как вы успешно зашли по FTP и открыли файл, смотрим на его содержимое. Для запрета индексации robots.txt должен содержать определенные команды для поисковиков, каждая из которых начинается с новой строки:

User-AgentЭта команда задает поисковую систему, для которой предназначены последующие инструкции. Например, если вы укажете User-Agent: Yandex, то все последующие ниже команды будут относиться именно к этой поисковой системе.

Как правило, для блога выгодно, чтобы все страницы одинаково хорошо индексировались как под Яндекс, так и под Google и другие поисковики, поэтому имеет смысл не разделять инструкции для поисковых систем, а использовать общие правила. Для этого достаточно написать эту команду в таком виде: User-Agent: *

Она означает, что все поисковые системы могут проиндексировать сайт.

DisallowУказывает конкретные страницы и каталоги сайта, которые нужно закрыть от индексации при помощи.

Если все файлы и страницы сайта можно индексировать, то после название оставляете пробел, вот так Disallow: , а если нужно тотально запретить индексацию всех без исключения страниц, то ставите в конце слеш (наклонную черту), вот так: Disallow: /

Но это крайние ситуации. Обычно под «запрет» попадают определенные папки или файлы. Поэтому после слеша указываете полное их наименование.

Примеры использования команд файла robots.txt для WordPress.

Ниже вы найдете примеры robots.txt в котором использованы наиболее частые команды User-Agent и Disallow в разных вариациях. Если нужно оставить комментарий в файле, то начните предложение с этого знака #

Примеры использования Disallow

Эта команда запрещает индексирование и чаще всего используется в таких вариантах.

1. Разрешаете проиндексировать всем поисковикам все страницы без исключения:User-Agent: * Disallow:

2. Запрещаете проиндексировать только Яндексу все на сайте:User-Agent: Yandex Disallow: /

3. Разрешаете проиндексировать все страницы на сайте только поисковой системе Google:User-Agent: Google Disallow:

# продолжение: после первой инструкции оставляем пустую строчку, это важно для безошибочного прочтенияUser-Agent: * Disallow: /

4. Разрешаете проиндексировать всем поисковикам каждую папку, кроме /png/:User-Agent: * Disallow: /png

5. Разрешаете проиндексировать поисковым системам весь сайт, кроме динамических ссылок (например, поисковых запросов внутри сайта на WordPress)User-Agent: * Disallow: /*?s=*

6. Запретить индекацию конкретного файла master.php, который находится в папке includesUser-Agent: * Disallow: /includes/master.php

7. Запретить индекацию любых каталогов и файлов, которые начинаются с download, например, файл download.gifUser-Agent: * Disallow: download

Команда Allow

Имеет обратно Disallow значение - разрешает индексацию для указанных файлов и папок.

# Вот так можно разрешить индексацию лишь для файла myfoto.jpg, которая находится в запрещенной для индексации папке Album.User-Agent: * Disallow: album Allow: /album/myfoto.jpg

Host

Эта директива позволяет указать зеркало сайта, то есть как предпочтительнее отображать имя сайта в поиске - с www или без?. Я предпочитаю без www, для этого нужно написать следующую инструкцию:

Host: moytop.com

где вместо moytop.com нужно вписать свое имя сайта.

Sitemap

Позволяет добавить ссылку на карту сайта, если она, конечно, у вас уже создана.Вот, например, моя карта сайта, которая прописана в robots.txt

Sitemap: https://moytop.com/sitemap.xml

Crawl-delay

Позволяет выставить задержку в секундах перед индексацией отдельных страниц. Если на вашем сайте очень много страниц, которые периодически обновляются, а хостинг - дешевый, то имеет смысл указать значение в 10-15 секунд.

Это позволит снизить нагрузку на хостинг со стороны поисковых систем. Делается это следующей командой:

Crawl-delay: 10

Скачать 100% рабочий файл Robots.txt для WordPress CMS

Эти основные команды вы можете применять для своего сайта на Вордпресс в том или ином виде. У многих сайтов и блогов они будут применяться по-разному, так как могут использоваться разные плагины, разные пути к файлам и разные динамические адреса.

Но я могу порекомендовать вам готовый и проверенный файл Robots.txt, который можно безболезненно использовать на большинстве сайтов под WordPress CMS и который уже отлично себя зарекомендовал. Вы можете посмотреть его в бонусе.

Почему это действительно хороший Robots.txt?Прежде всего потому, что многие найденные в интернете решения блокируют больше чем нужно, например, запрещают индексацию служебных папок вроде /WP-CONTENT/

Раньше это еще было допустимо, но сейчас поисковики (особенно Google) обязательно должны прочитать все нужные служебные папки, чтобы правильно воспроизвести то, как сайт выглядит в глазах рядовых пользователей. А для этого нужен доступ к служебным папкам, содержащим файлы CSS, JS и другие.

Важно! С помощью версии сайта для мобильных устройств можно получать более высокие места в поиске Google (подробнее о том, как создать мобильную версию для WordPress за 10 минут).

Поэтому нужно не запрещать в файле Robots.txt все подряд, а выкинуть только реальные дубли страниц, остальное же разрешить для сканирования - в этом случае сайт будет показываться правильно и вы не увидите ошибок в Google.Webmasters вроде таких: "Googlebot не может получить доступ к файлам CSS и JS на сайте".

Так что можете смело качать мой файл Robots.txt - он проверен на дубли и отлично работает с Googlebot.

Бонус!

Посмотреть и скачать уже готовый пример robots.txt для WordPress можно просто кликнув на значок любой соцсети, в которой вы зарегистрированы - это просто и совершенно бесплатно.

С помощью этих инструкци или готового примера вы можете составить robots.txt для WordPress CMS правильно, с учетом структуры именно вашего сайта. Но обратите внимание, достаточно будет набрать http://адрес-сайта/robots.txt — и любой желающий увидит перечень ваших служебных и системных папок, которые есть на вашем компьютере.

Получение списка каталогов на сервере - это потенциальная угроза для безопасности сайта. Поэтому рекомендую обязательно сделать невозможным получение доступа к таким каталогам. Это очень просто, а позволяет получить дополнительную защиту от взлома.

Как это сделать? Читайте в статье: "Повышаем безопасность WordPress в 2 клика"

moytop.com

Как запретить поисковым системам индексировать сайт на WordPress

Недавно один из наших пользователей спросил, как можно запретить поисковым системам обходить сайт на WordPress и индексировать его. Существует множество ситуаций, когда необходимо закрыть сайт от индексации и появления его в результатах выдачи. В сегодняшней статье мы покажем вам как запретить поисковым системам индексировать сайт на WordPress.

Зачем и кому может понадобиться запрещать поисковые системы на сайте

Для большинства сайтов, поисковые системы являются основным источником трафика. Поэтому возникает вопрос, кто может захотеть блокировать поисковых роботов?

Верите или нет, существует множество пользователей, которые работают над своими сайтами, размещая их на публично доступном домене вместо того, чтобы тестировать его на локальном сервере.

Некоторые люди создают сайты по управлению проектами на WordPress. Также многие используют WordPress для создания личных блогов. Во всех этих ситуациях как раз и понадобится закрыть сайт от индексации поисковыми системами, чтобы вас не нашли раньше, чем вы этого захотите.

Распространенным является заблуждение, что если вы не будете размещать ссылки на свой домен, то поисковые системы никогда не найдут ваш сайт. Это не совсем правда.

Существует множество способов, когда поисковые системы смогут найти сайт, даже если вы нигде его не «засветили». Например:

- Ваш домен мог ранее принадлежать кому-то другому и, соответственно, существуют ссылки на домен, размещенные предыдущим владельцем.

- Некоторые результаты поиска домена могут проиндексоироваться с сохранением ссылки на ваш ресурс.

- Существуют буквально тысячи страниц со списками имен доменов, и ваш сайт может оказаться среди них.

Множество вещей происходят в сети и ни одна из них не подконтрольна вам. Однако, ваш сайт — в вашей власти, и вы можете заставить поисковые системы не индексировать свой сайт.

Блокируем обход и индексацию своего сайта от поисковых систем

В WordPress есть встроенная функция, которая позволяет вам сообщить поисковым системам о том, что не нужно индексировать ваш сайт. Все, что вам нужно сделать, это перейти в Настройки » Чтение и отметить галочку рядом с «Попросить поисковые системы не индексировать сайт».

![search-engine-visibility-settings[1]](/800/600/http/wpincode.com/wp-content/uploads/2014/11/search-engine-visibility-settings1.png)

Когда галочка отмечена, WordPress добавляет следующую строку в хидер сайта:

<meta name='robots' content='noindex,follow' />Также WordPress изменяет ваш файл robots.txt и добавляет в него:

User-agent: * Disallow: /Эти строки «попросят» робота поисковых систем не индексировать ваши страницы. Однако, тут уже будут решать поисковики, реагировать на эти инструкции или нет. Даже не смотря на то, что эти инструкции воспринимаются, некоторые страницы или случайная картинка может быть проиндексирована.

Как убедиться в том, что ваш сайт не появится в выдаче?

Наиболее эффективным способом заблокировать поисковики — защитить паролем весь сайт на WordPress на уровне сервера. Это означает, что любой, кто попробует получить доступ к сайту, увидит запрос имени пользователя и пароля еще до того, как они увидят сам сайт. К поисковикам это тоже относится. Если вход не удастся, отобразится ошибка 401 и робот уйдет. Защитить весь сайт паролем можно следующим образом.

Защищаем весь сайт паролем с помощью cPanel

Если ваш хостер предлагает cPanel для управления хостингом, то можно воспользоваться панелью для защиты сайта. Просто логинимся в cPanel и кликаем на меню «password protect directories».

![password-protect-cpanel[1]](/800/600/http/wpincode.com/wp-content/uploads/2014/11/password-protect-cpanel1.png)

Выскочит всплывающее окно, где нужно будет выбрать корневую директорию.

![choose-document-root[1]](/800/600/http/wpincode.com/wp-content/uploads/2014/11/choose-document-root1.png)

На следующей странице выберите папку, в которой установлен ваш WordPress. Обычно это либо public_html, либо www. После этого отметьте галочку ‘Password protect this directory’. Далее, укажите название для защищенной директории и сохраните изменения.

![username-password[1]](/800/600/http/wpincode.com/wp-content/uploads/2014/11/username-password1.png)

Далее, вы увидите сообщение о том, что все прошло успешно и ссылку для возврата. Нажмите на эту ссылку, и вы попадете на страницу защиты паролем. Теперь вам нужно указать имя пользователя и пароль, который будет нужен для просмотра вашего сайта.

Вот и все, ваш сайт теперь защищен паролем, и никто, включая поисковые системы, не сможет получить доступ к вашему сайту.

У нас также есть статья о том, как защитить паролем ваш сайт WordPress. Однако, в той статье вам нужно будет использовать плагин. В случае же, если вам придется отключить этот плагин, то сайт станет доступен для поисковиков.

Мы надеемся, что эта статья помогла вам запретить поисковым системам индексировать сайт на WordPress.

Если вы только начинаете разбираться с WordPress, то не забудьте посетить нашу рубрику WordPress для новичков, где мы публикуем материалы специально для новых пользователей WordPress.

По всем вопросам и отзывам просьба писать в комментарии ниже.

Не забывайте, по возможности, оценивать понравившиеся записи количеством звездочек на ваше усмотрение.

VN:F [1.9.22_1171]

Rating: 5.0/5 (3 votes cast)

wpincode.com

Как ускорить индексацию Wordpress сайта

Быстрая индексация WordPress блога - это один из важнейших параметров успешного продвижения в поисковых системах.Ранее мы писали на блоге о том, как настроить индексацию wordpress сайта, сейчас вы сможете узнать, как ускорить индексацию сайта на wordpress.

Хочется вам напомнить, что поисковые роботы индексируют страницу, только если на нее ссылается другая страница. Таким образом, если вы опубликовали новый пост на своем блоге, вам придется ждать, пока робот придет на ваш блог с другого блога и проиндексирует новый пост.

Настраиваем систему оповещения и ускоряем индексацию блога

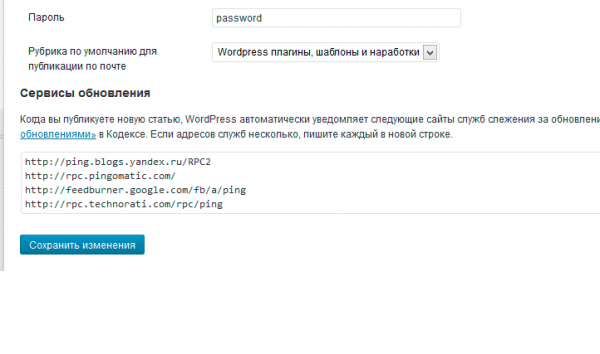

Давно не секрет, что популярные поисковые системы имеют специальные блог службы, которые собирают информацию со всех блогов. Так вот, есть шанс ускорить индексацию WordPress блога, если уведомить эти службы о появлении нового поста на вашем блоге. WordPress имеет встроенную систему оповещения поисковых систем, которую можно настроить в админке WordPress на вкладке "Параметры -> Написание".

В нижней части на странице настроек написания вы найдете пункт "Сервисы обновления". В текстовый блок нужно добавить адреса тех систем, которые необходимо уведомлять о появлении нового поста на вашем блоге. Список рекомендуемых для уведомления систем можете скопировать ниже и добавить в настройки своего блога:

http://ping.blogs.yandex.ru/RPC2 http://rpc.pingomatic.com/ http://feedburner.google.com/fb/a/ping http://rpc.technorati.com/rpc/ping http://blogsearch.google.com/ping/RPC2 http://blogsearch.google.com.ua/ping/RPC2 http://blogsearch.google.ru/ping/RPC2 http://api.my.yahoo.com/RPC2 http://api.my.yahoo.com/rss/pingЭто список основных пингаторов, но в Интернете вы можете поискать более подробный список, при необходимости.

После того, как вы добавите этот список на странице настроек, ваш блог будет уведомлять эти службы об обновлении вашего блога, и есть шанс, что ваш блог будет индексироваться быстрее.

Оптимизация посылаемых пингов

Но мы рекомендуем также установить плагин WordPress Ping Optimizer, который оптимизирует пинги, посылаемые вашим блогом. По умолчанию ваша CMS WordPress будет отправлять сигнал каждый раз, когда вы создаете или обновляете пост на блоге. Но это может привести к тому, что сигналы будут отправляться слишком часто. Из-за этого ваш блог может попасть в черный список.

Но плагин WordPress Ping Optimizer позволяет этого избежать. Этот плагин запретит отправлять пинги при обновлении поста, но сигнал будет отправляться при создании нового поста на блоге.

Подписывайтесь и получайте полезные статьи на почту!

www.onwordpress.ru