Блог про блоги, продвижение, оптимизацию и торговлю. Где находится robots txt в wordpress

Где находится файл robots.txt в wordpress, где лежит и как найти

Если вы посетили эту страницу тогда вас интересует где находится файл robots.txt в WordPress. С данной проблемой обычно сталкиваются чайники в WordPress. После прочтения короткой статьи вы выясните все что вам нужно знать.

По большому счету я могу написать просто «Файл расположен в корневой директории сайта». Увы этот ответ удовлетворит лишь часть посетителей, не все знают о «корнях» и тому подобном. По этому давайте все разберем, как в первый раз.

Как проверить существует ли файл robots.txt

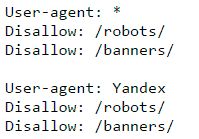

Сперва проверим есть ли нужный файл вообще, для этого вписываем в строке браузера адрес-сайта.ru/robots.txt, если документ откроется, и вы увидите текст на английском, примерно такого рода:

Значит все в порядке, файл существует, в противном случае, скорее всего, отсутствует, или находиться не там где нужно, его потребуется создать.

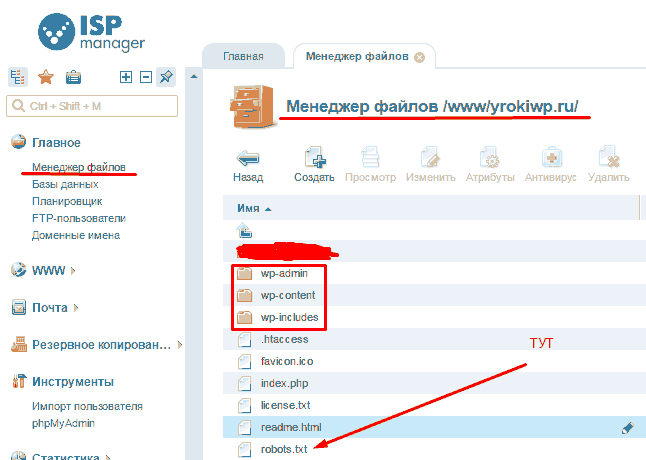

Давайте для начала определимся как вам удобно работать с файлами сайта. Для этого существует несколько способов. Первый не очень удобный, но зато более привычен для любителей Windows — это программа на вашем хостинге, с помощью которой вы создаете и удаляете файлы и папки своего сайта. Выглядеть это все дело должно примерно так:

В папке WWW/ВАШ-САЙТ должны быть папки wp-includes, wp-content, wp-admin ниже них расположен нужный вам файл роботс. Один способ разобрали, можно идти к следующему.

Если вы умеете пользоваться FTP, тогда заходим в соответствующую программу на вашем компьютере и переходим на ваш сайт, проходим тот же путь по папкам что в примере выше и находим необходимый документ.

Файл robots.txt в WordPress должен лежать именно в той же папке, что и wp-includes, wp-content, wp-admin. Не ищите его в других местах, его либо там нет либо он там валяется без толку, роботы его не найдут.

Создать правильное руководство для поисковых систем поможет эта статья.

Поделиться ссылкой:

yrokiwp.ru

Где находится robots txt в Wordpress? (с примером) | Уроки Wordpress, Рекламе, SEO, SMM и Интернет-Маркетинге БЕСПЛАТНО

Файл Robots.txt разработчики добавляют для выдачи директив поисковым роботам. Здесь прописывается, какие разделы те могут посетить и куда входить запрещено. Закрытые от посещения страницы не индексируются. Чтобы корректно настроить файл, указав оптимальные значения, вебмастеру требуется знать, где лежит robots txt на wordpress.

Где можно найти robots.txt

Приступая к обнаружению на сайте wordpress robots txt (где файл лежит), стоит удостовериться в его существовании. Введите в адресной строке: адрес-вашего-сайта.ру/robots.txt. Содержимое файла появится вы увидите в новой вкладке. Если он расположен в некорректном месте, вы получите иной результат: обычно страницу 404 (если вы настроили ее на сайте правильно). Файл потребуется создать.

Где расположить этот файл

Для создания можно использовать «Блокнот» из базового арсенала Windows. Файл на сайте размещается посредством FTP-клиента. Правильный Robots txt должен находиться в корневой папке. К ней сервер обращается, когда посетители вводят доменное имя. Здесь же размещается содержимое сайта: каталоги wp-includes, wp-content и wp-admin. Когда местоположение файла robots.txt иное, приходящие на сайт роботы его не обнаружат, и прописанные там директивы не будут иметь силы. Зная, где следует находиться robots txt, каждый сможет настроить сайт правильно, улучшив позицию в выдаче.

Пример кода robots.txt для CMS WordPress

User-agent: *Disallow: /wp-adminDisallow: /wp-includesDisallow: /trackbackDisallow: */trackbackDisallow: */*/trackback

Sitemap: //readanduse.com/sitemap.xmlHost: readanduse.com

Этот шаблон не претендует на звание лучшего файла robots.txt, а лишь служит основой для модернизации его под нужды Вашего сайта.

Если остались какие-либо вопросы, задавайте их в комментариях.

readanduse.com

Где находится robots.txt в Wordpress? — Toster.ru

Добрый день. Дали сайт на вордпрессе, набираю домент site.ru/robots.txt - в нём User-agent: * Disallow: / Лезу по ftp, в корне лежит robots.txtUser-agent: * Disallow: /cgi-bin Disallow: /search Disallow: /author/ Disallow: *?attachment_id= Disallow: */trackback Disallow: */feed Disallow: */embed #Disallow: /wp/ Host: www.site.ru Как убрать Disallow то от всех поисковиков?.htaccess

RewriteBase / RewriteRule ^index\.php$ - [L] RewriteCond %{REQUEST_FILENAME} !-f RewriteCond %{REQUEST_FILENAME} !-d RewriteRule . /index.php [L] </IfModule> # BEGIN W3TC Browser Cache <IfModule mod_deflate.c> <IfModule mod_headers.c> Header append Vary User-Agent env=!dont-vary </IfModule> AddOutputFilterByType DEFLATE text/css text/x-component application/x-javascript application/javascript text/javascript text/x-js text/html text/richtext image/svg+xml text/plain text/xsd text/xsl text/xml image/bmp application/java application/msword application/vnd.ms-fontobject application/x-msdownload image/x-icon application/json application/vnd.ms-access application/vnd.ms-project application/x-font-otf application/vnd.ms-opentype application/vnd.oasis.opendocument.database application/vnd.oasis.opendocument.chart application/vnd.oasis.opendocument.formula application/vnd.oasis.opendocument.graphics application/vnd.oasis.opendocument.presentation application/vnd.oasis.opendocument.spreadsheet application/vnd.oasis.opendocument.text audio/ogg application/pdf application/vnd.ms-powerpoint application/x-shockwave-flash image/tiff application/x-font-ttf application/vnd.ms-opentype audio/wav application/vnd.ms-write application/font-woff application/font-woff2 application/vnd.ms-excel <IfModule mod_mime.c> # DEFLATE by extension AddOutputFilter DEFLATE js css htm html xml </IfModule> </IfModule> <FilesMatch "\.(bmp|class|doc|docx|eot|exe|ico|json|mdb|mpp|otf|_otf|odb|odc|odf|odg|odp|ods|odt|ogg|pdf|pot|pps|ppt|pptx|svg|svgz|swf|tif|tiff|ttf|ttc|_ttf|wav|wri|woff|woff2|xla|xls|xlsx|xlt|xlw|BMP|CLASS|DOC|DOCX|EOT|EXE|ICO|JSON|MDB|MPP|OTF|_OTF|ODB|ODC|ODF|ODG|ODP|ODS|ODT|OGG|PDF|POT|PPS|PPT|PPTX|SVG|SVGZ|SWF|TIF|TIFF|TTF|TTC|_TTF|WAV|WRI|WOFF|WOFF2|XLA|XLS|XLSX|XLT|XLW)$"> <IfModule mod_headers.c> Header unset Last-Modified </IfModule> </FilesMatch> # END W3TC Browser Cache # BEGIN W3TC CDN <FilesMatch "\.(ttf|ttc|otf|eot|woff|woff2|font.css)$"> <IfModule mod_headers.c> Header set Access-Control-Allow-Origin "*" </IfModule> </FilesMatch> # END W3TC CDN # BEGIN W3TC Page Cache core <IfModule mod_rewrite.c> RewriteEngine On RewriteBase / RewriteCond %{HTTP:Accept-Encoding} gzip RewriteRule .* - [E=W3TC_ENC:_gzip] RewriteCond %{HTTP_COOKIE} w3tc_preview [NC] RewriteRule .* - [E=W3TC_PREVIEW:_preview] RewriteCond %{REQUEST_METHOD} !=POST RewriteCond %{QUERY_STRING} ="" RewriteCond %{HTTP_COOKIE} !(comment_author|wp\-postpass|w3tc_logged_out|wordpress_logged_in|wptouch_switch_toggle) [NC] RewriteCond "%{DOCUMENT_ROOT}/wp-content/cache/page_enhanced/%{HTTP_HOST}/%{REQUEST_URI}/_index%{ENV:W3TC_PREVIEW}.html%{ENV:W3TC_ENC}" -f RewriteRule .* "/wp-content/cache/page_enhanced/%{HTTP_HOST}/%{REQUEST_URI}/_index%{ENV:W3TC_PREVIEW}.html%{ENV:W3TC_ENC}" [L] </IfModule> # END W3TC Page Cache core # BEGIN WordPress <IfModule mod_rewrite.c> RewriteEngine On RewriteBase / RewriteRule ^index\.php$ - [L] RewriteCond %{REQUEST_FILENAME} !-f RewriteCond %{REQUEST_FILENAME} !-d RewriteRule . /index.php [L] </IfModule>toster.ru

Правильный robots.txt для WordPress

Блог / Кодекс WordPress / Рекомендуемое содержимое файла robots.txt для WordPress. Функция do_robots().Относительно того, что должно быть внутри файла robots.txt до сих пор возникает куча споров. Вообще, на мой взгляд, этот файл должен содержать две обязательные вещи:

Скрывать в нём все функциональные PHP-файлы (как делают некоторые вебмастера) я не вижу смысла. А уж страницы сайта тем более. Я проводил эксперимент со скрытием страниц через robots.txt — они всё равно попали в индекс, но только без заголовка и без сниппета.

Для скрытия от индексации страниц сайта используйте метатег:

| <meta name="robots" content="noindex, follow" /> |

Функция do_robots()

Выводит несколько директив для файла robots.txt, рекомендуемые для WordPress.

Параметров не имеет, зато имеет 1 хук и 1 фильтр.

Рассмотрим по порядку, как работает функция:

- В первую очередь функция устанавливает Content-Type документа на text/plain (с кодировкой UTF-8).

- Затем запускается экшен do_robotstxt (без параметров).

- Третьим шагом идёт проверка, отмечена ли галочка «Попросить поисковые системы не индексировать сайт» в настройках чтения:

- Если отмечена, содержимое robots.txt будет:

User-agent: * Disallow: / Если не отмечена:

User-agent: * Disallow: /wp-admin/ - Непосредственно перед выводом срабатывает фильтр robots_txt (WordPress 3.0+) с двумя параметрами — $output (то, что подготовлено для вывода в robots.txt) и $public (отмечена ли галочка в пункте 3).

Готовый robots.txt

К результату функции do_robots() добавим еще то, о чем я говорил в начале поста и получим вот такой robots.txt для WordPress:

| User-agent: * Disallow: /wp-admin/ User-agent: Yandex Disallow: /wp-admin/ Host: truemisha.ru Sitemap: https://misha.blog/sitemap.xml |

Создать его вы можете при помощи любого текстового редактора. Сохраните его там же, где находятся директории wp-admin и wp-content.

misha.blog

Оптимизируем файл robots.txt в WordPress

Если вы хотите порадовать свою любимую цветами, то доставка цветов на дом в москве придется вам как нельзя кстати. А самую быструю и лучшую доставку цветов в Москве вы найдете на сайте king-flower.com.

Файл robots.txt — это очень важный файл на каждом сайте, который планируется продвигать в поисковых системах. По сути, файл robots.txt — это обыкновенный текстовый файл, который содержит в себе все необходимые инструкции для поисковиков о индексировании сайта, о зеркале домена, а так же о файле sitemap.xml. Хотелось бы в данной статье остановиться на составлении robots.txt именно для движка wordpress. Важно при составлении файла robots.txt быть внимательным, так как неправильная настройка может привести к тому, что поисковики не будут вас индексировать.Итак, начнем с того, что разберем основные команды, указывающиеся в файле robots.txt:User-AgentДанная команда указывает имя робота, к которому следует применить правила, описанные под командой.Disallow и AllowДанные команды предназначены для того, чтобы запретить или разрешить доступ роботам к отдельным разделам сайта или к сайту в целом. Важно, чтобы между директивами не было пустых строк. При этом Allow всегда используется первой и только после нее уже Disallow.HostДанная команда указывает для Яндекса главное зеркало сайта.SitemapДанная команда нужна для указания наличия карты сайта, а так же пути к карте.Спецсимвол *Обозначает любую последовательность символов.

Далее я предлагаю пройтись по основным этапам создания файла robots.txt для WordPress. Начинать будем с команды User-Agent. Самыми важными ботами конечно же являются Yandex, YandexBlog, а так же Googlebot. Кроме того для многих важны еще и роботы StackRambler и msnbot(Bing). Если вы настраиваете robots.txt, то можно создать единственное правило для всех роботов, в нашем же случае мы имеем дело с настройкой блога, поэтому стоит дописать дополнительное правило, которое разрешит роботу YandexBlog доступ ко всему(так как он ходит только в фиды и админку сайта):User-agent: YandexBlogDisallow:

Далее, для работы со всеми остальными ботами нам необходимо пропустить одну строчку и дописать следущее:User-Agent: *Теперь давайте задействуем команды Allow и Disallow. Для начала разрешим доступ к директории uploads, в которой расположены изображения, залитые через админку:Allow: /wp-content/uploads/Далее мы закроем от индексирования папку wp-content, а так же служебные директории(админку, плагины, авторизацию и резистрацию):Disallow: /wp-login.phpDisallow: /wp-register.phpDisallow: /xmlrpc.phpDisallow: /template.htmlDisallow: /wp-adminDisallow: /wp-includesDisallow: /wp-content

Дальше вы можете закрыть к примеру индексирование тегов в том случае, если вы хотите избежать дублирование контента внутри блога:Disallow: /tagТак же по желанию можно закрыть и другие разделы сайта:Disallow: /categoryDisallow: /archive

Далее закроем от индексации страницы поиска по сайту, фиды и трекбеки:Disallow: */trackback/Disallow: */feed/Disallow: */comments/Disallow: /?feed=Disallow: /?s=

Далее укажем где располагается карта сайта на вашем блоге:Sitemap: http:// ваш сайт.ru/sitemap.xml

В конечном счете вы должны получить примерно такой файл robots.txt, который будет сообщать поисковым ботам всю необходимую информацию о том каким образом лучше всего индексировать ваш блог на WordPress:

User-agent: YandexBlogDisallow:

User-Agent: *Allow: /wp-content/uploads/Disallow: /wp-login.phpDisallow: /wp-register.phpDisallow: /xmlrpc.phpDisallow: /template.htmlDisallow: /wp-adminDisallow: /wp-includesDisallow: /wp-contentDisallow: /tagDisallow: /categoryDisallow: /archiveDisallow: */trackback/Disallow: */feed/Disallow: */comments/Disallow: /?feed=Disallow: /?s=

Sitemap: http://domain.ru/sitemap.xml

Теги: WordPressgrafchita.ru

Правильный robots.txt для Wordpress

Выполняю данное мною обещание, сегодня речь пойдет о том, как настроить правильный файл robots.txt для WordPress. Что это за файл такой, и насколько он важен для сайта или блога я писал в недавней статье о robots txt для Яндекс.

Совершая «прогулки» по блогам, которые созданы на платформе вордпресс, я заметил, что почти на каждом из них есть ошибки в роботсе. Пусть у некоторых они и не значительны, но из вот таких мелочей порой и складываются в будущем огромные проблемы.Многие блогеры понятия не имеют об этом файлике, а уж тем более о том, где он находится.

Где находится robots.txt в WordPress

Расположение robots.txt в Вордпресс ни чем, ни отличается от другого любого сайта – корневая папка сайта. Где находится данная папка? Естественно на вашем хостинге, эта та папка, в которой находятся все файлы вашего блога или сайта. На каждом хостинге это выглядит по-своему. Достут к корневой директории (папке) возможен через файловый менеджер панели управления вашим хостингом, либо по FTP. Тот, кто знает, что можно зайти в корень сайта по SSH, может воспользоваться и этим методом.

Как создать robots.txt для WordPress

Для начала создадим простой текстовый файл с именем «robots». От кроем его и начинаем прописывать директивы для поисковых систем. Для примера я сделал скрин роботса своего блога, скопировать его можно перейдя по ссылке (если скопировали, не забудьте в дальнейшем его отредактировать).

А теперь пройдемся по всем директивам, что бы вам было понятно что и для чего.

User-agent: Yandex – открываем доступ всем поисковым роботам Яндекса Allow: /wp-content/uploads/ — разрешаем индексировать картинки, это обязательная директива!!! Disallow: /wp- — запрет на индексацию всех системных папок и файлов Disallow: /webstat – это не обязательная директива, добавил ее исключительно в собственных целях, возможно у вас в корне сайта лежат такие папки Disallow: /cgi-bin — без объяснений, это очень долго, да и не нужно Disallow: */trackback – и Disallow: */trackback/ — запрет индексации трекбеков Disallow: */feed – и Disallow: */feed/ — и Disallow: /?feed= — запрещаем индексировать фид, почему так много директив? Все зависит от используемого шаблона, поэтому я сделал так Disallow: */comments – и Disallow: */comments/ – дабы не плодить дубли страниц с комментариями, закрываем, не волнуйтесь, все комментарии будут проиндексированы Disallow: /tag – тут я думаю все понятно, закрываем страницы тегов, лично я их не прописываю, что бы не плодить лишних страниц, которые дублируют контент, но всякий случай директиву прописал Disallow: /category – спорный запрет, если хотите что бы ваши страницы категорий попали в индекс поисковика, уберите эту строчку Disallow: /archive – яснее не куда, закрываем страницы с архивами Disallow: /?wysija- — это я закрыл страницы создаваемые одним из плагинов, вам это не обязательно, об этом плагине я напишу в ближайшем будущем Disallow: /?s= — запрет на индексацию страниц с поиска сайта Disallow: /lin – это тоже вам не нужно, использую эту папку для файлов редиректа Host: platon-shhukin.ru – понятно? Sitemap: /sitemap.xml Sitemap: /sitemap.xml.gz — думаю тоже не возникло проблем. User-agent: * — открываем доступ к сайту всем роботамДирективы прописаны отдельно для Яндекса, и отдельно для всех остальных поисковых роботов.

Вот и все, рабочий файл robots.txt для блога на WordPress готов, остается проверить его, но вы то уже знаете как это сделать? Если забыли, то смотрите еще раз в конце статьи проверка и анализ файла robots txt. Теперь остается загрузить файл в коревую папку вашего сайта, и поисковые системы приступят к правильной индексации вашего блога.

Есть вопросы, спрашивайте в комментариях, постараюсь помочь в меру своих знаний.

platon-shhukin.ru

Файл Robots.txt для блога на Wordpress. Пример

Сегодняшняя статья будет посвящена служебному файлу нашего сайта, который служит путеводной звездой для поисковых роботов. Это файл Robots.txt, для блога на WordPress он является обязательным, так как данная CMS склонна к созданию большого числа страниц и файлов, которые не нужны ни поисковикам ни пользователям.

Неопытные вебмастера нередко пренебрегают данным элементом внутренней оптимизации блога (кто-то о нем не знает, кто-то забывает, а кто-то составляет неправильно). Результатом может стать медленная индексация, постоянные мигания страниц в индексе, но еще хуже — это выпадение нужные документов сайта из выдачи.

Размещается robots.txt в корневой папке сайта, там же где и основной index.php, например, в каталоге public_html. В роботсе прописываются инструкции, по которым происходит индексация сайта поисковыми роботами. С помощью специальных команд (директив) мы запрещаем или разрешаем ботам читать те или иные страницы, прописываем главное зеркало сайта и даем путь к xml карте сайта (Sitemap.xml).

Польза Robots.txt заключается в том, что он запрещает индексировать поисковикам служебные разделы сайта и показывает на те разделы, которые должны попасть в индекс.

Правильный Роботс помогает ускорить индексацию сайта., так как боты не тратят время на чтение ненужных документов. Если данный файл будет составлен некорректно, то поисковики, наоборот, могут выкинуть из индекса нужные страницы, поэтому стоит подойти к его составлению ответственно.

Как создать файл Robots.txt?

Создается Robots.txt любым текстовым редактором, включая блокнот (разрешите порекомендовать вам Notepad++, либо Akelpad, которые имеют некоторые фишки, отсутствующие в блокноте). В файле по порядку прописываются команды общие для всех поисковых систем или индивидуальные для каждого типа робота. Далее файлик размещается в корень сайта на вашем хостинге (папка «/public_html»). Для поисковых роботов данный файл является самым первым, он начинает чтение сайта с него.

Как настроить Роботс.txt?

Формирование правильного файла осуществляется с помощью 3-х основных команд (их понимают все роботы).

1. User-agent

Эта комнада обращается по имени к роботам и указывает какая поисковая система должна воспринимать следующий ниже блок команд.Например:

С помощью знака «*», можем указать, что данный блок для всех входящих роботов. Выглядит так:

2. Команда Disallow

Disallow — это директива, которая служит сторожем для запретных разделов. Все что идет после нее восприниматься поисковиками не должно. Такая структура полностью запрещает индексацию сайта:

User-agent: * Disallow: /

Данный вариант, наоборот, разрешает роботам вытаскивать в поиск все документы, найденные на сайте:

3. Разрешение индексации Allow

Все, что идет после этой команды рекомендовано к попаданию в поиск.

Что открывать, а что закрывать в Robots.txt?

Неверное использование директив может привести к печальным последствиям, о них я уже говорил выше. поэтому, отнеситесь внимательно к написанному ниже. Страницы, которые создают дублированный контент и скапливают мусор, должны быть исключены из поиска, также необходимо закрывать все, что не должно попадать в поисковую выдачу. Служебные, технические и системные файлы WordPress стоят первыми в очереди на запрет. А конкретнее:

Папки:

Disallow: /wp-admin #админка сайта в поиске никчему Disallow: /wp-content Disallow: /wp-includes Disallow: /wp-comments

Disallow: /wp-admin #админка сайта в поиске никчему Disallow: /wp-content Disallow: /wp-includes Disallow: /wp-comments |

Файлы:

Disallow: /wp-login.php Disallow: /wp-register.php Disallow: /xmlrpc.php

Disallow: /wp-login.php Disallow: /wp-register.php Disallow: /xmlrpc.php |

Для того, чтобы не пришлось перечислять каждую папку в дереве папок сайта, можно использовать взаимоисключающие директивы. Например, папка «wp-content» содержит вложенный каталог «uploads», в котором хранятся все изображения статей. Мы хотим получать переходы на сайт не только с текстового поиска, но и с поиска по картинкам, поэтому «uploads» нужно открыть, а «wp-content» закрыть. Для этого используем запрещающую команду для папки верхнего уровня и разрешающую для папки нижнего уровня. В результате в папке «wp-content» запрещенными останутся все разделы, кроме «uploads». Выглядеть будет вот так:

Disallow: /wp-content #вход поисковикам запрещен Allow: /wp-content/uploads/ #папка с картинками будет индексироваться

Disallow: /wp-content #вход поисковикам запрещен Allow: /wp-content/uploads/ #папка с картинками будет индексироваться |

WordPress часто выдает одинаковый текст по разным URL, от появления дублей мы должны избавиться:

В ленте RSS:

В Трэкбэках:

Для комментариев:

Для результатов поиска:

Для архивов:

Пример файла Robots.txt для WordPress

Если у вас есть желание поэкспериментировать в самостоятельным составлением файла, то вы можете это сделать. Это не так сложно, но вы можете не тратить время и взять готовый пример файла robots.txt для WordPress, который уже сделан мной. Он учитывает все важные моменты и даст поисковикам правильные подсказки.

User-agent: * Disallow: /wp-admin Disallow: /wp-content Disallow: /wp-includes Disallow: /wp-comments Disallow: /wp-login.php #запрещаем доступ в админку Disallow: /wp-register.php Disallow: */trackback Disallow: /xmlrpc.php Disallow: */feed Disallow: */author #запрещаем страницы авторов Allow: /wp-content/uploads/ #файлы изображений в постах Allow: /wp-content/themes/orange_green/ #доступ к файлам темы Allow: /wp-content/plugins/ #скрипты плагинов Allow: /wp-includes/js/ #скрипты wordpress host: dmitriyzhilin.ru Sitemap: http://dmitriyzhilin.ru/sitemap.xml

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 | User-agent: * Disallow: /wp-admin Disallow: /wp-content Disallow: /wp-includes Disallow: /wp-comments Disallow: /wp-login.php #запрещаем доступ в админку Disallow: /wp-register.php Disallow: */trackback Disallow: /xmlrpc.php Disallow: */feed Disallow: */author #запрещаем страницы авторов Allow: /wp-content/uploads/ #файлы изображений в постах Allow: /wp-content/themes/orange_green/ #доступ к файлам темы Allow: /wp-content/plugins/ #скрипты плагинов Allow: /wp-includes/js/ #скрипты wordpress host: dmitriyzhilin.ru Sitemap: http://dmitriyzhilin.ru/sitemap.xml |

Не забудьте вместо адреса моего блога, поставить свой.

Дальше, с помощью ФТП клиента filezilla, закиньте созданный файл в корень сайта, в моем случае это «/public_html». Имя и местоположение файла стандартизировано, поэтому поисковые роботы его сразу там найдут. Правда, все правила, которые мы прописали начнут действовать не сразу, а спустя какое-то время.

dmitriyzhilin.ru