Технические ошибки оптимизации сайтов. Ошибки оптимизации сайтов

Исправляем ошибки в оптимизации сайта. Проверяем и находим недочеты

Ошибки на этапе проектирования сайта

- Некорректный сбор семантического ядра

- Неправильное создание структуры

- Неверное распределение ключевых слов

- Непродуманные прототипы страниц

Ошибки на этапе создания сайта

- Наличие дублей страниц

- Низкая скорость загрузки сайта

- Некорректный вывод текстового контента

Ошибки на существующем сайте

- Отсутствие meta тегов и заголовков

- Некорректные meta теги и заголовки

- Неуникальный текстовой контент

- Бесполезный текстовой контент

- Неправильная перелинковка

- Технические настройки

Мало кто задумывается, но ошибки в оптимизации сайта начинаются еще на этапе его проектирования. Половина глобальных недоработок, которые мешают полноценно развиваться ресурсу, приходятся именно на период создания.

Ошибки на ранних этапах, обычно, являются фундаментальными и очень сложны в исправлении. Поэтому, сегодня мы уделим им особое внимание.

Сразу разделим нашу статью на 3 глобальные блока: «Этап проектирования», «Этап создания» и «Готовый сайт».

Ошибки на этапе проектирования сайта

К данному виду ошибок относятся те, которые связаны со сбором семантического ядра, созданием структуры, прототипированием, а также другой аналитической работой. Недоработки на этом этапе могут серьезно повлиять на будущее вашего сайта.

1. Некорректный сбор семантического ядра

От того, как собрано семантическое ядро, будет зависеть структура сайта, наполнение и собственно сама внутренняя оптимизация. Это основа основ. Именно поэтому, данному этапу необходимо уделить особое внимание.

Нужно понимать, что семантика это прямое отражение покупательского спроса, потребности клиентов. Халатное отношение к ее сбору приведет к появлению серьезных и даже фатальных проблем в продвижении. Вот лишь часть из них:

-

Недостаточная проработка глобальных направлений спроса;

-

Недостаточная проработка спроса внутри направления;

-

Пересечение и дублирование информации внутри сайта;

-

Привлечение нерелевантной аудитории;

-

«Захват» других областей рынка.

Все эти ошибки рано или поздно приведут к потере поискового трафика, сил, времени и денег. Мы уже ранее рассказывали о том, как правильно собирается семантическое ядро. Советуем ознакомиться с данным материалом.

2. Неправильное создание структуры

Наполнение сайта по принципу «разместим там, где будет место», является грубой ошибкой, исправить которую впоследствии будет крайне проблематично. Структура должна создаваться на этапе проектирования с учетом спроса, приоритетных направлений, сезонности, дальнейшего развития и других факторов. В противном случае, Вы столкнетесь с целым рядом сложностей, таких как:

-

Ограничения в дальнейшем развитии сайта;

-

Некорректное распределение ключевых слов;

-

Неправильное распределение «веса» внутри сайта;

-

Избыточное количество уровней вложенности;

-

-

Проблемы с индексацией сайта.

3. Неверное распределение ключевых слов

С точки зрения продвижения, каждая страница сайта должна быть оптимизирована под один или несколько похожих по смыслу ключевых слов. Решать к какому разделу будет отнесен тот или иной ключевик нужно не во время заполнения сайта, а еще на этапе его проектирования. Делается это для того, чтобы избежать логических ошибок и пересечений.

Если ключевые слова будут распределены неверно, Вы столкнетесь с такими сложностями, как:

-

Низкая конверсия;

-

Снижение шансов попадания в ТОП;

-

Путаница в выборе канонической страницы;

-

Присутствие в поиске не соответствующих посадочных страниц.

О том, как правильно распределить ключевые слова по сайту мы уже писали ранее.

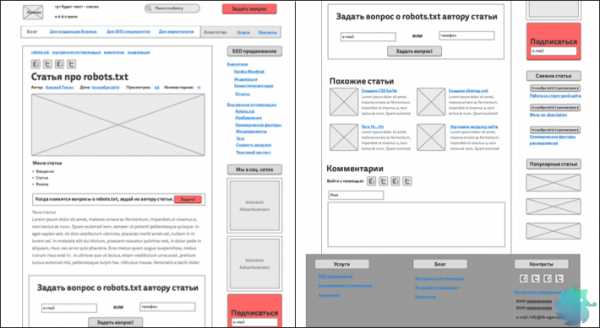

4. Непродуманные прототипы страниц

Перед тем, как приступить к отрисовке дизайна, добросовестные разработчики всегда создают прототипы страниц. Однако, в преимущественном большинстве случаев, они делаются для дизайнера и никак не учитывают требования SEO. С точки зрения поискового продвижения это некорректно.

То, что расположено на странице играет для SEO не менее важную роль, чем сам текстовой контент. Очень важно учитывать коммерческие и поведенческие факторы, продающие элементы и юзабилити. Если не заложить этого в прототипы перед отрисовкой дизайна, дорабатывать уже готовый сайт будет проблематично.

Ниже представлен пример прототипа для информационного ресурса, который учитывает не только дизайн, но и требования поискового маркетинга.

Ошибки на этапе создания сайта

1. Наличие дублей страниц

Одна из основных проблем возникающих в процессе индексации сайта — наличие дублей URL. Речь идет о ситуации, когда одна и та же страница доступна по двум или более адресам. С точки зрения продвижения это некорректно, так как роботу приходится скачивать несколько раз один и тот же контент, на что уходит драгоценное время.

Бороться с дублями, которые уже попали в индекс, достаточно проблематично, поэтому лучше исключить их на этапе создания сайта. Сделать это можно двумя способами.

Исключить появление. Большая часть дублей бесполезна и никак не влияет на работу сайта. К примеру, у ряда CMS, страницы по умолчанию могут быть доступны как по адресу example.ru/page.html, так и по адресу example.ru/page. Исправляется это путем настройки системы управления контентом.

-

Сразу запретить индексацию. Если избежать появление дублей невозможно, к примеру, в случае с параметрами в карточке товара, нужно сразу исключить подобные URL при помощи масок в файле robots.txt.

2. Низкая скорость загрузки сайта

Поисковые системы учитывают скорость загрузки сайта. Это далеко не самый основной фактор ранжирования, но от этого не менее важный.

Имея низкие показатели загрузки, Вы рискуете потерять существенную долю поискового трафика, так как по ряду запросов будите пессимизированы в выдаче.

Существует множество online инструментов способных проверить показатели загрузки Вашего ресурса. Один из них — https://gtmetrix.com. Довольно популярный сервис, который показывает не только ошибки, но и предлагает решения.

Прежде чем перейти к проверке убедитесь, что:

-

Все графические элементы дизайна и фото сжаты без потери качества;

-

Фактический размер изображений соответствует отображаемому на сайте;

-

Фотогалерея имеет миниатюры, а не сжимает большие изображения при помощи CSS;

-

Изображения небольшого размера объединены в CSS Sprite;

-

Видимые элементы сайта загружаются в первую очередь;

-

Все скрипты и каскадные таблицы стилей подгружаются минимальное количество раз;

-

Весь код, который подгружается, действительно используется;

Если все вышеперечисленное уже сделано, смело пользуйтесь gtmetrix и улучшайте свои показатели.

3. Некорректный вывод текстового контента

Некорректный вывод текстового контента является одной из самых распространенных проблем у сайтов с уникальным авторским дизайном. Мы ничего не имеем против необычных решений, но обращаем внимание, что они не должны влиять на корректность отображения текста. Необходимо найти компромисс между практическим применением и внешним видом.

Рассмотрим конкретные ошибки.

-

Весь текст (большая его часть) скрыты, и отображаются только после определенных действий пользователя;

-

Вывод текста осуществляется при помощи JS или других технологий, которые не позволяют загрузить его роботу;

-

Текст разбит на множество скрытых вкладок и элементов;

-

Текст представлен в виде графического изображения или анимации.

Ошибки на существующем сайте

1. Отсутствие meta тегов и заголовков

Полное отсутствие meta тегов и заголовков снижает эффективность поискового продвижения практически до нуля. Чтобы полноценно участвовать в поиске, каждая страница в обязательном порядке должна иметь:

Если <title></title>, обычно, заполняется CMS по умолчанию (к примеру, из первых строк текста или заголовка), то с description и другими тегами дела обстоят хуже. Их может не быть совсем.

Для проверки ошибок, в первую очередь, стоит обратиться к Яндекс Вебмастеру. В разделе «Диагностика сайта» показываются самые актуальные проблемы, в том числе отсутствие title и description.

Кроме этого, проверку возможно сделать вручную просто открыв исходный код сайта через браузер. Такой вариант подходит только для небольших сайтов. В случае с Интернет-магазинами и крупными проектами лучше использовать сервисы, вроде www.screamingfrog.co.uk. Это попросту сэкономит Ваше время и уменьшит шансы что-то пропустить.

2. Некорректные meta теги и заголовки

В отличии от ошибки описанной пунктом ранее, определить некорректно прописанные meta теги куда сложнее. В данном случае Яндекс Вебмастер и различного рода сервисы не помогут. Проблема распознается только вручную, путем подробного анализа и сопоставления имеющихся тегов с семантическим ядром.

Основные требования, которые должны быть соблюдены.

-

<title></title> — Должен содержать высокочастотный запрос (в рамках данной страницы). Быть легко читаемым и привлекающим внимание; (Подробные требования)

-

<meta name=»description» content=»»> — Должен содержать как высокочастотные, так и низкочастотные запросы (в рамках данной страницы). Полноценно описывать содержимое и быть полезным для пользователя. (Подробные требования)

-

<h2></h2> — Должен содержать высокочастотный запрос и кратко описывать суть статьи. Обязательно пишется для человека. (Подробные требования)

-

<h3>…</h6> — Должны содержать менее частотные запросы и описывать суть оглавляемого отрывка текста. (Подробные требования)

Ни в одном из вариантов не допустим поисковый СПАМ, то есть, излишнее вхождение ключевых слов или другие попытки повлиять на поисковую систему.

3. Неуникальный текстовой контент

Текстовой контент всегда являлся основным фактором ранжирования. В процессе развития поисковых систем к нему предъявлялись различные требования, но основа оставалась неизменной — текст должен быть уникальным. Сегодня это актуально как никогда.

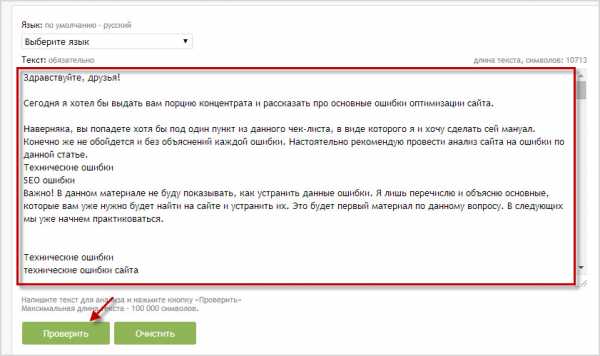

Для проверки уникальности существует множество инструментов, таких как https://content-watch.ru/text/. Процедура простая.

-

Добавляем статью;

-

В поле «Игнорировать» прописываем доменное имя нашего сайта;

-

Нажимаем «Проверить».

Показатель более 90% является нормой для большинства сайтов. Если уникальность менее 70%, то стоит задуматься о доработке статьи. Исключение составляют сложные технические тексты и карточки товаров, где добиться уникальности в 90% практически невозможно.

Ранее у нас уже была статья об анализе текстового контента. Советуем ознакомиться с ней.

Если Вы столкнулись с тем, что текстовой материал имеет низкую уникальность, советуем переписать статью заново, а не искать совпадающие отрывки и переформулировать их.

4. Бесполезный текстовой контент

Сегодня, для того, чтобы статья попала в ТОП, одной уникальности уже недостаточно. Материал должен быть полезным, актуальным, легко читаемым и полностью раскрывать освещаемую тему. Уже прошел не один год с момента, как поисковые системы научились отделять дешевый рерайт, от качественного копирайта. Но, к сожалению, до сих пор, множество коммерческих сайтов имеют массу никому ненужного текстового контента.

Чтобы определить, действительно ли статья полезна и интересна пользователю, придется работать с каждым материалом в отдельности. Вот основные вопросы, которыми Вы должны задаться перед тем, как приступить к написанию или анализу текста:

-

Для кого пишется статья?;

-

Какую проблему она решает?/На какой вопрос дает ответ?;

-

В чем отличие Вашей статьи от материалов конкурентов?

-

Полностью ли освещена тема?

-

Легко ли преподнесен материал?

- Есть ли признаки поискового СПАМа?

Каждая статья внутри сайта должна быть уникальна в своем роде и не пересекаться по смыслу с другими. Старайтесь как можно подробнее раскрывать тему. Пишите то, что действительно важно людям. Только полезный контент позволит занимать ТОПовые позиции.

5. Неправильная перелинковка

Внутренняя перелинковка нужна как пользователям так и поисковым системам. Первым она позволяет без труда серфить сайт и находить нужные материалы, вторым корректно индексировать и понимать распределение веса.

Перелинковка должна представлять из себя не хаотичный набор ссылок, а продуманную, основанную на спросе структуру. Ошибки приведут к некорректной индексации и негативным поведенческим факторам.

Правильная перелинковка должна отвечать ряду условий.

- На каждую страницу, которая имеется на сайте, должна быть ссылка. «Острова», на которые можно попасть только введя прямой адрес, недопустимы;

- Основные разделы должны быть доступны из сквозного меню;

- Всегда должна быть возможность вернуться на уровень выше;

- Не должно быть циклических ссылок. То есть, страниц, которые ссылаются сами на себя;

- Перелинковка не должна вводить пользователя в заблуждение;

Основная карта ссылок должна делаться еще на этапе проектирования, а в процессе заполнения сайта только дополняться.

6. Технические настройки

Помимо всего вышеперечисленного, существуют еще обязательные технические настройки, без которых поисковый робот не сможет корректно индексировать Ваш сайт.

-

Убедитесь, что все страницы сайта имеют корректные ответы сервера. (Подробнее о 404, 301, 302)

-

Проверьте правильность настройки файла robots.txt. (Подробнее…)

-

Создайте техническую карту сайта sitemap.xml (Подробнее…)

-

Корректно присвойте сайту регион (Подробнее…)

-

Переведите сайт на https (Подробнее…)

-

Сделайте для товаров микроразметку (Подробнее…)

dh-agency.ru

Распространенные ошибки оптимизации сайта

Здравствуйте, друзья!

Начинаю новую серию статей про ошибки в продвижении и первая из них будет про основные ошибки оптимизации сайта.

Наверняка, вы попадете хотя бы под один пункт из данного чек-листа, в виде которого я и хочу сделать сей мануал. Конечно же не обойдется и без объяснений каждой ошибки. Настоятельно рекомендую провести анализ сайта на ошибки по данной статье.

Важно! В данном материале не буду показывать, как устранить данные ошибки. Я лишь перечислю и объясню основные, которые вам уже нужно будет найти на сайте и устранить их. Это будет первый материал по данному вопросу. В следующих мы уже начнем практиковаться.

Технические ошибки

- Доступность сайта. Мало кто уделяет данному моменту должное внимание. Происходит ситуация, когда владелец сайта заходит на него иногда и видит, что ресурс в строю. Но если поставить мониторинг доступности сайта, то можно увидеть, что показатели работы сайта не совпадают с тем, что мы замечаем.Очень часто сайт может быть недоступным по пару минут в день, а в месяц уже накапливается достаточно большое количество времени его неработоспособности, а ведь в данный промежуток времени мог зайти робот поисковых систем и собрать нежелательную статистику. Тогда сайт может понижаться в поисковой выдаче. Также это касается и показа рекламы на сайте. Если из 30ти дней 1-2 дня сайт недоступен, то мы можем терять часть прибыли с него.

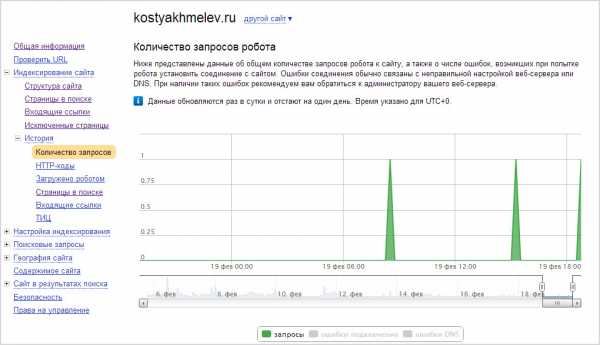

В сервиса Яндекс.Вебмастер можно отслеживать статистику запросов робота и наличие ошибок при соединении с сервером сайта.

Доступность сайта также можно отслеживать с помощью сервиса ping-admin, который часто делает запросы к сайту и можно видеть детальную статистику о работе сайта. К тому же, если не изменяет память, в нем можно реализовать оповещение о недоступности сайта на мобильный номер;

- Дубликаты страниц. Один из важнейших моментов, когда один и тот же контент доступен по разным адресам. Обязательно нужно проверять сайт на ошибки данного характера. Вы можете и не создавать такие страницы сами. Но они могут создаваться автоматически различными лишними ссылками движка, если неправильно настроена оптимизация сайта.На движке WordPress это могут быть ссылки "Ответить" в комментариях. Часто появляются дубли страниц комментариев. Чтобы таких страниц не было, всегда старайтесь избавиться от лишних и ненужных ссылок с сайта, которые могут посодействовать появлению дублей страниц;

- Ошибки отклика от сервера. Ошибка связана со слабым хостингом или его слабым тарифом, когда сервер не справляется с нагрузкой на сайт и ресурс становится недоступным. По началу, когда сайт только создался, эта проблема не будет заметна, так как нагрузки на него не будет.Но, когда в один момент на сайт будут заходить сразу 100 человек, то сервер просто не выдержит, страницы не будут грузиться и посетители на сайт не зайдут. В данном случае мы обращаемся к хостингу и повышаем тариф. Если ресурс сильно посещаем, то придется переезжать на выделенный сервер;

- Наличие ошибок 404, 50*.

На вашем ресурсе не должно быть ошибок, которые отдают ответ сервера 404, когда страницы не существует или же различные ошибки 501, 502 и так далее, когда страницы не грузятся из-за большего времени ожидания или же из-за ее недоступности в данный момент времени.

Такие документы обязательно анализируем и устраняем проблемы;

- Циклические ссылки. На сайте не должно быть ссылок страниц, которые ведут на самих себя. То есть, если я сейчас нахожусь на странице "Об авторе", то на данной странице я не должен иметь возможности перейти на эту же страницу. Можете посмотреть в моем главном меню.Тоже самое касается и ссылок в тексте. У многих внутри статьи имеется кликабельный заголовок статьи, являющийся ссылкой на эту же страницу. Также часто внутри статьи используют изображения, которые тоже являются ссылкой на данный материал. Такие ссылки называются циклическими и их не должно быть;

- Глубина сайта не больше 2х, в редких случаях 3. Старайтесь, чтобы глубина вложенности ресурса была максимум 2го. То есть, главная страница - 0 уровень, рубрика - 1й, статья - 2й.Могут быть еще и подрубрики, тогда глубина сайта будет 3. Это также допустимо, но старайтесь не использовать глубину 3го уровня, так как это затрудняет индексирование таких страниц поисковым роботам;

- Наличие страниц с низкой скоростью загрузки. Выявляем такие страницы и анализируем на причины низкой скорости. Это могут быть не оптимизированные изображения большого размера, ошибки в коде страницы и так далее.Если не знаете, как ускорить загрузку сайта, то прочтите материал по предыдущей ссылке;

- 30% контента в соотношении к коду страницы. В большинстве случаев, веб-мастера использую такие навороченные шаблоны, в которых куча ненужного кода или его просто слишком много. таком обилии кода контент просто теряется и это плохо с точки зрения технической оптимизации.Стараемся придерживаться минимум в 30% контента из всех 100% исходного кода страницы. Если добьетесь показателя в 50%-60%, то вообще супер;

- Наличие непроиндексированных страниц. Обязательно проверяем их на причины отсутствия в индексе, так как на них могут быть технические ошибки. Также это могут быть страницы с низким качеством контента или вообще копипаст, который рано или поздно может выпасть из индекса.

SEO ошибки

- 95% страниц, загруженных роботом, должны находится в индексе. Частый случай, когда много страниц были загружены роботом, но в поисковый индекс не попали. Стоит находить такие страницы и анализировать их.Причиной может быть сам контент, наличие ошибок на странице. Такая проблема случается и со старыми страницами сайта, которую уже кучу раз скопировали на другие ресурсы, она потеряла свою уникальность и выпала из индекса. Можно переписать текст. Много вы от этого не потеряете, но зато будет полноценная индексация проекта;

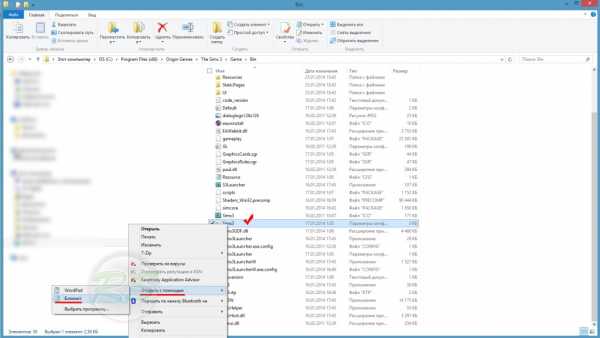

- Обязательное должен присутствовать файл robots.txt, в котором прописаны директивы для всех поисковых роботом (яндекс, google, mail, а также рекламные роботы адсена и яндекс директа).

Если у вас ресурс на движке WordPress, то настоятельно рекомендую проштудировать мой материал про файл robots.txt для WordPress;

- Обязательно наличие карты сайта Sitemap.xml для поисковых роботов, а также рекомендуемое наличие html карты для людей.HTML карта должна быть открыта для индексации на всех страницах сайта;

- Отсутствие заголовков и подзаголовков. На каждой странице сайта должен быть заголовок h2 и подзаголовки (хотя бы h3). Если таких заголовков нет, то переделывайте страницы, так как это спорный момент. Что это за страница, если на ней нет заголовков?h2 должен быть в обязательном порядке и содержать в себе название страницы. А h3-H6 используются для структурирования контента;

- Переспам страницы тегом strong. В своих статьях я уже писал, что данный тег стоит использовать лишь для выделения ключевых мыслей статьи для акцентирования на них внимания посетителей. Можно сделать вывод, что много данного тега на странице быть не должно, а уж тем боле выделений ключевых слов или отдельных фраз.Старайтесь употреблять данный тег 1 раз на 2000 символов и выделять лишь целые предложения с ключевыми мыслями. Никаких выделений "для галочки" и употребления более 10 раз на странице;

- Отсутствие или повторяющиеся мета-теги (title, description, keywords). Даже, если это служебные страницы или рубрики, вы все равно должны прописать к ним все мета-теги.Также должно отсутствовать дублирование мета-тегов, например один и тот же заголовок для разных страниц. Когда такая проблема будет у вас, то в google веб-мастере вы будете получать уведомления об этом в соответствующем разделе;

- Исключены нужные страницы в файле robots.txt. Если вы закрываете какие-то страницы в данном файле, то обязательно просматривайте через инструменты веб-мастеров, те ли страницы исключены, так как из индекса могут выпасть нужные страницы.

У меня, например, вот недавно выпала одна статья из индекса, так как в файле роботса было прописано правило, которое содержало слово, содержащееся в URL адресе статьи. Повезло, что я быстро среагировал на данную проблему и изменил свой файл.

- Выявление внешних ссылок с сайта. Также распространенная ошибка, когда с сайта ведет большое количество ссылок на другие сайты, а тем более на некачественные ресурсы. Такие ссылки стоит убирать.Еще стоит выявлять внешние линки, чтобы убрать их из шаблона. Если вы используете бесплатную тему, то имеется вероятность, что в него вшиты такие ссылки, ведущие, например, на сайт разработчика. И конечно же, при взломе сайта могут наставить много ссылок внутри материалов;

- Проверка длины мета-тегов TDK (title, description, keywords). Мало кто соблюдает необходимую дину данных тегов при оптимизации страниц;

- title - 60-75 символов;

- description - 160 символов;

- keywords - длина может быть и большой (относительно) и маленькой. Все зависит от частотности ключа, но не старайтесь впихнуть "как можно больше". Только то, что нужно для конкретной страницы.

- Отсутствие выделений жирным с помощью тега strong. На каждой странице мы должны делать акцент на ключевых мыслях, чтобы помочь посетителю. Если имеются страницы без таких выделений, то постарайтесь их доработать.Кроме тега strong можно использовать тег em (курсив), который также несет смысловую нагрузку поисковым системам;

- Совпадение плотности ключевых слов в тегах.Приведу пример. Например, мы используем ключевое слово в теге title, что очень уместно и логично, а затем в самом тексте статьи выделяем эти же ключевые слова в теге strong (или другим смысловым тегом, например em). Это уж явный знак, что мы пытаемся повысить плотностью ключа и акцентировать на нем внимание. Такого делать нельзя;

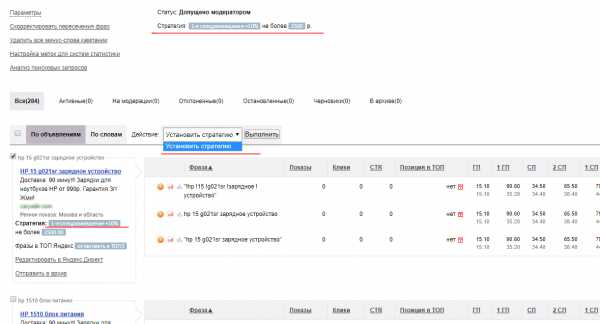

- Спам по слову не более 4%. Распространенная ошибка на большинстве сайтов, когда на каждой странице определенное слово имеет показатель плотности более 4%. Во-первых, текст становится менее читаемый и более водянистым. Во-вторых, не за горами вас настигнут санкции за переоптимизацию.Кстати, 4% - это показатель по странице в целом. Сюда берутся в учет слова с рубрик, различных меню и так далее. Если брать показатель по тексту статьи, то это не более 3%.Показатель плотности слов по тексту я обычно проверяю с помощью онлайн сервиса от Advego по данной ссылке. Переходим, вводим весь текст в поле и проверяем. В пример беру данную статью.

Как видите, максимальная плотностью слова составляет 3.01 процента. Это можно учесть за норму. Если бы было в пределах 3.5, тогда пришлось бы форматировать текст.

Конечно же это не полный список ошибок, который можно анализировать. Но я перечислил те, которые необходимо проверить в первую очередь.

В комментариях отпишите, пожалуйста, какие ошибки вашего ресурса вы уже можете назвать без проверки. Такие имеются?

Статьи про ошибки оптимизации сайта и ошибки в продвижении я буду продолжать писать и на очереди статья про аудит сайта на ошибки, в которой я покажу, как проанализировать все недочеты проекта с помощью онлайн сервиса.

На этом я прощаюсь и в заключение даю видео по теме.

Пока.С уважением, Константин Хмелев!

P.S. Не забываем оценивать материал с помощью звездочек ниже, а также своими комментариями. Ну и социальные кнопки само собой)

kostyakhmelev.ru

Технические ошибки оптимизации сайтов - РодинаЛинков.ру продвижение сайта статьями с вечными ссылками +

Порой одна чисто техническая ошибка может затормозить продвижение сайта. Какие-то недочеты мешают поисковым роботам оперативно индексировать страницы сайта, другие открывают злоумышленникам доступ к уязвимостям движка, а третьи и вовсе могут оказывать в будущем существенное влияние на позиции сайта. Какие ошибки нужно исправить в первую очередь? И как их исправить?

Домен доступен по разным адресам

Если на сайт можно зайти по разным адресам, к примеру, с www и без www, и эти адреса не склеены, то появляется проблема дублированного контента. Пауки поисковых систем посчитают, что контент, расположенный по одному из адресов – это плагиат, и скроют эти страницы в дополнительных результатах поиска. Не факт, что поисковики учтут предпочтения владельца сайта и посчитают дублем нужный ему адрес. Во избежание такой проблемы, нужно заранее склеить зеркала сайта.

Как найти ошибку?

Попробуйте ввести в адресной строке браузера адрес сайта с www. и без www. Если вы можете свободно зайти на сайт по двум адресам, а в файле robots.txt нет директивы Host, значит, вы не определили основной домен для продвижения.

Работа над ошибками

В файле robots.txt добавьте директиву Host и обозначьте основной домен.

User-Agent: Yandex

Host: www.moj-domen.ru

В данном случае домен www.moj-domen.ru будет основным.

Не забудьте поставить 301 редирект, перенаправляющий с неосновного домена на основной. Если кто-то наберет в браузере http://moj-domen.ru/articles/, то редирект автоматически переправит пользователя на страницу http://www.moj-domen.ru/articles/.

Главная страница доступна по разным адресам

Главная страница сайта должна быть «прописана» только по одному адресу http://www.moj-domen.ru/. Но в интернете, как и в жизни, встречаются «временные регистрации» и не до конца оформленные «гражданства», когда главная страница сайта доступна, скажем, по адресу http://www.moj-domen.ru/index.php. Чем это опасно? Появляется дублированный контент, а он при удачном стечении нескольких обстоятельств может привести к падению позиций сайта.

Как найти ошибку?

Ввести в браузер адрес с index.php и с index.html на конце, например,

http://www.moj-domen.ru/index.php

Если страничка открывается и по другому адресу и редиректа на основной домен не наблюдается, то на лицо – явная ошибка «морды» сайта.

Еще один способ поиска дублей главной страницы – ввод ее TITLE в кавычках в поисковой строке Яндекса или Google. Попробуйте, может быть, результаты выдачи вас и удивят.

Работа над ошибками

На помощь придет не заменимый 301 редирект.

Удалите в панели вебмастера Google все дубли, участсвующие в поиске. дублей на основной домен, либо отдавать 404-ую ошибку (страницы не существуют). Если на хостинге установлен apache и mod_rewrite, то пропишите редирект вот так:

RewriteEngine On

RewriteCond %{REQUEST_URI} ^/index\.(.+)$

RewriteRule ^.*$ http://%{HTTP_HOST}/ [R=301,L]

Уровень вложенности страниц слишком большой

Ошибка возникает из-за неправильной организации работы CMS, нехватки модулей. При индексации контента поисковые роботы отдают одним страничкам больший приоритет, а другим меньший. На страницы, расположенные в 3-4 кликах от главной, они заходят реже. Логика в этом есть: у этих страниц самая низкая вероятность посещения пользователями, для посетителей они менее актуальны. Обновившийся на таких страницах контент может переиндиксироваться очень и очень не скоро.

Как найти ошибку?

Выявить страницы с большим уровнем вложенности можно с помощью бесплатного инструмента Xenu Link Sleuth.

Работа над ошибками

Старайтесь не допускать на сайте глубоких разделов. Если избежать этого нельзя, усиливайте перелинковку. Вам поможет html карта сайта, облако ключевых слов, древовидное меню, раздел “похожие статьи”.

Несуществующие страницы отдают ошибку 200

При запросе несуществующего документа главная или любая другая страница с 200-ым кодом ошибки вместо 404-ого. Снова возникает угроза дублирования контента.

Как найти ошибку?

Введите в адресной строке браузера несуществующую страницу сайта, вроде такой:

http://yandex.ru/not/exists

Если в HTTP заголовках видна запись HTTP/1.1 404 Not Found, то сайт отдает корректную ошибку 404. Если в заголовках фигурирует ошибка 200 или 304 (Not Modified), то пора это исправить.

Работа над ошибками

Сама ошибка 404 настраивается в файлах CMS. Если таких настроек нет, следует проверить файл .htaccess.

Другие распространенные ошибки оптимизации

В самом движке заложены ошибки

Движок может сам генерировать дубли, добавлять параметры сессий в URL-адреса, формировать неверный код ответа страниц, содержать ошибки в файле .htaccess.

Серверные логи имеют открытый доступ

Открытые логи сервера нагромождают поисковый индекс множеством бесполезных страниц, тем самым они подрывают доверие к сайту и снижают скорость индексации важной информации.

Скорость отдачи страниц очень низкая

С недавних пор скорость отдачи страницы пользователю пополнила список важных факторов ранжирования. Забота о гостях сайта внушает доверие к ресурсу.

Проводите полноценный аудит сайта перед продвижением, выявляйте и устраняйте технические ошибки. Успехов в оптимизации!

www.rodinalinkov.ru

Технические ошибки оптимизации сайтов — Devaka SEO Блог

Сайт дня: Интересный SEO blog SHAMAN’a о поисковой оптимизации и не только.

В данной статье затронут технический аспект оптимизации сайтов и основные недочеты, требующие исправления в первую очередь (см. также статью Основные ошибки поисковой оптимизации сайтов, где описаны общие ошибки оптимизации).

Результаты аудита большинства сайтов показывают, что многие вебмастера допускают одни и те же ошибки в техническом плане. Эти недочеты влияют на продвижение сайта по-разному, одни виды ошибок не позволяют поисковым роботам быстро индексировать страницы сайта, другие дают потенциальную уязвимость для конкурентов использовать эту техническую особенность для своих коварных целей, третьи же ошибки могут в последствии сыграть негативную роль в плане продвижения и позиций. Ниже описаны наиболее часто встречаемые технические недоработки и методы их исправления.

Доступность домена по разным адресам

Когда один и тот же ресурс доступен по разным URL-адресам, например, с префиксом www и без этого префикса, и при этом они не склеены между собой, возникает проблема дублированного контента. Поисковые роботы в данном случае могут посчитать, что по одному из адресов контент не уникален и поместить его в дополнительные результаты поиска. Не всегда выбранный поисковиком адрес дубля устраивает владельца сайта, поэтому следует избегать этой ошибки, склеивая между собой основной домен с неосновным зеркалом или со всеми алиасами домена.

Как проверить наличие ошибки?

Введите в адресную строку браузера адрес сайта с www. и без www. Если сайт доступен и в первом и во втором случае и при этом в файле robots.txt не прописана директива Host, тогда вы не выбрали основной домен для продвижения.

Как исправить ошибку?

Необходимо в файле robots.txt всех зеркал добавить директиву Host с указанием основного домена, например.

User-Agent: YandexHost: www.maindomain.ru

Где домен www.maindomain.ru (без http) является выбранным вами основным доменом. См. также статью о продвижении сайтов с помощью зеркал.

К тому же следует поставить 301 редирект с неосновного домена на основной. Таким образом, при вводе, например, адреса http://maindomain.ru/articles/ в браузер, пользователя должно редиректить на основной домен http://www.maindomain.ru/articles/.

Доступность главной страницы по разным адресам

Главная страница сайта должна быть доступна лишь по основному адресу http://www.maindomain.ru/. Если она доступна также и по другим адресам, например, http://www.maindomain.ru/index.php, то возникает ошибка дублированного контента, из-за которой возможно падение позиций сайта при удобном стечении обстоятельств (сочетании других факторов).

Как проверить наличие ошибки оптимизации?

Необходимо ввести в браузер адрес с index.php или index.html, например,

http://www.maindomain.ru/index.php

Если страница доступна и нет редиректа на основной домен, то ошибка существует. Также найти дубли главной страницы можно, введя в кавычках её TITLE в поиске Яндекса или Google, анализируя результаты выдачи.

Как исправить ошибку дублирования главной страницы?

Для исправления этой ошибки следует также использовать 301-ый редирект с дублей на основной домен, либо отдавать 404-ую ошибку (страницы не существуют). До этого следует из результатов поиска удалить все дубли (например, это делается с помощью панели для вебмастеров в Google). Редирект, при использовании apache и mod_rewrite, можно сделать следующими строками:

RewriteEngine OnRewriteCond %{REQUEST_URI} ^/index\.(.+)$RewriteRule ^.*$ http://%{HTTP_HOST}/ [R=301,L]

Большой уровень вложенности страниц

Не совсем технический аспект, но часто эта ошибка оптимизации возникает из-за неправильной работы CMS (нехватки каких-либо модулей).

При индексации контента сайта, поисковый робот ходит по внутренним ссылкам со страницы на страницу по определенному алгоритму и своему расписанию. Документ с большим уровнем вложенности (более 3-4, то есть те страницы, которые доступны в минимум 3-4 и более кликах по ссылкам от главной) поисковики дают минимальный приоритет, что означает, что до этих страниц очередь переиндексации может дойти не скоро и старый контент может оставаться в индексе поисковых систем месяцами или даже годами. Это логично, так как страницы с большим уровнем вложенности обычно менее приоритетны для пользователей и имеют низкую вероятность посещений, а соответственно, и малый статический вес (ничтожный по сравнению со страницами 2-3 уровня вложенности).

Как найти страницы на сайте с большим уровнем вложенности?

Для поиска таких страниц можно использовать бесплатный инструмент Xenu Link Sleuth, который также позволит найти и другие ошибки.

Как исправить ошибку больших уровней вложенности?

Следует не допускать на сайте наличие подобных страниц и разделов. Если их возникновение неизбежно, тогда используйте стандартные средства перелинковки: html карту сайта, облака ключевых слов, древовидное меню, разделы “похожие статьи” для статей и новостей и другие методы перелинковки.

Наличие несуществующих страниц

Известная ошибка, когда для несуществующих документов выдается главная (или другая) страница сайта с 200-ым кодом ошибки, а не с 404-ым. В данном случае, опять же, может возникнуть проблема дублированного контента.

Как определить наличие ошибки?

Ввести в адресную строку браузера любую несуществующую страницу анализируемого сайта, например,

http://yandex.ru/not/exists

Если в HTTP заголовках выдается HTTP/1.1 404 Not Found, то все нормально, сайт отдает 404-ую ошибку. Если же в заголовках присутствует 200 ошибка или 304-ая (Not Modified), то следует исправить этот недочет.

Как исправить ошибку?

Необходимо для несуществующих страниц выдавать соответствующий код, чтобы поисковый робот не добавлял их в индекс. Обычно это настраивается в используемой CMS. Если у вас нет таких настроек, тогда проверьте .htaccess файл или обратитесь к разработчикам вашей сисетмы управления контентом.

Другие технические ошибки оптимизации

Также существуют некоторые другие, менее популярные технические аспекты, которые не учитываются оптимизаторами или вебмастерами при продвижении сайтов. К ним относятся:

— Ошибки в движке сайтаФормирование дублей, добавление параметров сессий в URL-адреса, неверные коды ответов страниц, ошибки в .htaccess-файле.

— Открытые серверные логиУвеличивают количество неинформативных страниц в индексе поисковой системы, уменьшая доверие к сайту и скорость индексации важного контента.

— Низкая скорость отдачи страницСкорость отдачи страниц пользователю является одним из факторов ранжирования с недавнего времени. Чем больше вы заботитесь о пользователях, тем больше доверия получаете и от поисковых систем.

Анализируйте свои сайты самостоятельно или заказывайте аудит, выявляйте технические ошибки и устраняйте их. Успехов в оптимизации!

devaka.ru

Ошибки внутренней оптимизации

Ошибки внутренней оптимизации — явление очень частое. Вебмастера часто допускают ошибки, оптимизируя сайты под поисковые системы. Ошибки при внутренней оптимизации могут существенно снизить позиции сайтов при ранжировании поисковыми системами. По этой причине давайте рассмотрим наиболее часто допускаемые ошибки оптимизаторов, чтобы в будущем их не совершать.

Типичные ошибки внутренней оптимизации

Итак, наиболее частые ошибки, которые допускаются при внутренней оптимизации сайта:

1. Шапка сайта в виде картинки

Не следует использовать в качестве верхней части сайта (шапки) картинку во всю ширину страницы. В шапке сайта можно разместить ценные ключевые слова и фразы. При использовании графического заголовка ценное место пропадает впустую. По этой причине лучше, например, совместить в верхней части сайта логотип виде небольшой картинки и текстом указать ключевые слова.

2. Графическое меню навигации

При навигации в виде картинок поисковые не смогут распознать текст ссылки. При этом теряется дополнительное преимущество при ранжировании. Таким образом, с точки зрения поисковой оптимизации, на сайте рекомендуется избегать графического меню навигации.

3. Использование навигации с помощью скриптов

Следует знать, что поисковые системы не умеют распознавать скрипты. В случае навигации с помощью скриптов, ссылки поисковиками учитываться не будут.

4. Оптимизация страницы под неверные ключевые слова

Зачастую при оптимизации страницы оптимизатор допускает ошибки при подборе ключевых слов для конкретной страницы продвигаемого сайта. Ключевые слова должны быть релевантны странице.

5. Неверно прописываются заголовки и мета-теги на странице

Очень важно правильно указывать заголовки и мета-теги на странице. Заголовок h2 должен встречаться на странице только один раз, также стоит использовать заголовки h3, h4.

За название страницы отвечает тег «Title», который является одним из важных тегов. В названии страницы необходимо указывать ключевые слова, по которым идет раскрутка страницы. По сути, название страницы является в поисковой системе ссылкой для перехода посетителей на наш сайт. Поэтому, название страницы должно быть оформлено должным образом.

Мета-тег Description предназначен для описания страницы. Описание страницы должно быть кратким, отражать суть страницы. При составлении описания для страницы следует использовать ключевые слова, которые характерны для данной страницы.

Мета-тег Keywords был придуман для указания ключевых слов данной страницы. В настоящее время, он практически не учитывается поисковыми системами. Однако, «на всякий случай» данный тег лучше заполнять. При заполнении следует указывать слова, которые реально встречаются на странице.

6. Переоптимизация контента

При оптимизации страницы сайта не следует слишком часто повторять ключевые слова. Слишком частое использование ключевых слов на странице может привести к тому, что поисковая система применит к ней санкции.

Ключевые слова должны встречаться на странице, в среднем, 3−4 раза. Чем больше, тем лучше. Однако, не следует просто размещать ключевые слова друг за другом, это не даст никакого положительного эффекта, а лишь, наоборот, может быть воспринято поисковой системой, как попытка искусственного воздействия на результаты ранжирования. Для того, чтобы избежать соответствующих санкций от поисковых систем, лучше так не делать. Ключевые слова следует «разбавлять» текстом. Соответственно, чем больше у нас текста на странице, тем больше раз мы можем упомянуть на ней наше ключевое слово.

7. Использование скрытого текста и однопиксельных ссылок

Использование скрытого текста (текста, оформленного в таком стиле, что пользователь его не видит, например, белый шрифт текста на белом фоне), а также однопиксельных ссылок (их посетитель не видит) может привести к исключению сайта их индекса поисковой системы. Поэтому не стоит прибегать к «серым» методам раскрутки сайта. Рано или поздно поисковая система заменит это и примет соответствующие меры.

Вот, пожалуй, наиболее распространенные ошибки внутренней оптимизации сайта. Следует запомнить ошибки, которые допускают вебмастера при оптимизации своих сайтов, чтобы самим их не совершать. Правильная оптимизация — очень важный момент для вывода сайта в ТОП и, как следствие, успеха Вашего дела.

siteblogger.ru

Технические ошибки оптимизации сайтов | Creative Way Projects

В данной статье затронут технический аспект оптимизации сайтов и основные недочеты, требующие исправления в первую очередь (см. также статью Основные ошибки поисковой оптимизации сайтов, где описаны общие ошибки оптимизации).

Результаты аудита большинства сайтов показывают, что многие вебмастера допускают одни и те же ошибки в техническом плане. Эти недочеты влияют на продвижение сайта по-разному, одни виды ошибок не позволяют поисковым роботам быстро индексировать страницы сайта, другие дают потенциальную уязвимость для конкурентов использовать эту техническую особенность для своих коварных целей, третьи же ошибки могут в последствии сыграть негативную роль в плане продвижения и позиций. Ниже описаны наиболее часто встречаемые технические недоработки и методы их исправления.

Доступность домена по разным адресам

Когда один и тот же ресурс доступен по разным URL-адресам, например, с префиксом www и без этого префикса, и при этом они не склеены между собой, возникает проблема дублированного контента. Поисковые роботы в данном случае могут посчитать, что по одному из адресов контент не уникален и поместить его в дополнительные результаты поиска. Не всегда выбранный поисковиком адрес дубля устраивает владельца сайта, поэтому следует избегать этой ошибки, склеивая между собой основной домен с неосновным зеркалом или со всеми алиасами домена.

Как проверить наличие ошибки?

Введите в адресную строку браузера адрес сайта с www. и без www. Если сайт доступен и в первом и во втором случае и при этом в файле robots.txt не прописана директива Host, тогда вы не выбрали основной домен для продвижения.

Как исправить ошибку?

Необходимо в файле robots.txt всех зеркал добавить директиву Host с указанием основного домена, например.

User-Agent: Yandex Host: www.maindomain.ru

Где домен www.maindomain.ru (без http) является выбранным вами основным доменом. См. также статью о продвижении сайтов с помощью зеркал.

К тому же следует поставить 301 редирект с неосновного домена на основной. Таким образом, при вводе, например, адреса http://maindomain.ru/articles/ в браузер, пользователя должно редиректить на основной домен http ://www.maindomain.ru/articles/.

Доступность главной страницы по разным адресам

Главная страница сайта должна быть доступна лишь по основному адресу http://www.maindomain.ru/. Если она доступна также и по другим адресам, например, http://www.maindomam.ru/index.php, то возникает ошибка дублированного контента, из-за которой возможно падение позиций сайта при удобном стечении обстоятельств (сочетании других факторов).

Как проверить наличие ошибки оптимизации?

Необходимо ввести в браузер адрес с index.php или index.html, например, http ://www.maindomain.ru/index.php

Если страница доступна и нет редиректа на основной домен, то ошибка существует. Также найти дубли главной страницы можно, введя в кавычках её TITLE в поиске Яндекса или Google, анализируя результаты выдачи.

Как исправить ошибку дублирования главной страницы?

Для исправления этой ошибки следует также использовать 301-ый редирект с дублей на основной домен, либо отдавать 404-ую ошибку (страницы не существуют). До этого следует из результатов поиска удалить все дубли (например, это делается с помощью панели для вебмастеров в Google). Редирект, при использовании apache и mod_rewrite, можно сделать следующими строками:

RewriteEngine On

RewriteCond %{REQUEST_URI} A/index\.(.+)$

RewriteRule A.*$ http://%{HTTP_HOST}/ [R=301,L]

Большой уровень вложенности страниц

Не совсем технический аспект, но часто эта ошибка оптимизации возникает из-за неправильной работы CMS (нехватки каких-либо модулей).

При индексации контента сайта, поисковый робот ходит по внутренним ссылкам со страницы на страницу по определенному алгоритму и своему расписанию. Документ с большим уровнем вложенности (более 3-4, то есть те страницы, которые доступны в минимум 3-4 и более кликах по ссылкам от главной) поисковики дают минимальный приоритет, что означает, что до этих страниц очередь переиндексации может дойти не скоро и старый контент может оставаться в индексе поисковых систем месяцами или даже годами. Это логично, так как страницы с большим уровнем вложенности обычно менее приоритетны для пользователей и имеют низкую вероятность посещений, а соответственно, и малый статический вес (ничтожный по сравнению со страницами 2-3 уровня вложенности).

Как найти страницы на сайте с большим уровнем вложенности?

Для поиска таких страниц можно использовать бесплатный инструмент Хепи Link Sleuth, который также позволит найти и другие ошибки.

Как исправить ошибку больших уровней вложенности?

Следует не допускать на сайте наличие подобных страниц и разделов. Если их возникновение неизбежно, тогда используйте стандартные средства перелинковки: html карту сайта, облака ключевых слов, древовидное меню, разделы «похожие статьи» для статей и новостей и другие методы перелинковки.

Наличие несуществующих страниц

Известная ошибка, когда для несуществующих документов выдается главная (или другая) страница сайта с 200-ым кодом ошибки, а не с 404-ым. В данном случае, опять же, может возникнуть проблема дублированного контента.

Как определить наличие ошибки?

Ввести в адресную строку браузера любую несуществующую страницу анализируемого сайта, например, http://yandex.ru/not/exists

Если в HTTP заголовках выдается НТТР/1.1 404 Not Found, то все нормально, сайт отдает 404-ую ошибку. Если же в заголовках присутствует 200 ошибка или 304-ая (Not Modified), то следует исправить этот недочет.

Как исправить ошибку?

Необходимо для несуществующих страниц выдавать соответствующий код, чтобы поисковый робот не добавлял их в индекс. Обычно это настраивается в используемой CMS. Если у вас нет таких настроек, тогда проверьте .htaccess файл или обратитесь к разработчикам вашей сисетмы управления контентом.

Другие технические ошибки оптимизации

Также существуют некоторые другие, менее популярные технические аспекты, которые не учитываются оптимизаторами или вебмастерами при продвижении сайтов. К ним относятся:

— Ошибки в движке сайта

Формирование дублей, добавление параметров сессий в URL-адреса, неверные коды ответов страниц, ошибки в .htaccess-файле.

— Открытые серверные логи

Увеличивают количество неинформативных страниц в индексе поисковой системы, уменьшая доверие к сайту и скорость индексации важного контента.

— Низкая скорость отдачи страниц

Скорость отдачи страниц пользователю является одним из факторов ранжирования с недавнего времени. Чем больше вы заботитесь о пользователях, тем больше доверия получаете и от поисковых систем.

Анализируйте свои сайты самостоятельно или заказывайте аудит, выявляйте технические ошибки и устраняйте их. Успехов в оптимизации!

www.cwpro.ru

Основные ошибки при оптимизации сайта

Рассмотрим основные ошибки при SEO — оптимизации магазинов, созданных на платформе AndiPartners

Рассмотрим основные ошибки при SEO — оптимизации магазинов, созданных на платформе AndiPartners

1) Индексация проекта

Проект по умолчанию закрыт от индексации

Как правильно открыть сайт для индексации вы можете прочитать здесь

2) Оптимизация title и description

Содержимое этих тегов формируется по умолчанию одинаково. При массовом открытии проекта для индексации они в таком виде и попадают в поиск.

Поисковые системы требуют, чтобы title и description были уникальны во всей сети Интернет.

Самый простой выход из этой ситуации — добавление в шаблон title и description домен магазина с помощью переменной $shopName.

Более подробно о составлении шаблонов вы можете прочитать здесь.

3) Шаблонная оптимизация контента

При оптимизации текста шаблонным методом, зачастую можно встретить ситуацию, когда он составлен в подобном виде:

“Название Категории” или Купить футболки “Название Категории” в магазине “Название Магазина”

В этом случае, поисковая система скорее всего наложит на такой сайт фильтр из-за некачественного контента.

Необходимо максимально разнообразно и уникально писать текстовку, делая ее длиной, хотя бы, в 300-400 знаков.

В идеале на каждой категории должны быть полностью уникальные тексты. Для оптимизации товаров существует больше переменных. Поэтому их можно оптимизировать шаблонным методом и довольно качественно.

Какие именно переменные и для каких тегов можно использовать описано в нашей инструкции

4) Использование малого количества ключевых слов

В данной тематике очень много ключевых слов, которые необходимо использовать при оптимизации страницы: виды одежды, принадлежность к полу, размеры, цвета, тематика принта.

5) Актуализация контента

Необходимо, хотя бы, раз месяц проверять актуальность категорий и товаров. Так как, возможно, вы будете проставлять внутренние либо внешние ссылки. В итоге и пользователи, и роботы попадают на страницы с 404 ошибкой, что негативно оценивается поисковыми системами.

blog.andipartners.com