6 ошибок в продвижении сайта. Как найти ошибки по оптимизации сайта

6 ошибок в продвижении сайта

Ошибка 1: недооценивать поисковую оптимизацию

Аббревиатура SEO сейчас всё чаще воспринимается с оттенком неприятия, от знакомых айтишников я даже слышала слова «шарлатанство» и «обман». Виной тому нечистые на руку «специалисты», которые брали с доверчивых владельцев сайтов большие деньги, обещая вывести проект в топ, а потом просто ничего не делали или делали неправильно. Соответственно, владелец терял деньги, время, нервы и веру в поисковую оптимизацию.

На самом же деле SEO не то что полезная, а необходимая штука для вашего сайта. Безусловно, можно гнать трафик с помощью соцсетей и Telegram-ботов, но всё же основная масса пользователей приходит из поисковиков, и нужно уметь по максимуму использовать этот источник.

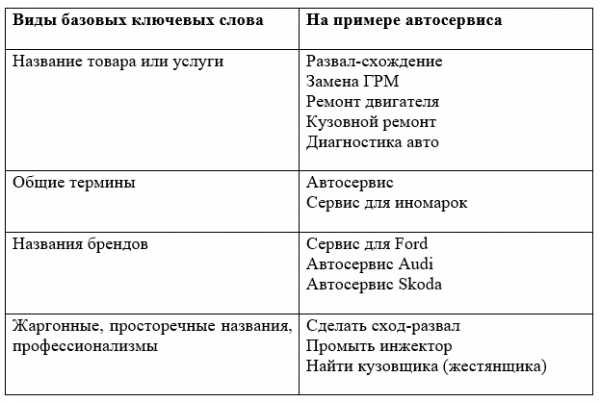

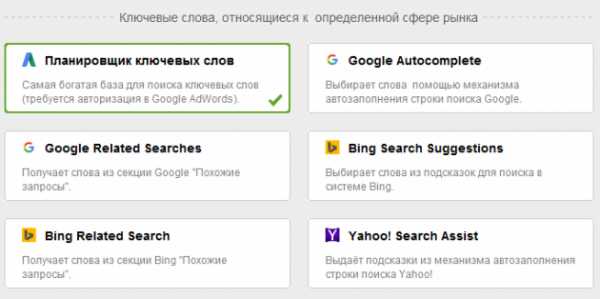

Первое, что стоит сделать, — определиться, по каким ключевым словам вы будете продвигать свой ресурс. Популярный сервис для этого — «Планировщик ключевых слов» из набора инструментов Google AdWords.

Можете немного облегчить себе жизнь и воспользоваться программой Rank Tracker. В ней представлены различные методы поиска ключевых слов: чтобы получить оптимальную выборку, стоит воспользоваться каждым из них. Rank Tracker показывает реальное количество запросов для каждого ключевого слова и уровень конкуренции по нему, а также рассчитывает индекс эффективности ключевых слов.

Ошибка 2: не следить за конкурентами

«Зачем мне знать что-то о конкурентах? У меня свой путь» Позиция гордая, но неумная. За конкурентами надо следить пристально и любыми возможными способами, а затем тщательно анализировать их действия.

Несомненно, глупо слепо копировать идеи соперников, важно понять, какие из них работают, а какие — нет и почему так происходит. Если вы видите идеи, которые и вы давно пытаетесь у себя внедрить, но они не работают ни у вас, ни у конкурентов, значит, надо от них безжалостно отказаться. А вот хорошо работающие идеи стоит активно применять у себя, но правильнее — оптимизировать и улучшить их, чтобы опередить конкурентов.

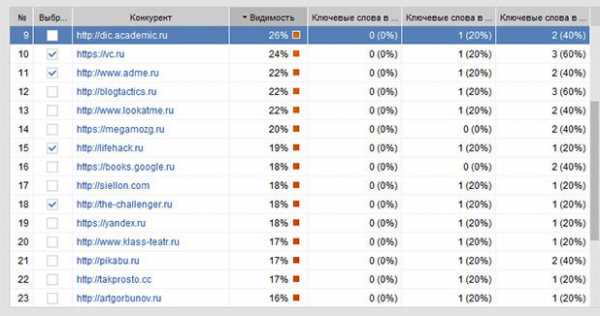

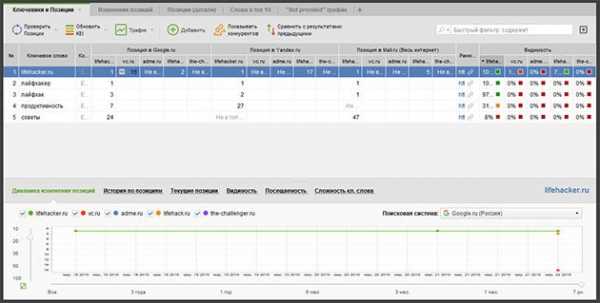

Найти конкурентов можно опять же при помощи программы Rank Tracker. Задаёте ключевые слова, по которым вы продвигаете свой сайт, и программа ищет для вас основных конкурентов. Вам остаётся только отметить галочками достойных и добавить их в проект.

Потом с помощью этой же программы можно отслеживать их позиции в поисковиках, смотреть, кто вырывается вперёд по каким словам.

Конечно, одного перечня позиций сайтов-конкурентов вам будет недостаточно. Необходимо эти ресурсы посетить, рассмотреть, понять, почему они выигрывают у вас по каким-то пунктам.

Ошибка 3: не заниматься внутренней оптимизацией сайта

Наш хитрый мозг всегда старается выбрать дорожки попроще, чтобы сделать всё быстро, легко, но обязательно с ошеломляющим результатом. Внутренняя оптимизация сайта — длительное и мало вдохновляющее занятие. Кому понравится часами копаться в коде, выискивая и исправляя мелкие ошибки?

Однако без внутренней оптимизации поисковое продвижение не имеет смысла. Это всё равно что выставлять на бега больную лошадь. Вы можете сколько угодно подстёгивать её, первой она всё равно не придёт.

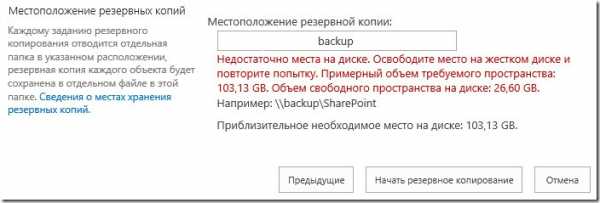

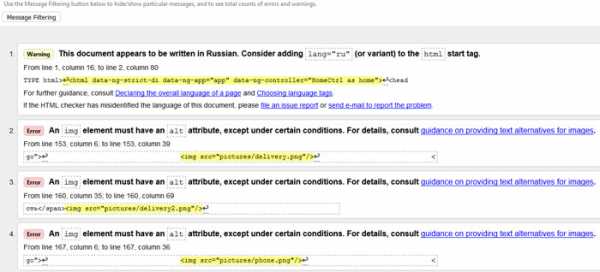

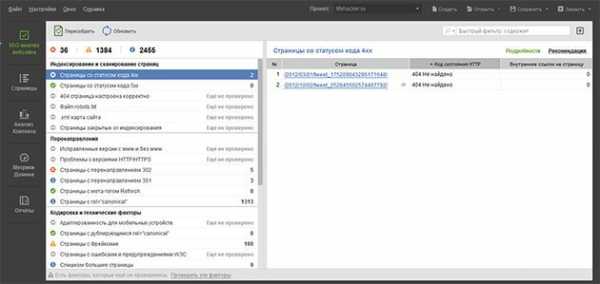

Начинайте с полного аудита сайта. И не пугайтесь этих слов. Аудит можно сделать при помощи программы WebSite Auditor. Введите название сайта, и можете пить кофе с плюшками, пока программа готовит полный отчёт по вашему сайту:

- структурные недостатки, снижающие рейтинг: битые ссылки, ошибки в HTML-коде, ошибки сервера и так далее;

- дублирующийся контент в заголовках, метаописаниях и других HTML-элементах страниц.

Дальше дело за вами или за нанятым вами веб-мастером, который поможет исправить найденные недочёты.

Ошибка 4: не уделять должного внимания контенту

Мы сейчас говорим не о насыщении контента ключевыми словами, хотя и это по-прежнему необходимо для успешного поискового продвижения. Но всё же главное — наполнение вашего сайта должно быть интересно и полезно пользователю. Статьи должны побуждать людей возвращаться вновь и вновь и делиться вашими публикациями в соцсетях и на других ресурсах.

Поэтому забудьте о воровстве и штамповке скучных статей. Если у вас нет времени, желания или умения писать самостоятельно, наймите хороших авторов.

Предчувствую возражения: «Но у меня интернет-магазин (сайт клиники, автомастерской — подставьте нужное), какие статьи и зачем я буду там размещать?» Помните: любому предприятию будет полезен корпоративный блог. Пишите о своих новостях, новостях индустрии и просто на смежные темы.

Ошибка 5: не уделять внимания юзабилити

Вы наверняка и сами встречали такие странички, с которых хочется поскорее убежать, там совершенно непонятно, как что-то найти и сделать. Часто этим грешат ресурсы госструктур. Не одна тысяча нервных клеток погибает во время попыток заполнить какое-нибудь заявление. Ощущение, что создатели сайта сделали всё возможное, чтобы усложнить использование своего детища и не допустить роста аудитории.

Но у вас-то ситуация обратная: нужно, чтобы пользователи возвращались снова и снова. А для этого проявите к ним уважение, сделайте сайт красивым, понятным и удобным.

Анализировать юзабилити сайта можно при помощи «Яндекс.Метрики» и Google Analytics. Это отдельный и серьёзный пласт знаний, недаром так ценятся грамотные аналитики. Впрочем, имея багаж в виде пытливого ума и усидчивости, вы можете и самостоятельно сделать выводы о юзабилити проекта.

Ошибка 6: пренебрежительно относиться к входящим ссылкам

Входящие ссылки — один из важных факторов, влияющих на ранжирование сайта в поисковой выдаче. Количество входящих ссылок расценивается как свидетельство качества. Некачественные внешние ссылки могут серьёзно ухудшить позиции сайта.

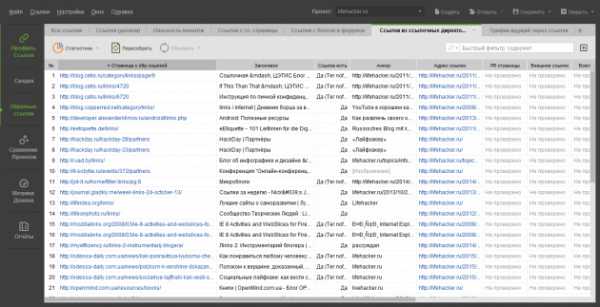

Старайтесь не только проверять, кто ссылается на ваш сайт, но и подбирать новые качественные ресурсы для размещения ссылок. Всё это можно сделать при помощи программы SEO SpyGlass. Для начала проведите анализ ссылочного профиля для своего проекта, займитесь удалением сомнительных ссылок, попробуйте добавить ссылок на качественные ресурсы. Затем проанализируйте ссылочный профиль конкурентов: скорее всего, вы отыщете ещё пару ресурсов, на которых неплохо бы разместить ссылки на ваш сайт.

В SEO SpyGlass есть планировщик задач, в котором можно настроить автоматические регулярные проверки. Очень удобно, когда к началу рабочего дня у вас уже готов отчёт.

У всех перечисленных выше инструментов есть бесплатные версии, так что вы можете сразу опробовать их. Уверена, вы узнаете много интересного о своём ресурсе.

Хочу проанализировать свой сайт

lifehacker.ru

9 популярных ошибок любого сайта. Или почему не растут позиции.

Поисковая оптимизация – большая работа над множеством различных факторов. Дизайн, техническая составляющая, контент. Даже незначительные на первый взгляд детали очень важны для продвижения. О самых частых ошибках в дизайне сайта мы уже говорили. Сегодня разберем 9 фатальных SEO ошибок, способных «угробить» любой сайт.

Как минимум, раз в неделю рекомендую заглядывать в вебмастера Яндекс и Google для проверки наличия санкций. В Яндексе это можно сделать в разделе Диагностика → Безопасность и нарушения. В Google – Поисковый трафик → Меры, принятые вручную.

Как показывает наша практика, чаще всего владельцы сайтов даже не догадываются о наложенных ограничениях. Недавний пример из нашей работы:

Большое количество чужих текстов на сайте и открытые исходящие ссылки. Результат на скриншоте.

До снятия всех ограничений дальнейшего смысла заниматься продвижением нет. Исправляем все ошибки, сообщаем поисковой системе и ждем снятия санкций.

Мы постоянно говорим о том, как важны тексты. Контент – это то, зачем пользователи заходят на сайты. Неуникальный и неинтересный контент никому не нужен. Поисковые системы занижают подобные ресурсы в выдаче, а клиенты устали читать одни и те же шаблонные тексты на сотне сайтов. Пруф того, что за контент можно вылететь с хороших позиций, тут.

Проверяйте уникальность текстов перед размещением на text.ru.

Как писать тексты, на какие страницы и в целом, о контенте, много написано в нашем блоге. Вот хорошая подборка статей от нашего копирайтера Дарьи.

Основа SEO-продвижения – правильно подобранные ключевые слова. Это очень важный фактор в оценке релевантности вашего сайта поисковому запросу.

Чаще всего мы сталкиваемся с двумя ошибками. Полное отсутствие ключевых слов в тегах:

Тег Title должен быть заполнен в виде связного предложения с включением ключевых слов.

Либо переспам ключами в заголовках:

Важно найти золотую середину. Теги должны быть полезными не только для поисковых роботов, но и для обычных людей. Не забывайте об информативности. Как правильно писать теги title, description и заголовки h2, хорошо рассказывает наш копирайтер Екатерина в своей статье.

C января 2017 года браузер Google Chrome (начиная с 56 версии) начал помечать все HTTP-сайты, содержащие любые формы, передающие личные данные пользователей (email, пароли, данные кредитных карт и т.п.) как «небезопасные». Также наличие SSL сертификата является небольшим импульсом в ранжировании в Google.

Всем интернет-магазинам в первую очередь следует перейти на протокол https. При этом очень важно соблюсти правильный алгоритм действий.

Самая частая ошибка – просто настроить 301-редирект со старой версии http на https после покупки SSL-сертификата. Владельцы сайтов забывают о файле robots.txt, директиве Host, настройке вебмастеров. Сайт с http выпадает из индекса, новый сайт на https еще не проиндексирован. Все позиции моментально улетают в трубу.

В нашем Блоге есть подробная инструкция, как правильно перенести сайт с http на https. Если останутся вопросы, пишите нам, обязательно поможем.

Текстовый файл, размещенный на сайте и предназначенный для роботов поисковых систем. В этом файле следует указать параметры индексирования своего сайта для поисковых роботов.

Иногда файл robots.txt отсутствует вовсе.

Свежий пример из нашей работы. Интернет-магазин станков, работы проводились в рамках услуги поисковое продвижение сайта. Сайт был полностью открыт для индексации поисковым роботам и вовсе не имел файл robots.txt.

Настроили ему robots, теперь все в порядке:

Что конкретно мы сделали?

Закрыли от индексации админ панель сайта, служебные страницы 404 и 403, страницу поиска, корзину. Указали адрес карты сайта, настроили директиву Host.

Вместе с остальными работами по оптимизации это помогло достичь следующих результатов:

Еще одна серьезная ошибка – сайт полностью закрыт от индексации. За это отвечают директивы Disallow и Allow, которые запрещают или разрешают индексирование разделов, отдельных страниц сайта или файлов соответственно. Для проверки файла у поисковых систем есть специальные инструменты: Яндекс и Google.

Проверьте, что у вашего сайта имеется файл robots.txt и заполнен он корректно. От индексации следует закрывать все служебные страницы, страницы поиска и фильтров. Страницы дублей, регистрации, авторизации. Корзину и страницу оформления заказа для интернет-магазинов. Подробнее о robots.txt.

Дублированный контент или просто дубли – это страницы на вашем сайте, которые полностью (четкие дубли) или частично (нечеткие дубли) совпадают друг с другом, но каждая из них имеет свой URL.

Одна страница может иметь как один, так и несколько дублей:

Поисковые роботы отрицательно относятся к дублированному контенту и могут понизить позиции в выдаче из-за отсутствия уникальности, а следовательно, и полезности для клиента. Нет смысла читать одно и то же на разных страницах сайта.

Может измениться релевантная страница. Робот может выбрать для выдачи дублированную страницу, если посчитает ее содержание более релевантным запросу. Сайт потеряет позиции и просядет в выдаче. В 90% случаев дубли мешают продвижению, и после их устранения позиции сайта улучшаются.

Как найти и убрать дубли на сайте, рассказываем в данной статье.

Зеркалами считаются сайты, являющиеся полными копиями друг друга, доступные по разным адресам. Все зеркала сайта важно склеить через 301 редирект.

Показатели тИЦ, вес внешних ссылок не должны растекаться, а они будут, т.к. поисковики считают разными ресурсами сайты, расположенные по разным адресам. Возможна подмена релевантной страницы в поисковой выдаче, дублирование контента. 100% мешает росту сайта в выдаче.

Сайт не должен открываться по разным адресам, с www и без www, просто site.ru и site.ru/index.php, по http и https и т.д.:

Чек-лист для проверки:

- Сайт должен быть доступен только по одному протоколу http или https.

- Выбрано главное зеркало сайта, с www или без www, указано в Вебмастере.

- Настроен 301 редирект со всех зеркал.

- Главная страница сайта доступна по одному адресу, без /index.php, /index.html и т.п.

100% Must-have для всех сайтов в 2017 году. Сегодня рост мобильного трафика опережает компьютерный. Число пользователей, использующих смартфоны для совершения покупок, в мире растет с каждым днем. Алгоритмы поисковых систем учитывают адаптивность при ранжировании сайта в мобильной выдаче.

Google уже с 2015 года использует алгоритм Google mobile-friendly.

Яндекс год назад запустил алгоритм Владивосток.

Если ваш сайт все еще не адаптирован под мобильные устройства – каждый день вы теряете до половины своих клиентов. Подробнее о том, зачем нужна оптимизация.

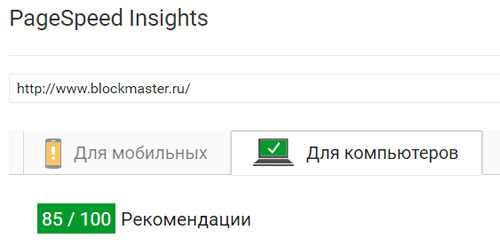

Тут все просто. Пользователям не нравятся медленные сайты. Поисковые системы так же отдают предпочтение быстрым, оптимизированным сайтам. Проверить скорость загрузки своего сайта можно с помощью инструмента Google. Красный – медленно, важно срочно увеличивать скорость, желтый – нормально, но можно оптимизировать, зеленый – отлично.

Разберем на конкретном примере

Помните, в начале статьи мы упоминали интернет-магазин станков. Что мы исправили из фатальных ошибок:

- Неуникальный контент

Написали хороший продающий, уникальный текст на главную страницу сайта.

До проведения работ:

После оптимизации:

- Ошибки оптимизации

Скорректировали теги title и description, заголовки h2.

До проведения работ:

После оптимизации:

- Отсутствие файла robots.txt

Создали и настроили файл robots.txt. Сейчас сайт правильно индексируется поисковыми системами. До этого, как писали выше, данного файла не было на сайте вовсе.

- Наличие не склеенных зеркал

Склеили зеркала сайта. Сайт был доступен по двум адресам с www и без.

- Некорректный ответ сервера для несуществующих страниц

Создали отдельную страницу 404 и настроили правильный ответ сервера для несуществующих страниц.

До выполнения работ несуществующие страницы через 302 редирект перенаправляли пользователя на главную страницу сайта.

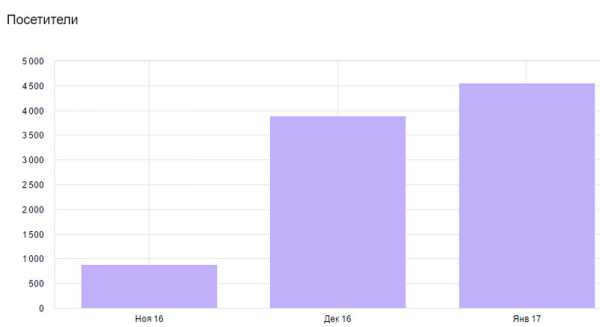

Результаты:

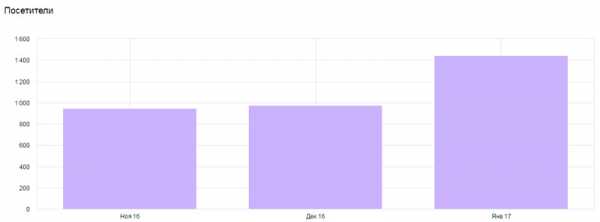

Положительная динамика роста посещаемости из поисковых систем:

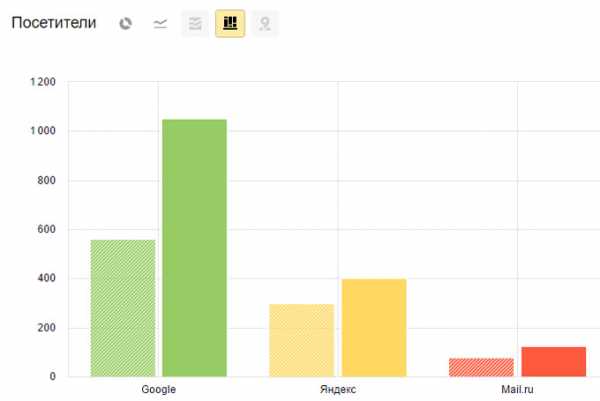

Трафик из Google вырос в два раза:

Результат за 3 месяца:

+8 запросов у Яндекса, +6 у Google в топ-5

+19 запросов у Яндекса, +9 у Google в топ-10

+25 запросов у Яндекса, +11 у Google в топ-20

+14 запросов у Яндекса, +4 у Google в топ-50

Посмотреть позиции до и после »

Хотите так же? Проверьте, может данные ошибки есть и на вашем сайте. Если нет времени и желания разбираться, заказывайте поисковое продвижение у нас, с радостью поможем.

1ps.ru

Как найти ошибки на сайте? Полная проверка сайта на ошибки

SEOTO.ME - сервис для мониторинга сайта и выявлении ошибок, который могут отрицательно влиять на продвижение.

Разработчик сервиса SEOTO.ME - он же разработчик известного программного обеспечения для seo-оптимизатора CSYazzle , так же других известных сервисов, таких как SeoBudget, CS Sape Master, DriveLink.

Возможности сервиса seoto.me

- Работа из личного аккаунта с данными Яндекс.Вебмастер;

- Поиск нерабочих (битых) ссылок и картинок, а так же частичных и полных дублей страниц;

- Проверка кода страницы на ошибки, включая такие теги как title и заголовки h2-H6;

- SEO аудит и анализ сайта, анализ структуры сайта;

- Настройка XML карты и расчет внутреннего веса страницы

- и другие полезные функции, о которых Вы узнаете после регистрации.

Регистрация и добавление сайта в SEOTO.ME

Зарегистрироваться в SEOTO.ME удается достаточно быстро, Вы вводите свой email и пароль, который будете использовать для входа в аккаунт. После получаете письмо на email, с ссылкой для подтверждения регистрации и активации аккаунта. На страницы входа вводите свои email и пароль, после чего попадаете в личный кабинет.

В личном кабинете в верхней панели - меню мы видим основные вкладки - это "Создать проект", "Яндекс.Вебмастер" и быстрая проверка.

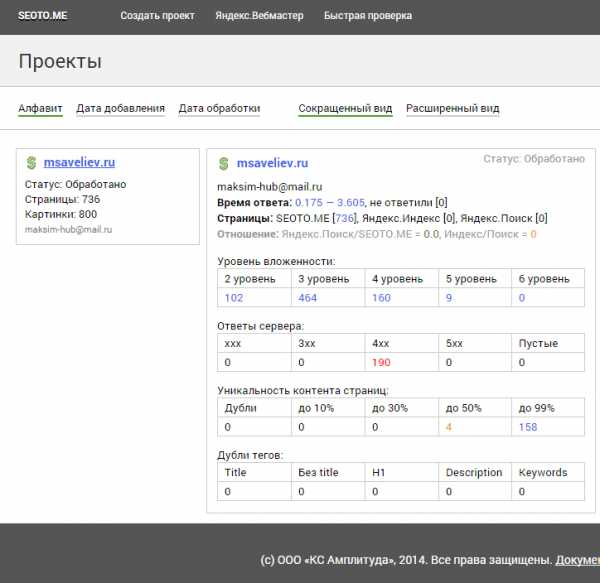

Прежде всего необходимо добавить сайт и подключить Яндекс.Вебмастер. Для добавления сайта в очередь на проверку, переходим во вкладку "Создать проект" в поле ввода вводим url анализируемого сайта и ждем несколько минут. Буквально через 2-3 минуты Вы получите уведомление об успешной проверке сайта - результат проверки Вы сможете посмотреть на главной вкладке "Проекты". По желанию Вы можете настроить отображение сайтов, как в сокращенном виде, так и в полном + если Вы в систему добавляете множество сайтов, их всегда можно отсортировать по "Алфавиту" или "Дате добавления".

Краткое представление о сайтах на вкладке Проекты в SEOTO.ME

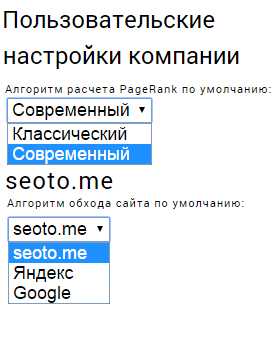

Пользовательские настройки seoto.me

На вкладке "Яндекс.Вебмастер" Вы сможете подключить свой аккаунт для запроса данных из Яндекса.Вебмастера. Оптимальным и безопасным вариантом будет подключение стороннего аккаунта на Яндексе, которому делегированы права на управление из основного. Для этого необходимо в основном аккаунте в Яндекс.ВебМастере зайти в панель управления необходимого сайта и в левой колонке перейти по ссылке "Права на управление", после в поле ввода введите имя пользователя, которому разрешаете права на доступ к сайту через Яндекс.ВебМастер. Нажмите кнопку "Делегировать права". Затем зайдите в сторонний аккаунт и добавьте сайт в Яндекс.ВебМастер, после выполнения данной процедуры в обоих аккаунтах будет доступ к данным сайта через Яндекс.ВебМастер. После этого в SEOTO.ME на вкладке "Яндекс.Вебмастер" введите логин и пароль стороннего аккаунта, чтобы система смогла авторизоваться и запрашивать данные о сайте.

Просмотр сайта и поиск ошибок

На вкладке "Проекты" перейдите в уже добавленный и просканированный сайт, перед Вами откроется страница с отчетом о страницах, тегах, картинок, ссылок, редирект и прочую информацию. В отчете Вы полностью получите такие данные, как наличие слишком длинного описания страницы, а так же заголовков, посмотреть к каким картинкам есть описание, а к каким нет; проверить процентное отношение уникальности контента на страницах сайта; посмотреть дубли страниц, а так же наличие ссылок - внутренних, внешних, dissalow .

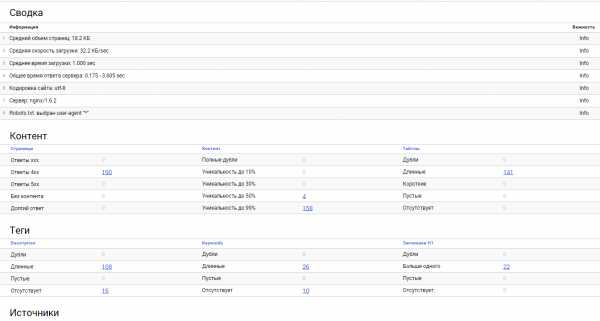

Отчет проверки сайта

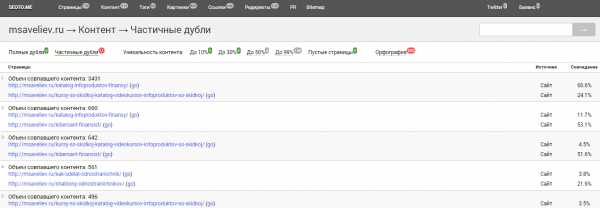

К примеру, отчет о частичных дублей страницы, показывает процент совпадения между двумя страницами, так же можно посмотреть наличие орфографических ошибок, уникальность контента, есть ли пустые страницы.

В подробном отчете Вы сможете посмотреть PR каждой страницы, включая статус индексирования (no index) и вложенности страницы. Просмотреть внутренние и внешние ссылки, а так же битые ссылки, как внешние, так и внутренние. (При использовании редиректа возможно большое наличие внутренних битых ссылок)

С помощью сервисы, Вы можете построить Sitemap.xml карту сайта , где выбрать самостоятельно, какие страницы необходимо исключить из карты.

Видео от разработчиков

msaveliev.ru

Самые страшные ошибки в SEO

Некоторые ниже перечисленные ошибки являются очень грубыми и могут приводить к санкциям со стороны поисковых систем, другие же — помягче, но тоже не дающие выйти сайту в топ по нужным запросам. В любом случае каждая из перечисленных ошибок может привести к снижению трафика в разы. Поэтому очень внимательно изучите этот раздел и бойтесь как огня допустить эти ошибки.

- Переспам. Это, пожалуй, самая грубая из всех ошибок поисковой оптимизации сайта. Некоторые оптимизаторы стараются перенасытить страницы продвигаемыми ключами. Они добавляют их по несколько раз в метатеги, заголовки, а в тексте ключ может встречаться у них десятки раз во всех склонениях, часто полужирным шрифтом или с подчеркиванием. Ну и в завершение они добавляют на страницу множество внутренних ссылок, угадайте каких, — с вхождением продвигаемого ключа. В итоге, страница больше похожа на созданную для поисковых систем, чем для человека.

Что об этом думает Яндекс? Читаем в блоге Яндекса: «Как мы уже писали, поиск Яндекса отдает предпочтение сайтам, которые созданы для людей и удобны пользователям, и негативно относится к попыткам повышения релевантности страниц за счет чрезмерного употребления в текстах ключевых слов (или целых популярных запросов). Размещение переоптимизированных текстов, которые не адресованы посетителям сайта, относится к приемам «псевдооптимизации» и никак не улучшает качество сайта. Если алгоритм определит, что контент создан для влияния на поисковую систему и повышения релевантности, позиции этого документа в выдаче могут ухудшиться».

И это не шутки, поисковые системы очень жестко карают сайт за переспам потерей позиций и выпадением страниц из индекса.

Ниже пример переспамленного текста с блога Яндекса:

«В последнее время проблема переоптимизированных текстов особенно актуальна. Переоптимизированные тексты (которые по-английски можно назвать over-optimized texts или over-optimized content) или тексты с запросами, часто используются для оптимизации сайтов. Переоптимизированные тексты помогают поместить на сайт большое количество ключевиков (ключевых слов, целевых запросов), по которым сайт продвигается. Поэтому сейчас активно используется такая процедура, как продвижение переоптимизированными текстами. Что такое продвижение переоптимизированными текстами, спросите вы. Если вы никогда раньше не пробовали продвижение переоптимизированными текстами, вы все равно наверняка знаете, что это такое».

Случаев фильтрации сайтов за переспам немало. Вот один из недавних примеров с форума Searchengines:

«Подскажите, опытные товарищи. Девелопил сайт, интернет-магазин аксессуаров. Пока сайт разрабатывался (месяца два в индексе был), были позиции по НЧ и шел трафик. Прямо перед запуском, подключением мерчанта (Яндекс.Касса, кстати) сайт выпал из индекса. На письма в саппорт отвечают стандартно: «Наши алгоритмы… работайте над сайтом и т.д.». Добавил тексты (главная, категории, приоритетные бренды), не помогло, тот же ответ от платонов. Сайт — чистый екомерц, 5000 позиций товаров, свой чекаут и т.д. По совету отправил сайт на апрув в Яндекс Каталог, получил ответ: «По оценке редакции сайт переоптимизирован». Хотя, на мой взгляд, все ОК, тайтлы человеческие более чем. Из стремного — только динамическая перелинковка на страницах товара. В ней может быть дело?»

Опытные товарищи тут же разобрались, что дело в жестком переспаме текстов продвигаемыми ключами. Например, фраза «солнцезащитные очки» встречалась в коде одной страницы 181 раз!

Переспам ключей в тексте на продвигаемой странице

Поэтому оптимизируйте-оптимизируйте, но не переоптимизируйте. Нескольких повторов продвигаемой фразы в тексте страницы вполне достаточно. Главное, чтобы текст был для людей, а не для поисковых систем.

- Слабая оптимизация страницы. Противоположная ошибка хоть и не приводит к санкциям, но делает невозможным выход сайта в топ по конкурентным ключам. Довольно часто, продвигая страницу, оптимизаторы не добавляют ключи в метатеги, заголовки, а иногда точных вхождений нет даже в тексте страницы. И как мы с вами уже увидели на примере конкретных кейсов, одна лишь внутренняя оптимизация страниц может увеличить трафик сайта в разы.

- Слишком много продвигаемых ключей на страницах. Чтобы сэкономить свои силы и время, некоторые оптимизаторы продвигают главную страницу сразу по всем конкурентным фразам. Примерно так же дело обстоит и с внутренними страницами: вместо того чтобы подготовить для каждого ключа или группы из нескольких ключей отдельную оптимизированную страницу, они создают 2-3 страницы, которые продвигаются по нескольким десяткам ключевых фраз.

В результате заточить страницу под конкретные ключи не получается, что ослабляет позиции сайта. Более того, посадочные страницы слабо отвечают на вопрос посетителя, пришедшего с поисковой системы, так как они содержат слишком много разной информации. Опять же мешает отсутствие заточки под конкретные ключи. Поэтому посетители приходят на страницу, закрывают ее и ухудшают этим поведенческие факторы, что еще ниже опускает сайт в выдаче.

Правильным выходом было бы создание специальных разделов и страниц, которые четко и точно заточены под один или несколько смежных ключей и дают исчерпывающий ответ на вопрос пользователя.

Кстати, по словам SEO-консультанта Лены Камской, эта ошибка является самой распространенной среди всех ошибок оптимизаторов.

- Ошибки структуры сайта (дубли, мусорные страницы и т.д.). Поисковые системы настолько не любят дубли страниц, точные или частичные, что зачастую из-за них снижают позиции сайта в поиске. Дубли обычно плодят CMSсайтов при неправильной настройке: Joomla, WordPressи многие другие. Главная страница сайта может быть доступна по адресу site.ru, а также site.ru/index.html и site.ru/default.html. Для пользователей это одна и та же страница, а для поисковых систем дубли. Их нужно найти и настроить сайт таким образом, чтобы полностью исключить дубли.

Искать можно через поисковую систему. Для этого ставим галочку поиска по сайту и вставляем в качестве поискового запроса фрагмент текста со страницы в кавычках (кавычки помогают найти точное соответствие). Проверив ряд страниц таким образом, можно понять, создает ли CMS их дубли или нет. Дубли будут видны сразу, когда по уникальному запросу будет отображаться сразу несколько результатов с вашего сайта. Если дубли есть, нужно обратиться к программисту для настройки CMS таким образом, чтобы она не плодила копии страниц.

Кстати, в свое время наш тестовый сайт резко потерял все позиции в Яндексе по основным запросам, и они вылетели из топа в 5-ую сотню выдачи. Причина была проста — ошибка программиста, из-за которой было автоматически создано множество дублей страниц. После устранения этой проблемы позиции вскоре вновь восстановились.

Мусорные страницы — это страницы, которые возникли по технической ошибке, например пустые страницы или страницы с технической информацией, которые не должны отображаться пользователям. От таких страниц нужно избавляться. Чтобы выявить их, можно добавить сайт в Яндекс-Вебмастер и изучить раздел проиндексированных страниц. Из бесплатных инструментов, не требующих регистрации, рекомендуем Линкпад. Там при проверке сайта в разделе «Страницы в индексе» можно увидеть основные страницы и их размер.

Признаком мусорной страницы является ее малый размер. Особенно обратите внимание на страницы размером менее 3 кб, именно они могут быть пустыми или ошибочно созданными. Найдя лишь несколько подобных страниц, остается показать их программисту с тем, чтобы он устранил причины их появления.

Отсутствие страницы с ошибкой 404 — некоторые сайты вместо того, чтобы выдать в ответ на запрос несуществующей страницы 404-ую ошибку, возвращают ответ 200 ОК и отображают какое-то содержимое или совершают 302-ой редирект. Это неправильно, так как заставляет поисковые системы считать, что страница существует. Даже из-за такой мелочи ранжирование сайта может ухудшаться.

Поэтому проверьте ответ сайта на запрос к странице, которой точно нет на сервере. Рекомендуем использовать для этого сервис BertaL Если в ответ на запрос несуществующей страницы на вашем сайте типа site.ru/test404.html, а также несуществующего домена типа test.site.ru сервер не вернет 404-ую ошибку, необходимо обращаться к программисту для устранения проблемы.

Большое количество сквозных динамических блоков на странице — это болезнь интернет-магазинов, когда на странице отображается чуть-чуть текста, касающегося данного товара или товарной категории, и множество информации в динамических блоках: похожие и рекомендуемые товары, последние отзывы и прочее… Иногда содержимого динамических блоков в разы больше, чем основного контента страницы. Продвижение таких страниц — это проблема, потому что происходит растворение основного контента неосновным.

Плюс к этому, динамические блоки на разных страницах могут выдавать примерно одинаковое содержание, а это уже дублирование контента, которое приводит к снижению позиций таких страниц.

Если эти блоки формируются на лету при помощи аякса, то есть сначала страница загружается, а потом скрипты подтягивают содержимое блоков, то проблем нет. В этом случае эти блоки вообще не будут проиндексированы (помните разговор о скриптах?).

Но если содержимое блоков есть в HTML-коде, то они будут проиндексированы, а следовательно, нужно работать с ними так, чтобы не создавались дубли контента и не размывалось основное содержимое страниц.

- Формирование основного контента на лету при помощи javascript и ajax. Эта ошибка, как правило, встречаетсяна самописных сайтах. Ее суть в том, что основной контент формируется после открытия страницы пользователем.

Чем это плохо? Поисковые системы, как правило, не запускают скрипты на сайте. Они видят страницу без тех текстов, которые подгружаются скриптами. И хотя представители Гугла заявляют, что научились хорошо работать с ява-скриптом, наш опыт показывает, что пока это не соответствует действительности. Если основное содержимое подтягивается скриптами, то поисковики будут видеть страницу без основного содержимого. Тогда ни о каком продвижении страницы не может идти и речи. Необходимо, чтобы весь основной контент загружался сразу, а не при помощи скриптов.

- Исходящие ссылки на плохие сайты — в Советах вебмастеру от Яндекса сказано, что поисковик старается неиндексировать или не ранжировать высоко «немодерируемые форумы, доски объявлений, содержащие большоеколичество ссылочного спама». Такие сайты действительно очень быстро вылетают из индекса из-за спам-ссылок.

В группе риска блоги или другие сайты, где посетители или сам владелец сайта размещает ссылки на плохие сайты.

Ни в коем случае нельзя ставить ссылки на дорвеи (автоматически сгенерированные страницы и сайты, созданные только для сбора поискового трафика и для редиректа его на какие-то другие площадки), фишинговые сайты (сайты, созданные для воровства персональных данных). Нужно избегать ссылок на порносайты, а также любые другие сайты, которые кажутся вам сомнительными.

Если любой пользователь может добавить на сайт ссылку, то позаботьтесь о том, чтобы все ссылки шли с атрибутом rel=nofollow, например <a href=»site.ru» rel=»nofollow»> Xоpоший сайт</a> Этот атрибут запрещает поисковой системе переходить по ссылке. Попросту говоря, она не учитывается поисковиками, хотя у оптимизаторов на этот счет есть обоснованные сомнения. В любом случае ответственность за такую ссылку при помощи rel=»nofollow» вы с сайта снимаете.

В частности, Гугл рекомендует использовать этот атрибут для ссылок в ненадежном (пользовательском) контенте: «Если вы не можете или не хотите поручиться за содержание страниц, на которые ведут ссылки с вашего сайта (например из комментариев пользователей), следует вставлять в теги таких ссылок rel=»nofollow». Это сократит количество спама и поможет исключить непреднамеренную передачу значения PageRank с сайта недобросовестным пользователям».

Итак, не ссылайтесь на плохие сайты либо используйте атрибут rel=nofollow, когда нет возможности проверять сайты.

- Агрессивная реклама — кто бы мог подумать, что за рекламу на сайте могут быть какие-то санкции! И, тем не менее, это реальность. Яндекс, описывая сайты, которые подлежат исключению или понижению в поиске, в своих рекомендациях упоминает «сайты, основным предназначением которых является агрессивная демонстрация рекламных материалов (в том числе popup, popunder, clickunder)». Аналогичного подхода придерживается и Гугл, поэтому мы настоятельно рекомендуем не использовать рекламу, которая вызывает открытие каких-то дополнительных окон.

Кроме того, лучше забыть о показе на своем сайте шокирующей рекламы и рекламы для взрослых. В блоге Яндекса об этом написано следующее: «К такой рекламе относятся, например, тизеры с фотографиями болезней, изображение частей тела людей с сильно избыточным весом, реклама, в которой используются картинки с явно выраженным эротическим содержанием, кадры из фильмов ужасов и тому подобное… В связи с вышесказанным в Поиске будет постепенно внедряться механизм, который отдает предпочтение страницам, не содержащим шокирующей рекламы…»

Вот еще характерное сообщение от Яндекса на тему рекламы: «Наверняка вы хотя бы раз замечали на сайтах всплывающие окна, похожие на уведомления от социальных сетей, предложения по обновлению ПО или сообщения от «антивирусов» о заражении… Теперь Яндекс умеет определять сайты с подобным контентом, и в ближайшее время их позиции в результатах поиска будут понижены».

Хотите узнать еще один простой способ ухудшить ранжирование сайта? Для этого нужно разместить на нем слишком много рекламы. К примеру, Гугл борется с этим с помощью своего алгоритма Page Layout, накладывая так называемый фильтр Top heavy на сайты, верхняя часть которых переполнена рекламой. Вот что об этом сообщает Мэтт Каттс, ведущий инженер Гугл по борьбе с поисковым спамом: «Мы понимаем, что размещение рекламы в верхней части сайта характерно для многих веб-ресурсов, поскольку именно такие объявления заметны пользователю и являются основным источником дохода для издателей. Вот почему фильтр не будет понижать в ранжировании те сайты, которые публикуют рекламу «в разумных пределах». Основной удар придется на сайты, изобилующие рекламой, где пользователь с трудом находит оригинальный контент. Не пройдет и распространенный прием, когда оригинальный контент, размещенный в видимой верхней части сайта, настойчиво направляет пользователя ниже к огромным блокам рекламных объявлений».

Поэтому нужно относиться к рекламе на своем сайте очень осторожно, избегая назойливой, надоедливой, шокирующей рекламы, а также не допуская избытка даже допустимой рекламы на страницах.

Избегая перечисленных выше ошибок и выполняя все рекомендации раздела по поисковой оптимизации, можно добиться потрясающих результатов в продвижении любого сайта. А теперь давайте подытожим и вспомним самые важные моменты, касающиеся внутренней оптимизации итоги

spec-seo.com